В современном цифровом мире поисковые боты играют ключевую роль в обеспечении доступности информации на веб-сайтах для пользователей. От эффективности их обхода зависит, насколько полно и точно будут индексироваться страницы, что оказывает непосредственное влияние на ранжирование сайта в поисковой выдаче. Понимание того, на какую глубину боты заходят в структуру сайта, становится необходимым для владельцев ресурсов, стремящихся максимально использовать потенциал органического трафика. Глубина обхода сайта ботами — это параметр, который определяет, насколько далеко от начальной страницы или страницы входа бот будет следовать по ссылкам внутренней структуры сайта. Поисковые системы не обходят сайт бесконечно глубоко: у каждого робота есть собственные алгоритмы и ограничения на количество посещаемых страниц в одном сеансе, определённые по соображениям оптимизации ресурсов и качества индексации.

Одним из важнейших факторов, влияющих на глубину обхода, является внутренняя структура сайта и качество навигации. Чёткая и логичная организация ссылок, позволяют ботам добираться быстрее до целевого контента и обходить сайт максимально эффективно. Глубокая вложенность страниц, а также большое количество циклических ссылок или дублирующихся URL, напротив, затрудняют процесс сканирования и могут снизить проходимость бота по сайту. Нельзя недооценивать и влияние скорости загрузки страниц. Если сайт работает медленно, боты могут ограничить время и количество обращений, чтобы не перегружать серверы и не тратить ресурсы на длительные загрузки.

Ещё один важный аспект — наличие файла robots.txt и соответствующих метатегов. Они играют роль фильтра, указывая ботам, какие разделы сайта можно обходить, а какие — запрещены для индексации. Правильно настроенные директивы помогают не только экономить ресурсы ботов, но и защищать конфиденциальные данные. Возьмём, к примеру, данные по активности одного из известных SEO-ботов — AhrefsBot.

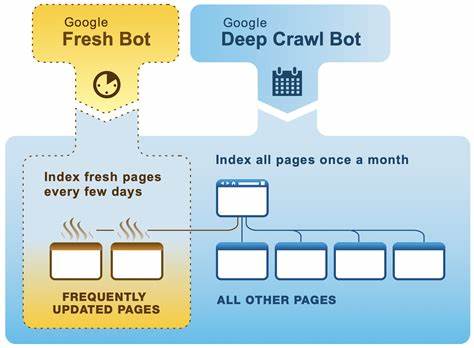

Анализ логов показывает, что данный робот способен обходить сайты на глубину свыше 900 уровней, переходя с одной страницы на другую, даже в условиях сложной структуры. Это говорит о том, что современные боты обладают высокой вычислительной мощностью и алгоритмической гибкостью, позволяющей им проникать глубоко в структуру ресурсов. Однако все поисковые боты различаются по своим стратегиям обхода. Googlebot, Bingbot, Baiduspider и другие имеют уникальные особенности и требования. Например, Googlebot обычно уделяет внимание качеству контента и уделяет меньше времени плохопродуктивным или плохо структурированным страницам.

Поэтому владелец сайта должен стремиться к тому, чтобы все важные страницы были хорошо связаны с главной страницей или другими популярными разделами. Практический совет для владельцев сайтов — проводить регулярный аудит ссылочной структуры и выявлять страницы, которые труднодоступны для ботов. Поддержка карты сайта в формате XML помогает искать и индексации контент, даже если он расположен на большой глубине. Использование внутренних ссылок с ключевыми словами в анкорах увеличивает релевантность и способствует более активному обходу. Кроме того, стоит обращать внимание на качество внешних ссылок.

Боты часто следуют за ссылками с авторитетных ресурсов, что способствует быстрому и глубокому обходу. Наличие качественного входящего ссылочного профиля может стимулировать поисковиков к более активному изучению сайта. Технические ограничения, такие как ограничения на количество одновременных запросов и crawl budget, вынуждают ботов оптимизировать свою работу, проходя только наиболее важные и ценные страницы. Важно обеспечить, чтобы наиболее коммерчески значимые или информационно ценные страницы располагались ближе к началу и имели доступные пути обхода. Защита сайта и предотвращение чрезмерной загрузки серверов — ещё один важный аспект.

Излишняя глубина обхода иногда может привести к DDoS-эффекту со стороны чрезмерно активных ботов. В таком случае рекомендуется использовать инструменты ограничения скорости и настроить правила в файле robots.txt для управления интенсивностью обхода. Отдельно следует упомянуть о современной тенденции работы с динамическим контентом и сайтами на одной странице (SPA). Такие сайты часто требуют дополнительных мер для правильной индексации, например, использования prerendering или серверного рендеринга, чтобы боты могли получить доступ к их контенту, который обычно подгружается динамически.

Резюмируя вышесказанное, можно выделить несколько ключевых рекомендаций для максимального и эффективного обхода сайта поисковыми ботами. Прежде всего, необходимо создавать и поддерживать логичную, гибкую и понятную структуру внутренних ссылок. Скорость загрузки страниц и корректное управление роботами через robots.txt и метатеги существенно влияют на качество индексации. Специальные карты сайта помогают ботам быстро находить все важные разделы, особенно если сайт большой и включает множество страниц.

Постоянный мониторинг логов и анализ поведения ботов позволят своевременно выявлять проблемы с обходом и устранять их. Также следует помнить, что глубокий обход напрямую связан с доступностью сайта, качеством контента и авторитетом ресурса. Чем лучше эти параметры, тем вероятнее, что бот будет сканировать сайт основательно и с максимальной глубиной. Оптимизация сайта с учётом принципов поиска и обхода ботами — это эффективный способ увеличить трафик, повысить позиции в поисковых системах и обеспечить лучшее взаимодействие с целевой аудиторией. Регулярное обновление контента, устранение технических ошибок и информирование поисковых систем обо всех изменениях — обязательные составляющие успешной стратегии SEO в условиях современной конкуренции.

Таким образом, чтобы понять, насколько глубоко боты сканируют сайт, необходим комплексный подход, включающий технические, содержательные и структурные аспекты веб-ресурса. Управление этими параметрами позволит достигать максимального эффекта от индексации и улучшить видимость сайта в интернете.