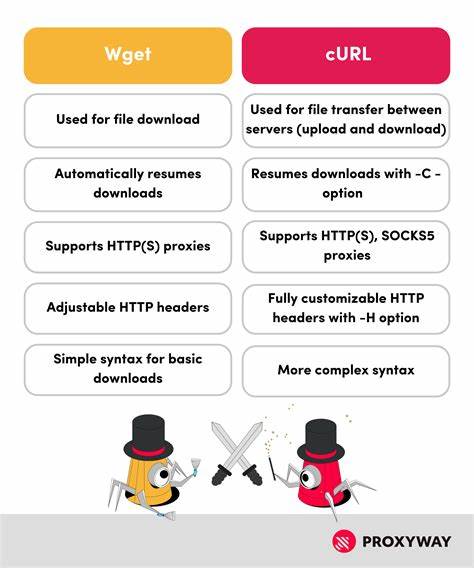

С выходом новых версий Fedora и изменением политики поставки пакетов многие пользователи столкнулись с необходимостью перехода от wget к curl. Этот переход обусловлен переходом Fedora с классического wget на wget2, который вызывает спорные впечатления у сообщества. По этой причине многие администраторы и разработчики начинают все чаще использовать curl в силу его гибкости и широких возможностей. В данной статье подробно рассматривается опыт и рекомендации по переходу на curl, уникальные особенности инструмента и как максимально эффективно перенести привычные задачи wget на этот мощный и распространенный инструмент. Исторически wget был неотъемлемой частью инструментов каждого пользователя Linux, позволяя скачивать файлы из интернета с помощью удобных и простых команд.

Его способность автоматически следовать редиректам, восстанавливания загрузок и работать с различными протоколами сделали его крайне популярным. Однако разработка wget зашла в новую фазу — появилась версия wget2, стремящаяся модернизировать и улучшить утилиту. Тем не менее многие пользователи, в том числе и в Fedora, обнаружили ухудшение поведения и менее комфортный вывод данных в wget2 по сравнению с классическим wget. Это подтолкнуло к поиску альтернатив и выбора curl как более универсального инструмента для загрузок. Curl давно является мощным и гибким инструментом, который не только может скачивать файлы, но и служит основой для сложного взаимодействия с протоколами HTTP, HTTPS, FTP и многими другими.

Хотя у curl другой синтаксис по сравнению с wget и привыкнуть к нему бывает непросто, он предлагает широкий спектр опций, которые позволяют воспроизвести большинство функций wget и даже расширить их. Первые трудности при переходе обычно связаны с тем, что wget интуитивно и лаконично справляется с базовыми задачами — например, командой wget URL пользователи загружают файл, а при использовании параметров такие штатные возможности, как следование редиректам, выставляются по умолчанию. В curl же за следование редиректам отвечает ключ -L, без которого программа может просто вывести содержимое страницы с HTTP-редиректом. По этой причине основной командой для скачивания файла с curl будет что-то вроде curl -L -O URL, где -O означает сохранение файла с именем, полученным с сервера, что можно сопоставить с wget. Важным моментом выступает возможность загрузки нескольких файлов одновременно.

Если wget позволяет просто перечислить ссылки, то curl требует подхода с опцией --remote-name-all для сохранения всех скачиваемых файлов под их оригинальными именами без необходимости перечислять -O по каждой ссылке. Это стоит учитывать при адаптации старых скриптов и автоматизации. Еще одна полезная группа опций curl — отображение информации об HTTP-заголовках. В wget можно вывести заголовки с помощью опции --server-response, тогда как curl для этого предлагает -i, которая добавляет заголовки в вывод, либо -I для получения только заголовков без тела ответа. Таким образом, если требуется посмотреть, как сервер отвечает на запрос, curl проявляет гибкость в этих командах.

В то же время curl не имеет встроенного механизма условного показа заголовков только при ошибке, что порождает необходимость создания собственных оберток или скриптов для подобных случаев. В дополнение, интересной возможностью является параметр -J для разрешения curl доверяться серверу в части имени скачиваемого файла, что аналогично wget --trust-server-names. Это бывает важно, когда URL файла не отображает явно имя, а сервер отвечает с заголовком Content-Disposition, содержащим рекомендованное имя. Также, опция -R в curl позволяет выставить время изменения локального файла в соответствии с серверным, что бывает полезно для синхронизации и кэширования. Стоит упомянуть полезный проект wcurl — небольшой скрипт-обертка, который позволяет использовать curl с интерфейсом, похожим на wget.

Это помогает быстрее адаптироваться к изменениям и сохранить привычные команды при условии, что скрипт доступен в системе. Однако на момент текущей модернизации wcurl не всегда входит в стандартные репозитории большинства дистрибутивов, включая Ubuntu 24.04, что ограничивает его универсальное применение. Тем не менее в перспективе ожидается его включение в более свежие версии, что значительно упростит жизнь пользователям, особенно тем, кто привык к wget. Адаптация рабочих процессов и старых скриптов требует внимательного подхода к различиям в поведении wget и curl.

Например, wget по умолчанию может создавать каталог с вложенными папками и поддерживает режим возобновления скачивания, а curl для возобновления использует -C -. Для сохранения привычной структуры часто приходится комбинировать несколько опций. При этом код, основанный на wget, может потребовать значительной переработки, чтобы стать устойчивым с использованием curl. Необходимо понимать, что Fedora идет в ногу с upstream, предлагая пользователям обновленные версии ПО, даже если они могут вызвать временные неудобства. Такой подход стимулирует сообщество к быстрому освоению новых инструментов и их возможностей.

Для многих это повод для повышения мастерства и своевременного обновления знаний, что особенно актуально для системных администраторов и разработчиков. По опыту пользователей, которые уже успешно перешли на curl, можно отметить улучшение контроля над процессом загрузки, расширенные возможности работы с протоколами и интеграции в сложные пайплайны автоматизации. Однако, чтобы освоить все тонкости curl, рекомендуется изучать официальную документацию, использовать практические примеры и даже писать собственные небольшие скрипты-обертки для частых операций. Подводя итог, переход с wget на curl в Fedora — это не просто смена команды. Это шаг к более гибкой, универсальной и мощной работе с загрузками из интернета, который требует времени на изучение и привыкание.

Тем не менее преимущества curl очевидны — от расширенных настроек до возможности интеграции с разными языками программирования и системами контроля. Для тех, кто сталкивается с необходимостью перехода, следует помнить о ключевых опциях curl: -L для следования редиректам, -O для сохранения имен файлов, -J для доверия серверу в выборе имени, -R для установки временной метки, а также -i и -I для работы с заголовками. Применение этих опций и их комбинаций позволит построить рабочие команды, полностью замещающие привычные wget-подходы. В будущем можно ожидать, что curl продолжит активно развиваться вместе с экосистемой Linux, сохраняя статус одного из самых универсальных инструментов командной строки. Важным направлением будет оптимизация удобства использования и создание готовых решений уровня wcurl, которые помогут сделать переход более плавным для широкой аудитории.

Таким образом, смена wget на curl в Fedora — не только необходимость, продиктованная контекстом дистрибутива, но и шаг к освоению более гибких возможностей управления загрузками. Освоение curl расширит инструментарий и позволит эффективно решать самые разные задачи, связанные с сетевыми операциями.