Современный мир искусственного интеллекта активно развивается, и большие языковые модели (LLM) становятся неотъемлемой частью множества приложений. Чтобы создавать эффективные и надежные решения на их основе, разработчикам необходимы инструменты, которые помогут не только построить функциональные рабочие процессы, но и обеспечить качественный мониторинг и отладку. Среди таких инструментов выделяются LangChain и Langfuse, которые часто сравнивают, пытаясь определить, какой из них лучше подходит для конкретных задач. Однако понимание их ключевых отличий позволяет не просто выбрать одно решение, а грамотно интегрировать оба для достижения максимальной эффективности разработки. LangChain можно представить как основу, каркас или электрическую проводку вашего дома — оно соединяет различные компоненты, обеспечивая их правильное взаимодействие.

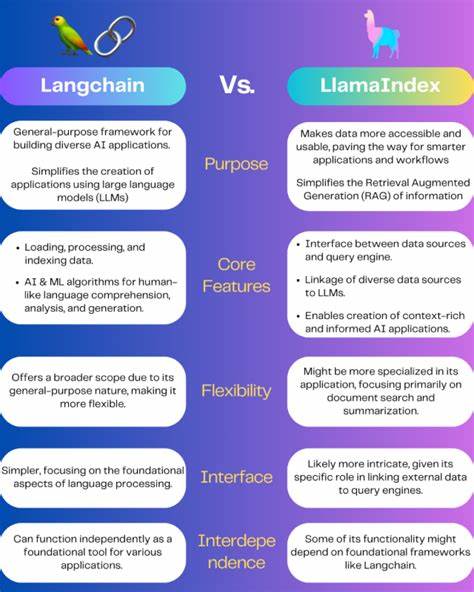

Этот фреймворк сосредоточен на управлении рабочими процессами, создании цепочек вызовов больших языковых моделей и взаимодействии с различными данными и инструментами. Важной особенностью LangChain является возможность работать с множеством компонентов: чат-моделями, подсказками, цепочками вызовов и агентами, которые можно легко комбинировать, используя собственный язык выражений — LangChain Expression Language (LCEL). Главное преимущество LangChain — это его модульность и гибкость. Разработчик может создавать рабочие процессы из небольших, независимых блоков, которые обрабатывают конкретные задачи, будь то извлечение контекста из базы данных с помощью методов извлечения (retrievers) или запуск диалогов с моделью. Такой подход значительно облегчает тестирование каждой части отдельно и оптимизацию процессов, что критично для сложных приложений с множеством взаимозависимых вызовов LLM и интеграцией с внешними хранилищами данных.

Многие разработчики отмечают удобство интерфейса Runnable в LangChain, который позволяет строить сложные цепочки из простых шагов, понимающих формат входных данных и формирующих предсказуемый выход. Это помогает контролировать сложность, которая неизбежно растет при масштабировании приложений и внедрении дополнительных слоев, например, нейросетевых эмбеддингов для поиска релевантных документов. Еще одним значимым аспектом LangChain является возможность легко менять модели, базы данных и другие компоненты без необходимости полностью переписывать существующую архитектуру. Такое качество особенно ценно для компаний, которые хотят быстро адаптироваться к новейшим достижениям в сфере искусственного интеллекта и заменять устаревшие модули на более современные решения. С другой стороны, Langfuse — это инструмент, ориентированный на наблюдаемость, отладку и улучшение уже созданных LLM-приложений.

Он не конкурирует с LangChain, а дополняет его, специализируясь на визуализации и анализе поведения моделей, отслеживании запросов и ответов, а также выявлении таких проблем, как галлюцинации и неожиданные реакции. В процессе эксплуатации LLM сложно разобраться в нюансах каждого шага вызова, особенно если приложение состоит из множества последовательных и параллельных запросов. Без надежного механизма трассировки и логирования встречаешься с трудностями: длинные и запутанные логи не дают ясной картины, а попытки изменения параметров могут приводить к непредсказуемым регрессиям. Langfuse предлагает визуализированные трассы взаимодействий на уровне отдельных вызовов, позволяя разработчикам быстро выявлять узкие места и тестировать гипотезы. Кроме того, Langfuse позволяет структурировать данные взаимодействий пользователей с моделями, превращая их в полезные наборы для автоматизированной оценки качества.

Центральное управление подсказками и возможность аннотирования ответов создают условия для непрерывного улучшения приложений и точной настройки моделей под реальные сценарии использования. Использование Langfuse помогает принимать более обоснованные решения об изменениях в архитектуре и управлении подсказками, а также контролировать затраты и производительность моделей. Наличие удобных дашбордов с ключевыми метриками делает работу с LLM более прозрачной, упрощая процесс диагностики и оптимизации. Хотя Langfuse идеально подходит для случаев, когда уже есть готовое архитектурное решение с LLM, а нужно лишь внедрить надёжный слой наблюдаемости и отладки, для комплексных проектов, требующих построения многоступенчатых рабочих процессов, обычно целесообразно использовать обе платформы совместно. LangChain выступает инструментом оркестрации и создания архитектуры, Langfuse — инструментом анализа и улучшения производительности.

Для тех, кто предпочитает оставаться в экосистеме LangChain, существует альтернативный сервис LangSmith, предлагающий схожие возможности наблюдаемости. Однако Langfuse отличается удобством интеграции с разными архитектурами и гибкостью в работе с уже существующими решениями. Современный AI развивается очень быстро, появляются новые модели с уникальными возможностями, и чтобы не отставать, приложения должны быстро адаптироваться к этим изменениям. Langfuse помогает максимально эффективно использовать новшества, предоставляя инструменты для структурирования взаимодействия с пользователями и автоматической оценки качества моделей. В результате, разработчики получают возможность оперативно корректировать рабочие процессы, опираясь на реальные данные, а не только на догадки.

В заключение, выбор между LangChain и Langfuse не нужно рассматривать как «или-или». Каждый из этих инструментов решает свою важную задачу и вместе они дают разработчикам полноту контроля — от создания стабильно работающих LLM-циклов до тщательного анализа, поиска ошибок и оптимизации работы. Правильное использование обоих решений позволяет существенно повысить качество конечного продукта, сократить время разработки и минимизировать риски, связанные с непредсказуемым поведением моделей. В эпоху, когда проекты на основе больших языковых моделей становятся все более масштабными и сложными, инструменты, подобные LangChain и Langfuse, становятся необходимыми помощниками. Они не просто упрощают техническую часть, но и дают разработчикам возможность лучше понять, как их системы действительно работают в реальных условиях, повышая тем самым результативность и надежность конечных решений.

Если вы занимаетесь разработкой или оптимизацией LLM-приложений, имеет смысл обратить внимание на эти инструменты и интегрировать их в ваш рабочий процесс. Это позволит избежать множества проблем в будущем и сэкономить значительные ресурсы. Профессионалы, уже использующие LangChain и Langfuse, отмечают существенное облегчение своих задач и улучшение качества конечных продуктов, что делает эти платформы незаменимыми решениями в современном AI-ландшафте.