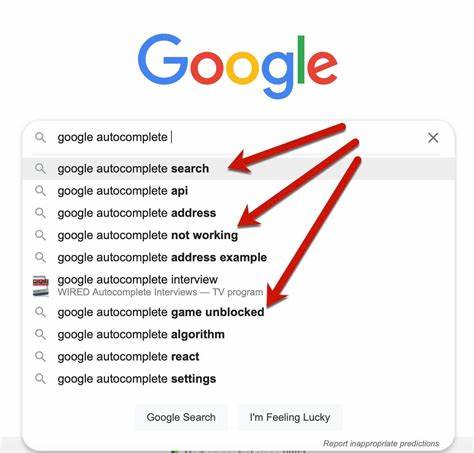

Автозаполнение стало неотъемлемой частью современного пользовательского опыта при поиске информации на сайтах и в приложениях. Эта функция позволяет значительно сократить время ввода, облегчить пользователям поиск и повысить конверсию благодаря релевантным подсказкам. Однако подходы к реализации автозаполнения очень разнообразны, и зачастую разработчикам сложно найти полное техническое руководство, которое объясняет процесс от сбора данных до оптимального отображения результатов. Важно учесть, что для успешной работы автозаполнения требуется не только правильно организовать данные, но и применять эффективные методы анализа языка, а также оптимизировать запросы к поисковой системе таким образом, чтобы обеспечить быстрый отклик и релевантность подсказок. Первым шагом на пути к качественному автозаполнению является осознание целей функции и понимание, что именно ожидают пользователи.

При вводе запроса человек может не знать точных слов или формулировок, отражающих его потребность. Кроме того, пользователь может быть не осведомлен о том, какой контент представлен на вашем сайте. Следовательно, гибкость подсказок должна предусматривать два основных типа результатов: конкретные страницы или документы, а также сами поисковые термины, которые пользователь может использовать. Такая комбинация помогает быстрее направить пользователя к нужной информации, экономя его время и усилия. Для начала работы с автозаполнением на базе Elastic или OpenSearch необходимо сконфигурировать индекс с набором полей, в которых хранится информация, подлежащая поиску.

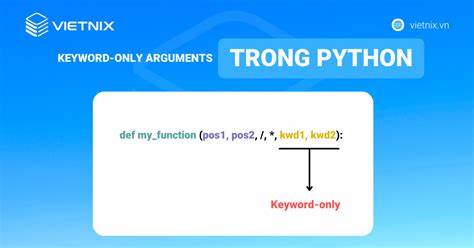

К примеру, при работе с текстовым контентом важно предусмотреть поля для заголовка, описания и основного текста документа. При этом к каждому из этих полей рекомендуется применить соответствующие анализаторы, способные обрабатывать и нормализовать данные перед индексированием, исключая стоп-слова, приводя слова к нормальной форме с помощью стемминга, а также очищая текст от ненужных символов, таких как HTML теги. Одним из ключевых компонентов в конфигурации являются специальные поля, предназначенные для автозаполнения, такие как completion, suggest_word и suggest_phrase. Поле completion помогает быстро находить документы и страницы по префиксу запроса за счет использования edge-ngram токенизатора. Edge-ngram разбивает слова начиная с их первой буквы, формируя префиксные токены, что позволяет существенно увеличить скорость поиска по началу слова без необходимости полнотекстового сканирования.

Однако такой подход требует больше памяти на стороне индекса. Для выделения релевантных слов из коллекции документов применяется suggest_word — поле с менее агрессивным анализатором, в котором используются минимальные преобразования для сохранения читаемости и понятности слов. При помощи агрегирования significant_terms можно выделять значимые, необычные для общего корпуса термины, встречающиеся относительно часто в фильтрованной выборке, что позволяет формировать релевантные подсказки именно для текущего контекста пользователя. Следующий шаг — это работа с сочетаниями слов или фразами для повышения точности подсказок. Для этого создается поле suggest_phrase с использованием шинглов (shingles) — специальных фильтров, формирующих биграммы и триграммы из последовательностей слов.

Такой метод помогает выявить распространенные словосочетания и фразы, которые гораздо чаще отражают реальные запросы пользователей, нежели отдельные слова. Несмотря на то, что при анализе шинглов могут появляться пустые токены на местах удаленных стоп-слов, этот недостаток легко компенсируется постобработкой результатов на стороне клиента. Запросы к поисковому индексу в режиме автозаполнения должны организовываться таким образом, чтобы эффективно использовать возможности каждого созданного поля. Для поля completion можно использовать match query с префиксом, что гарантирует высокую скорость за счет предварительного индексирования токенов edge-ngram. Для suggest_word и suggest_phrase применяются агрегаты significant_terms с параметром include, который задает шаблон соответствия введенного пользователем текста, ограничивая подсказки лишь релевантными вариантами.

Параметр min_doc_count регулирует минимальное количество документов, в которых должен встречаться термин, что помогает фильтровать шум и нерелевантные совпадения. Реализовав все три механизма автозаполнения в индексе, необходимо обеспечить и удобную постобработку результатов на клиентской стороне. Полученные документные совпадения и значимые слова с фразами формируют три группы подсказок для пользователя. Подсказки из документов несут ссылочную информацию и служат направлениями к конкретному контенту. Слова и фразы, в свою очередь, помогают формировать поисковые запросы и облегчают пользователю выбор формулировки при затруднении с выражением.

Для нормализации и устранения дубликатов среди предложенных терминов целесообразно выполнить повторный анализ каждого варианта с помощью того же анализатора, что и на стороне сервера, применяя собственную логику сопоставления и очистки. Благодаря асинхронным вызовам и контролю параллелизма можно поддерживать высокую скорость ответа без блокировки интерфейса. При этом для визуализации удобнее всего формировать объекты с двумя ключами — label и value, где label служит для вывода подсказки, а value содержит URL-запрос или ссылку, на которую можно перейти при выборе. Производительность автозаполнения, как правило, высока и удовлетворяет требованиям пользователей, если время отклика не превышает 50-70 миллисекунд. Стоит помнить, что основная нагрузка ложится на индексирование, где происходит разложение текста на токены, сглаживание и построение синонимических связей.

В отдельных случаях при больших объемах документов необходимо подумать о масштабируемости и оптимизациях за счет кэширования, репликаций и настройки параметров шардирования. Применение описанных техник позволяет создавать эффективные, быстрые и релевантные системы автозаполнения, которые ведут пользователя к нужной информации более интуитивно и экономят время на поиск. Интеграция таких решений возможна не только с Elastic и OpenSearch, но и с большинством современных поисковых движков, поддерживающих пользовательские анализаторы и агрегации. В заключение, грамотная реализация автозаполнения требует комплексного подхода, включающего создание правильной структуры индекса, применение качественных анализаторов для выделения слов и фраз, и организацию запросов, оптимизированных под быстрое нахождение и агрегацию данных. Кроме того, не стоит недооценивать важность постобработки результатов на клиенте для фильтрации, нормализации и удобного отображения подсказок.

Такой подход обеспечивает высокий уровень взаимодействия с пользователем и способствует лучшему восприятию поиска на вашем ресурсе, повышая его привлекательность и эффективность.