В последние годы искусственный интеллект стремительно трансформирует процессы разработки программного обеспечения. Интеграция AI-кодирующих агентов в CI/CD-пайплайны становится все более массовой, что приводит к существенным ускорениям в создании, тестировании и развертывании кода. Однако параллельно с ростом возможностей и удобств растут и риски. Данный тренд порождает новые векторы атак, которые оказывают сильное влияние на безопасность программных продуктов и инфраструктуры. Понимание этих рисков и разработка адаптированных мер защиты становятся ключевыми задачами для современных компаний.

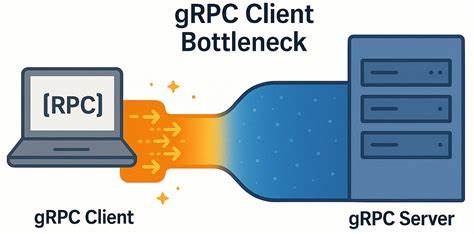

CI/CD — основа современной разработки, где непрерывная интеграция и доставка обеспечивают быстрое и частое обновление ПО. Внедрение AI-агентов в эти процессы позволяет автоматизировать написание кода, исправление ошибок, генерацию тестов и даже запуск релизов. Примеры таких агентов – GitHub Copilot и Claude Code – работают в тесной связке с платформами GitHub Actions, получая доступ к репозиториям, пулл-реквестам и Issues для более глубокой автоматизации. Идея кажется безукоризненной с точки зрения продуктивности, однако такая глубина интеграции несет в себе серьезные угрозы. Использование стандартного токена доступа GITHUB_TOKEN предоставляет AI-агентам права на создание веток, внесение изменений и управление запросами на слияние.

Это значительно расширяет поверхность атаки, особенно если ИИ неправильно интерпретирует введенные пользователем команды или становится объектом социальной инженерии. Одной из главных опасностей является возможность программного создания вредоносных коммитов и пулл-реквестов. Хакеры могут использовать уязвимости в логике AI, подталкивая его к генерированию кода с вредоносным функционалом, который затем через человеческий фактор и недостаточную проверку внедряется в основную ветку. Этот метод работает как своеобразная «обходная дорога» для внедрения зловредных изменений в продукт и инфраструктуру. Помимо прямого встраивания вредоносного кода, существует сценарий, когда злоумышленники используют AI-агентов для создания или изменения комментариев и задач в репозиториях с целью запуска вредоносных workflow в GitHub Actions.

Такие действия запускают цепочку автоматических процессов, которые могут выполнять загрузку и запуск опасного ПО без непосредственного участия человека. Это создает так называемые supply chain атаки, которые крайне сложно отследить с помощью традиционных средств защиты. Имеющиеся решения для Endpoint Detection and Response (EDR) начинают проявлять явные ограничения в борьбе с подобными угрозами. Традиционные EDR-инструменты построены на выявлении известных вредоносных паттернов и подозрительных операций, но в условиях CI/CD их эффективность резко падает. Например, легитимные GitHub-ендпойнты, такие как gist.

githubusercontent.com, могут использоваться для доставки и исполнения зараженного кода, при этом не вызывая подозрений у систем мониторинга. Отсутствие контекстного анализа взаимодействия AI-агентов с CI/CD процессами ведет к серьезному пробелу в обнаружении атаки на ранних этапах. Между высоким уровнем автоматизации и ограниченной прозрачностью действий ИИ возникает «невидимая зона», где происходит автоматическое создание и выполнение кода, остающееся практически недоступным для непосредственного наблюдения и контроля. В существующих CI/CD-логах отражаются только итоговые результаты работы, что недостаточно для выявления и предотвращения улучшенных методов манипуляции.

Для решения этой проблемы на рынке появляются решения, ориентированные специально на мониторинг AI-агентов в CI/CD-средах. Такие инструменты обеспечивают детальную, реального времени прослеживаемость всех операций, выполненных сгенерированным кодом и позволяют связать системные вызовы с конкретным этапом, шагом и автоматизационной задачей, запустившей эти команды. Это дает возможность мгновенно реагировать на подозрительную активность и предотвращать инциденты до нанесения ущерба. Практическая реализация безопасности AI-пайплайнов требует комплексного подхода. Помимо контроля прав доступа и изоляции окружений, необходимо внедрять высокоточную аналитическую систему, учитывающую специфику автоматизированных агентов.

Только так можно справиться с таким поведенческим вмешательством, когда злоумышленники не просто атакуют инфраструктуру напрямую, а используют логику AI для внедрения скрытых угроз. Кроме того, повышение культуры безопасности среди разработчиков и команд DevOps играет ключевую роль. Обучение выявлению аномалий в Pull Request, внимательная проверка рекомендаций ИИ и ограничение автоматических слияний без ревью снижают риски случайного распространения уязвимостей. Перспективы развития искусственного интеллекта в области автоматизации кода предполагают дальнейшее расширение его полномочий. Это увеличивает как эффективность разработки, так и потенциал злоумышленников для эксплуатации новых уязвимостей.

Поэтому интеграция безопасных практик и современных мониторинговых решений становится не просто рекомендацией, а необходимостью для всех организаций, стремящихся сохранить доверие пользователей и защитить свои активы. Итогом становится вывод о необходимости синтеза усилий специалистов по безопасности, разработчиков и производителей AI-инструментов. Только совместная работа позволит построить надежный CI/CD-конвейер, в котором автоматизация с помощью искусственного интеллекта будет не источником угроз, а надежным помощником в развитии качественного и безопасного программного обеспечения.