В последние годы технологии глубокого обучения и искусственного интеллекта произвели настоящую революцию в различных областях. Одним из наиболее обсуждаемых аспектов является использование так называемых дипфейков — реалистичных видеозаписей и изображений, созданных с помощью ИИ. Однако возникновение дипфейков не ограничивается лишь развлекательной сферой. Эти технологии становятся инструментом для злоумышленников, использующих их для обхода систем безопасности, особенно на криптовалютных биржах, что вызывает серьезные опасения в области кибербезопасности. Криптовалютные биржи, где пользователи обменивают цифровые валюты, требуют надежной системы аутентификации для предотвращения мошенничества.

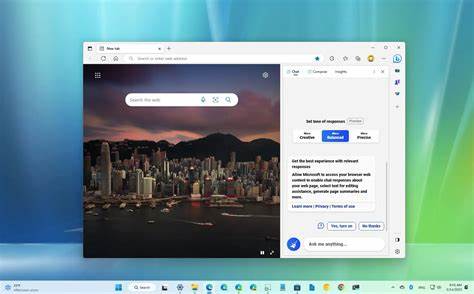

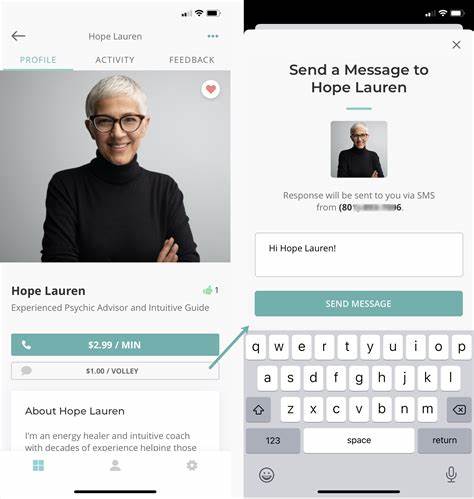

Одним из популярных методов защиты является биометрическая аутентификация, включающая распознавание лиц. Пользователи должны предоставить свои биометрические данные, такие как изображение с веб-камеры, и обычно это сопровождается необходимостью загрузки удостоверения личности, такого как паспорт или водительские права. Эти меры призваны защитить активы пользователей и минимизировать мошеннические операции. Однако с появлением технологий дипфейков эта защита под угрозой. Согласно недавнему исследованию, представленному компанией Cato Networks, злоумышленники находят пути обхода систем распознавания лиц с помощью генеративного ИИ.

Одним из таких высокопрофильных злоумышленников называется ProKYC, который разрабатывает программное обеспечение для создания дипфейков и продает его на теневых рынках. Это ПО позволяет создавать фальшивые удостоверения личности и обманывать системы биометрической аутентификации. Таким образом, новая угроза в мире киберпреступности становится все более актуальной. ProKYC использует технологии генеративного ИИ для создания убедительных изображений несуществующих людей. Эти изображения используются для генерации фальшивых документов, которые затем применяются в процессе регистрации на криптобиржах.

Например, злоумышленник может создать реалистичное изображение лица и с помощью дипфейка показать его в рамках видеозвонка, что сбивает с толку алгоритмы распознавания. Эти алгоритмы, хотя и значительно улучшились в последние годы, все еще могут быть не в состоянии отличить настоящую трансляцию от видео, сгенерированного ИИ, особенно если оно создано с высоким качеством. Данный тип мошеннических атак, известный как создание новых аккаунтов (New Account Fraud), уже привел к значительным финансовым потерям. В 2023 году общие потери от таких атак составили около 5,3 миллиардов долларов, согласно исследованиям компании Javelin Research и AARP. Эти цифры подчеркивают необходимость серьезной защиты криптовалютных платформ от новых угроз.

В ответ на возросшие риски компании, занимающиеся криптовалютами, должны разработать более эффективные методы защиты. Этай Маор, главный стратег по безопасности в Cato Networks, предлагает несколько соображений для противодействия мошенникам. Во-первых, компании должны внимательно следить за качеством видео, которое поступает в их системы. Специалисты могут выявить отличительные черты, характерные для видео, сгенерированных ИИ, поскольку они часто имеют более высокое качество, чем стандартные изображения, полученные с обычной веб-камеры. Кроме того, необходимо обращать внимание на возможные сбои и артефакты в AI-сгенерированных видео.

Это может включать нерегулярности в выражениях лиц, особенно в области глаз и губ, которые зачастую могут выдать фальшивку. Сбор threat intelligence, то есть информации о возможных угрозах, также становится важным шагом для защиты от новых методов мошенничества. Тем не менее, очень важно найти баланс между жесткими мерами безопасности и удобством пользовательского опыта. Слишком строгие условия аутентификации могут привести к ложным срабатываниям, что, в свою очередь, может вызвать недовольство пользователей. В то же время недостаточная бдительность может уложить дорогу для мошенников, и это создает огромную дыру в безопасности.

В дополнение к борьбе с мошенничеством, экспорт дипфейков также вызывает широкий спектр этических вопросов. С одной стороны, технологии дипфейков могут использоваться для законных целей — в киноиндустрии, образовательных материалах, а также для создания визуального контента. С другой стороны, их использования в мошеннических схемах и дезинформационных кампаниях ставит под угрозу доверие, необходимое для функционирования современного общества. Криптовалютные биржи, стоящие на переднем крае финансовых технологий, сталкиваются с уникальными вызовами. Чем быстрее они адаптируют свои системы к новым угрозам, тем меньшую угрозу они будут представлять как для своих пользователей, так и для системы в целом.