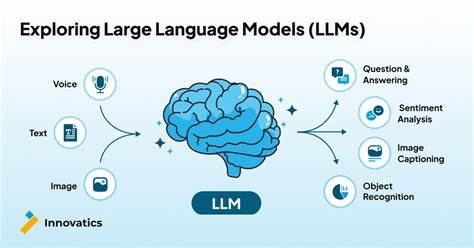

Большие языковые модели (LLM) уже стали неотъемлемой частью современного искусственного интеллекта, демонстрируя впечатляющие возможности в генерации текста, решении сложных задач и поддержке взаимодействия человека с машиной. Однако, несмотря на их успехи, остаются значительные вопросы относительно того, насколько глубоко такие модели понимают свои собственные решения и могут ли они надежно объяснять, почему принимают те или иные ответы. Недавние исследования показывают, что LLM не умеют точно определять свои собственные границы принятия решений, что проявляется в их неспособности генерировать надежные и информативные контрфактические объяснения - особый тип самообъяснения, где модель приводит пример, как измененный вход мог бы привести к другому результату. Такой подход имеет принципиальное значение для повышения прозрачности и доверия к ИИ, особенно при использовании в ответственных областях, где важно понимать логику решений. В рамках тематического исследования, опубликованного в 2025 году, ученые проанализировали способность различных LLM создавать самогенерируемые контрфактические объяснения (SCE).

Результаты были неоднозначными: модели в основном демонстрировали способность создавать корректные объяснения, которые меняли исходное предсказание, однако при этом данные изменения часто были чрезмерными и далеко не минимальными. Это означает, что объяснения не содержали точной информации о критичных для решения факторах, а лишь меняли множество аспектов входных данных, что затрудняет понимание точной причины принятого решения. Более того, когда модели просили создавать максимально минимальные контрфакты - то есть минимально изменять вход для получения обратного предсказания - часто возникала противоположная проблема. LLM давали слишком незначительные изменения, которые не приводили к смене решения, делая объяснение невалидным и вводящим в заблуждение. Этот компромисс между валидностью и минимальностью контрфактов отражает фундаментальную неопределенность в том, как модели "понимают" свои собственные решения.

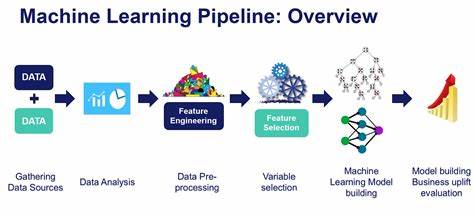

Ведь для настоящего и полезного объяснения требуется не просто изменить результат, но и показать самый существенный и минимально достаточный фактор, влияющий на это изменение. Почему же так происходит? Частично это связано с архитектурой и методами обучения LLM. Они обучаются на огромных объемах текстовых данных, формируя сложные статистические связи, но не обладают явным пониманием границ своих классификаций или решений, так как не оптимизированы для этой цели. Их внутренняя репрезентация и механизм генерации текста не связаны напрямую с формализацией границ принятия решений, что приводит к разрыву между способностью генерировать осмысленные тексты и пониманием сути своих собственных предсказаний. Еще одна причина связана с природой контрфактических объяснений.

Они требуют понимания, какие именно изменения в данных повлияли бы на результат, и должны быть минимальными для предоставления ясной и полезной информации. Однако, без специальной оптимизации на создание именно таких контрфактов, LLM склонны генерировать либо слишком сложные, либо недостаточно радикальные изменения. Эти наблюдения имеют серьезные последствия для использования LLM в высокорисковых сферах - например, в медицине, праве, финансах и других областях, где прозрачность и обоснованность решений критически важны. Если модели не способны предоставить надежные самообъяснения, то доверие к их решениям может оказаться необоснованным, а использование таких моделей без дополнительного контроля и проверки - опасным. Несмотря на сложности, исследователи активно работают над улучшением методов объяснимости ИИ.

Варианты развития включают интеграцию специализированных алгоритмов для извлечения контрфактов с минимальными изменениями, использование моделей, обученных на объяснительных задачах, а также внедрение гибридных подходов, сочетающих статистическое моделирование и формальные методы. Эти направления направлены на создание более глубокого и адекватного понимания решений внутри моделей. Важно также понимать, что современные LLM, несмотря на впечатляющие успехи, по-прежнему остаются инструментами, основанными на вероятностных паттернах, а не на детерминированной логике или понимании причинно-следственных связей. Их объяснения - не всегда гарант прозрачности, а скорее отражение внутренних эвристик и фрагментов данных, что заставляет рассматривать их с осторожностью и использовать в комплексе с другими методами проверки и оценки. В заключение, проблема неспособности LLM адекватно знать и объяснять свои собственные границы решений освещает важный аспект современного развития искусственного интеллекта.

Она подчеркивает необходимость продолжать исследования в области объяснимого ИИ, особенно когда речь идет о применении моделей в критически важных сферах. Понятие и корректное построение контрфактических объяснений играют ключевую роль в этом процессе, и их надежность напрямую влияет на уровень доверия, которое человечество может испытывать к автоматизированным системам будущего. Продвижение в этом направлении не только облегчит взаимодействие между человеком и машиной, но и поможет создавать более этичные, прозрачные и эффективные технологии, которые будут служить на благо общества, минимизируя потенциальные риски и ошибки, связанные с нелинейными и сложными решениями ИИ. Только через глубокое понимание и разработку таких механизмов возможна уверенность в безопасном и ответственном использовании больших языковых моделей в будущем. .