В современном мире искусственного интеллекта большие языковые модели (LLM) становятся ключевыми инструментами для обработки естественного языка и решения сложных задач, связанных с текстом. Одним из главных ограничений таких моделей является ограниченная длина контекста, которую они могут эффективно обработать. Традиционные трансформерные архитектуры сталкиваются с проблемой квадратичного роста вычислительных затрат и памяти при увеличении длины обрабатываемой последовательности. Эта математическая особенность затрудняет использование LLM для анализа и генерации текста длиной более нескольких тысяч токенов, что ограничивает их потенциал в ряде практических применений. Недавно исследователи предложили инновационный метод, называемый ETT (Extend at Test-Time), который обеспечивает расширение возможностей понимания длинного контекста у языковых моделей на этапе инференса без необходимости полной перенастройки модели.

Технология ETT изменяет подход к работе с длинными последовательностями, позволяя моделям с ограниченной длиной контекста обрабатывать тексты длиной, многократно превышающей стандартные лимиты. В основе подхода ETT лежит идея эффективного тонкой настройки параметров модели непосредственно на входных данных, которые разбиваются на небольшие перекрывающиеся подпоследовательности. Такой подход позволяет избежать экспоненциального роста вычислительных ресурсов и памяти, сохраняя при этом качество восприятия и анализа текста. Исследователи провели масштабное тестирование ETT на бенчмарке LongBench, демонстрируя возможность увеличить длину контекста моделей GPT-Large и Phi-2 до 32 тысяч токенов, что составляет расширение в 32 раза по сравнению со стандартным контекстом в 1 тысячу токенов. Результаты показали улучшение точности моделей до 30 процентов, что является значительным прогрессом для задач, требующих глубокой и продолжительной обработки текста.

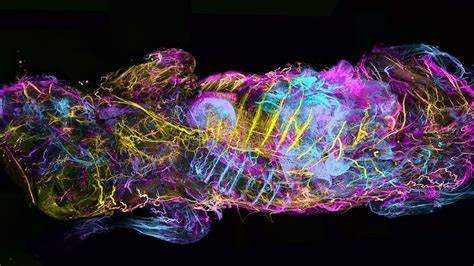

Кроме того, авторы работы провели детальный разбор, чтобы определить, какие именно части архитектуры трансформера приносят наибольшую пользу при тонкой настройке на этапе теста. Выяснилось, что адаптация второго слоя полносвязных нейронных сетей (FFN) внутри модели оказывается более эффективной, чем полная переконфигурация всех параметров, что дополнительно снижает вычислительные затраты и повышает стабильность модели. Такой подход также влияет на способность модели эффективно сохранять информацию о контексте в своих весах. Возможность динамически адаптировать модель к длинному контексту нарушает прежнее ограничение на статическую длину входа и открывает перспективы для приложений, где анализируются длительные документы, статьи, диалоги и технические тексты. Расширение контекста критично в таких областях, как юридический анализ, биомедицинские исследования, научный поиск, а также для создания консультативных систем и сложных чат-ботов.

Метод ETT помогает бороться с проблемами запоминания и обработки информации, которые возникают при больших объемах текста, за счёт оптимального управления ресурсами и интеллектуальной адаптации. Важно отметить, что подход сохраняет совместимость с существующими моделями и не требует их полной переобучаемости или значительных изменений архитектуры, что облегчает внедрение и масштабирование технологии. Возможность дополнительной оптимизации на этапе инференса повышает гибкость и универсальность применения LLM в разнообразных сценариях. В целом, развитие методов расширения контекста, таких как ETT, знаменует важный шаг в эволюции больших языковых моделей. Эти технологии приближают нас к созданию универсальных ИИ-систем, способных работать с большими объемами информации и обеспечивать качественный и контекстно точный анализ.

Интенсивное исследование таких решений в будущем позволит не только увеличить производительность и точность моделей, но и снизить затраты на вычисления, сделать ИИ более доступным и эффективным для широкого круга пользователей. Современная тенденция к интеграции больших языковых моделей в разнообразные сферы требует постоянного повышения их возможностей, и ETT становится мощным инструментом для преодоления существующих ограничений. Вызов увеличения длины контекста в трансформерах остаётся одной из актуальных задач, и инновационный подход, предложенный под названием ETT, может оказаться ключевым элементом в решении этой проблемы. Принимая во внимание результаты, достигнутые командой исследователей, а также перспективы дальнейших улучшений, можно с уверенностью утверждать, что расширение контекста на этапе тестирования становится новым стандартом для повышения эффективности больших языковых моделей и создания более интеллектуальных и отзывчивых систем.

![ZX Spectrum – Introduction To Programming (1983) [video]](/images/F48C57C9-385D-46DD-8199-BFED70B064D5)