В последние годы искусственный интеллект стремительно интегрируется в повседневную жизнь человека. Meta, компания, стоящая за Facebook и Instagram, активизировала запуск собственных AI-сервисов, предлагая чатботы для общения, получения советов и выполнения задач. Однако, как показала практика, часть запросов, которые пользователи вводят в Meta AI, оказывается в открытом публичном доступе, вызывая серьезную тревогу как у специалистов по безопасности, так и у рядовых пользователей. Проблема обнародования AI-запросов не уникальна, но именно Meta оказалась в центре скандала, связанного с тем, что введённые пользователями личные данные и даже конфиденциальная информация становятся доступны другим. Это происходит через публичный ленту запросов, которая автоматически транслирует все или часть вводимых вопросов и команд.

Отчасти это можно объяснить стремлением компании продемонстрировать живость и эффективность своего чатбота, но для большинства пользователей такой подход оказывается совсем не приемлемым. Исторически подобные проблемы с приватностью уже возникали на ранних этапах цифровой эпохи. Одним из знаковых примеров получила широкое распространение история с провалом попытки AOL в 2006 году анонимизировать поисковые запросы своих пользователей. Несмотря на удаление явных личных данных, многие пользователи были быстро идентифицированы благодаря специфическим деталям их запросов, что дало серьёзный урок о сложности процесса деанонимизации данных. На сегодняшний день технологии и методы конфиденциальности остаются в развитии, но этого явно недостаточно при масштабном сборе и публикации данных, особенно таких чувствительных, как запросы к AI, часто наполненные личными переживаниями, интимной информацией и даже юридическими и медицинскими деталями.

Исследования показывают, что достаточно нескольких точек данных, чтобы с большой долей вероятности идентифицировать пользователя, даже если другие идентификаторы удалены. В случае Meta AI пользователи зачастую не осведомлены, что их запросы могут выглядеть словно публичные сообщения, доступные всем и каждому. В таких потоках появлялись всевозможные запросы — от забавных и безвредных, например, вопросы про запахи и простые бытовые темы, до очень серьёзных и потенциально опасных, таких как инструкции по уклонению от уплаты налогов, подробности судебных разбирательств, домашние адреса и другие чувствительные данные. Всё это стало предметом публичного обсуждения после расследований журналистов и специалистов по безопасности. Отсутствие явных предупреждений о том, какие именно данные будут видны публике, приводит к недопониманию и, как следствие, к риску неосознанного раскрытия личной информации.

Более того, если пользователь осуществляет вход в сервисы Meta через AI-приложения, то вместе с запросами могут случайно оказаться оглашёнными и поисковые запросы из других аккаунтов, что ещё сильнее усугубляет проблему. Например, известно, что в подобных ситуациях появлялись данные из Instagram с деликатным содержанием. Этот феномен — лишь верхушка айсберга проблемы, которую можно назвать «эншиттификацией» цифровых сервисов, то есть процессом деградации сервисов и платформ из-за непомерных амбиций владельцев и игнорирования прав пользователей. В центре внимания находится не только техническая сторона, но и корпоративная культура, при которой конфиденциальность пользователей жертвуется во имя маркетинга и роста бизнеса. К сожалению, Meta здесь не является исключением.

Различные примеры «слива» приватных данных пользователями известных продуктов от Strava, Venmo, Etsy и множества других приложений демонстрируют системный характер проблемы в индустрии. Часто компании даже не задумываются о том, что публикуемая информация может иметь негативные последствия, а ограничения и политика конфиденциальности либо размыты, либо неэффективны. Несмотря на все эти вызовы, существуют методики и технологические решения, позволяющие минимизировать риски утечки личных данных при работе с большими массивами данных. Концепция доверенных исследовательских сред (Trusted Research Environments) предусматривает, что исследователи могут получать доступ к обобщённым данным без возможности смотра оригинальных записей, что помогает защитить приватность. Однако такие подходы требуют серьёзного административного и технического контроля, который не всегда реализован в коммерческих сервисах.

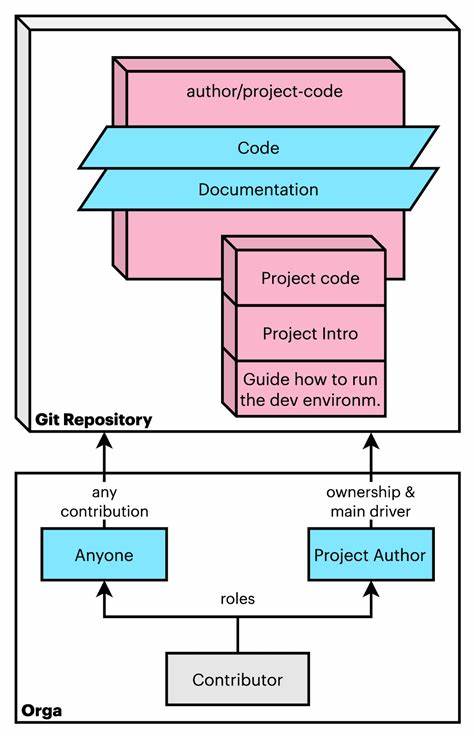

В контексте AI особенно важно понимать, что доверие к сервису и прозрачность работы играют ключевую роль. Защита личных данных должна становиться приоритетом для разработчиков, ведь именно пользователи формируют базу тренировки моделей и предоставляют «сырьё» для обучения искусственного интеллекта. Все попытки создать «привилегии» для AI-конверсий, по сути, направлены на монополизацию данных и закрепление прав доступа для владельцев платформ, что вызывает законные опасения среди правозащитников и разработчиков открытых технологий. Пользователям рекомендуется быть особенно внимательными при вводе личной информации в любые AI-сервисы, особенно если механизм публикации запросов прозрачен и не регулируется. Прежде чем использовать подобные чатботы, стоит изучить условия приватности, а также избегать передачи чрезмерно интимных данных и сведений, которые могут быть использованы в ущерб самим пользователям.

В конечном счёте, ситуация с Meta AI является наглядным примером того, как технологические инновации, несмотря на свою полезность, могут стать источником новых угроз для личной жизни и безопасности людей. Это напоминает о необходимости постоянного баланса между удобством и конфиденциальностью, а также о том, что пользователи, разработчики и регулирующие органы должны вместе работать над созданием цифровой среды, в которой приватность будет уважаться и защищаться на всех уровнях. Поставленная проблема не разрешится мгновенно, но публичное обсуждение и критический анализ действий крупных компаний позволят продвинуться к более безопасному и справедливому цифровому будущему. Meta и другие игроки рынка искусственного интеллекта должны осознать ответственность за обработку данных и пересмотреть модели взаимодействия с пользователями, чтобы вернуть доверие и обеспечить реальную защиту персональной информации. Тем временем пользователям важно развивать цифровую грамотность, учиться осознанно относиться к публикации личных данных, понимать риски и выбирать инструменты, которые действительно защищают их приватность.

Технологии должны оставаться помощниками, а не источником угроз, и только коллективные усилия помогут этого достичь.