Искусственный интеллект (ИИ) и крупные языковые модели (LLM) стремительно развиваются, становясь частью повседневной жизни миллионов людей и предприятий по всему миру. Их способность обрабатывать огромное количество информации, генерировать текст, создавать изображения и даже принимать решения трансформирует множество отраслей — от медицины до финансов. Однако за этой впечатляющей картиной скрывается темная сторона, потенциально способная привести к серьезным последствиям для общества, экономики и безопасности. В последние годы внимание исследователей, экспертов и общественности все чаще обращается на возможные риски, которые исходит от неконтролируемого роста и использования таких технологий. Проникновение ИИ в различные сферы жизни порождает новые вызовы, с которыми мир еще не готов справиться.

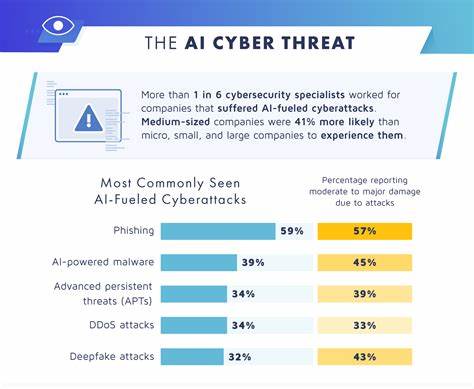

Одним из самых больших опасений является возможность злоупотребления ИИ для создания дезинформации, манипуляций общественным мнением и даже вмешательства в политические процессы. Крупные языковые модели обладают способностью генерировать текст, который трудно отличить от написанного человеком, создавая иллюзию подлинности и доверия. В руках недобросовестных акторов такие технологии могут распространять фейковые новости, подкреплять пропаганду и усиливать информационную войну. Серьезной угрозой становится автоматизация кибератак и создание вредоносного программного обеспечения с помощью ИИ. Новые модели способны помогать хакерам в написании кода, подборе уязвимостей и даже обходе систем безопасности.

Это значительно увеличивает масштаб и скорость проведения атак, усложняя защиту критически важной инфраструктуры и персональных данных пользователей. Другой аспект — этические и социальные последствия внедрения ИИ. Автоматизация приводит к сокращению рабочих мест, особенно в сферах, связанных с рутинными и повторяющимися задачами. Это может вызвать рост безработицы, усиление социального неравенства и создание новых форм несправедливости. Многие эксперты предупреждают, что без адекватных мер поддержки и переобучения сотрудников последствия могут быть катастрофическими для целых сообществ и регионов.

Важно учитывать и вопросы приватности. Крупные языковые модели обучаются на огромных объёмах данных, включающих личную информацию пользователей. Непрозрачность алгоритмов и отсутствие строгих правил обработки данных увеличивают риск утечки конфиденциальной информации и превращение людей в объекты для анализа и манипуляций. Технологии ИИ также вызывают опасения относительно контроля и автономии. Становятся все более реальными сценарии, в которых машины принимают важные решения без участия человека, что ставит под сомнение прозрачность, ответственность и справедливость таких решений.

Возможность появления «черных ящиков» – систем, чья работа непонятна ни пользователям, ни разработчикам – создает угрозу непреднамеренных ошибок и злоупотреблений. Международное сообщество начинает осознавать необходимость регулирования и этических норм в области искусственного интеллекта. Однако разработка глобальных стандартов оказывается сложной и политически чувствительной задачей. Разные страны имеют свои интересы и подходы к развитию и контролю ИИ, что затрудняет коллективные усилия и обмен информацией. В результате риск появления разрозненных систем с разным уровнем безопасности и ответственностью увеличивается.

Впрочем, утрата контроля над развитием ИИ может иметь последствия, выходящие за пределы наших прогнозов. Ученые и футурологи не исключают возможности появления систем с самосовершенствованием, которые перестанут подчиняться человеческому надзору. Хотя это пока сфера спекуляций, игнорировать риск нельзя. Концентрация ресурсов у крупных технологических компаний и государств усиливает дисбаланс и создает предпосылки для монополизации ИИ. Такая ситуация ограничивает равный доступ к технологиям и увеличивает вероятность использования ИИ в целях укрепления власти, усиления кибершпионажа и подавления инакомыслия.

Несмотря на все вызовы, будущее искусственного интеллекта не является предрешенным. Взаимодействие исследователей, правительств, бизнеса и общества открывает возможности для создания безопасных и этичных систем. Основой такой работы должны стать прозрачность алгоритмов, уважение прав человека, контроль и ответственность за применение технологий. Необходимо активизировать усилия по регулированию, а также формированию культуры цифровой грамотности и критического мышления среди пользователей. В конечном итоге искусственный интеллект может стать мощным инструментом для решения глобальных проблем и развития человечества.

Однако только при условии осознанного и взвешенного подхода к его внедрению возможно минимизировать риски и раскрыть весь потенциал новых технологий. Необходимо не забывать, что ИИ — отражение нашего общества, наших ценностей и намерений. От того, каким образом мы научимся управлять этой силой, зависит будущее целых поколений.