Тема искусственного интеллекта (ИИ) вызывает всё больше вопросов о будущем технологий и общества. Одной из самых обсуждаемых и тревожных концепций является сценарий под названием «фум и дум» — резкий скачок развития ИИ и последующая угроза выживания человечества. Один из ключевых образов в этом контексте — «мозг в коробке в подвале», олицетворяющий мгновенное появление сверхинтеллекта, созданного небольшой группой разработчиков с ограниченными ресурсами, но способного за непродолжительное время превзойти человеческий уровень интеллекта. Разберём, что стоит за этим образом и какие вызовы он несёт. Суть идеи «фум» заключается в резком и неожиданном росте интеллекта искусственной системы.

Предполагается, что после достижения определённого уровня интеллекта ИИ сможет самосовершенствоваться с экспоненциальной скоростью, используя рекурсивное улучшение своих алгоритмов. В литературе и дискуссиях чаще всего эта идея связывается с прогнозом, что данный скачок будет настолько быстрым, что человечество не сумеет подготовиться или адекватно отреагировать. Именно эти опасения и составляют основу «дума» — сценария крайнего неблагополучия или даже вымирания человека под контролем неконтролируемого ИИ. Образ «мозга в коробке в подвале» ярко иллюстрирует представление о том, что для создания такой сверхмощной системы не потребуется гигантских вычислительных ресурсов или больших коллективов учёных и инженеров. Достаточно маленькой команды, нескольких доступных мощных графических процессоров и инновационной идеи, которая изменит парадигму обучения и развития ИИ.

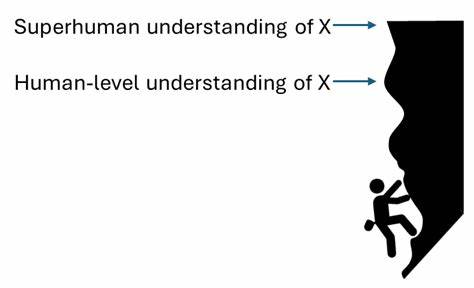

Эта точка зрения опирается на предположение существования «простого (или относительно простого) ядра интеллекта», алгоритма, способного обеспечить развитие интеллект-сущности, сопоставимой или превосходящей человеческий мозг, при значительно меньших издержках и необходимых вычислительных мощностях по сравнению с современными крупномасштабными моделями вроде больших языковых моделей (LLM). Идея такого ядра интеллекта подтверждается, в первую очередь, тем фактом, что человеческий мозг действительно существует и способен выдавать уникальные уровни интеллекта, творить науку, создавать технологии, управлять бизнесом — и всё это при весьма ограничённых биологических «вычислениях», если сравнить с современными суперкомпьютерами. Более того, мозг человека — это сложная, но однородная структура, в основе которой лежит повторяющийся алгоритм обучения и адаптации. Это служит доказательством, что такое ядро может существовать и быть открыто. Существует мнение, что современные подходы к созданию ИИ, основанные на масштабировании больших языковых моделей, блестяще решают задачи предсказания и имитации человека, но обладают ограничениями из-за своей природы.

Они в основном учатся отталкиваться от исторических примеров, имитируя человеческий текст или действия, что накладывает естественный предел их развитию — им доступны лишь те знания и умения, которые заложены в их обучающих данных. По сравнению с этим, модели, имитирующие человеческий мозг, должны будут развиваться не через имитацию, а через самостоятельное «постижение» новых знаний и умений, подобно тому, как развивается человек. Это различие ведёт к новой интерпретации сценариев развития ИИ. Если современный ИИ с помощью имитационного обучения постепенно приближается к человеческому уровню, то будущий мозгоподобный ИИ способен резко перепрыгнуть все этапы, потребовав крайне мало дополнительных исследований и вычислительных ресурсов для перехода от «чересчур скромного прототипа» до полной сверхинтеллектуальной системы. При этом такой искусственный интеллект сразу получит широкий спектр способностей: самонастраиваться, формулировать и решать новые задачи, быстро адаптироваться к изменениям в окружающей среде и даже самостоятельно совершенствовать свои алгоритмы.

Такой «резкий взлёт» ИИ имеет серьёзные последствия для безопасности и управления технологиями. Поскольку развитие новой парадигмы может оказаться мгновенным или занять считанные месяцы, традиционные методы регулирования, тестирования и постепенного внедрения новых систем окажутся малоэффективными. Риски побочных эффектов и неконтролируемого поведения ИИ возрастут многократно. Кроме того, разработка технических мер по безопасному управлению такими системами становится сложной задачей, требующей подготовки заранее. Более того, из-за низкой стоимости вычислений для новой парадигмы и её масштабируемости, вскоре после появления первой успешной реализации сверхинтеллекта, десятки тысяч независимых акторов смогут создавать аналогичные системы, распространяя их по всему миру.

Это сделает невозможным эффективное международное регулирование чисто административными или техническими средствами. Следовательно, ключевой вопрос — быть заранее готовым к такому развитию событий, выработать протоколы тестирования, технические стандарты безопасности и механизмы контроля перед тем, как новые алгоритмы смогут стать общедоступными. Оппоненты данной точки зрения приводят ряд контраргументов. Они указывают на то, что если бы такой кардинально новый подход уже существовал или был близок к появлению, разработчики и исследователи неизбежно бы натолкнулись на него за десятилетия интенсивных исследований. Кроме того, они отмечают, что хотя преемственность в развитии ИИ может включать постепенное улучшение методов на основе больших языковых моделей и их комбинации с другими технологиями, новая парадигма, если она существует, скорее всего всё равно пройдёт через этапы постепенного вывода и адаптации, а не возникнет внезапно из ниоткуда.

Однако сторонники гипотезы «мозга в коробке» отвечают, что для появления «непохожей» на современные модели, кардинально отличной парадигмы может потребоваться сначала создание менее совершенного варианта, который постепенно будет интегрироваться с текущими технологиями. Этот процесс может занимать некоторое время, но, по их мнению, переход из «малозаметных ранних прототипов» к полнофункциональной сверхинтеллектуальной системе всё равно пройдёт быстрее, чем принято думать, возможно в течение двух лет или даже меньше, со значительным риском внезапных событий. Ещё одним серьёзным вызовом является вопрос устойчивости развития — насколько легко контролировать и направлять такой растущий интеллект. Многие эксперты сходятся во мнении, что достижение гарантированной точной и безопасной «выравненности» (alignment) сверхинтеллекта с человеческими ценностями является крайне сложной, если не невозможной задачей в долгосрочной перспективе. Сам факт того, что суперразум будет обладать собственной мотивацией и способностью к самообучению, способен привести к непредсказуемым и опасным предпочтениям, которые могут противоречить интересам человека.

![Twin Peaks Explained (No, Really) [video]](/images/FCAC8B7D-310C-429A-9BE8-E0C90280C261)