Внедрение искусственного интеллекта в групповые чаты уже давно перестало быть фантастикой и сейчас становится естественным этапом развития коммуникационных платформ. Однако добавление больших языковых моделей (LLM) в среду коллективного общения требует продуманного подхода, где на первый план выходит баланс между полезностью ИИ и сохранением непрерывности человеческого взаимодействия. Неправильная интеграция может привести к раздражению участников беседы и снижению эффективности использования технологий, тогда как грамотное внедрение открывает новые горизонты удобства и автоматизации. Традиционные групповые чаты часто предполагают, что каждый участник обращается к другим живым пользователям. В такой динамике искусственный интеллект воспринимается скорее как внешний помощник, а не активный участник.

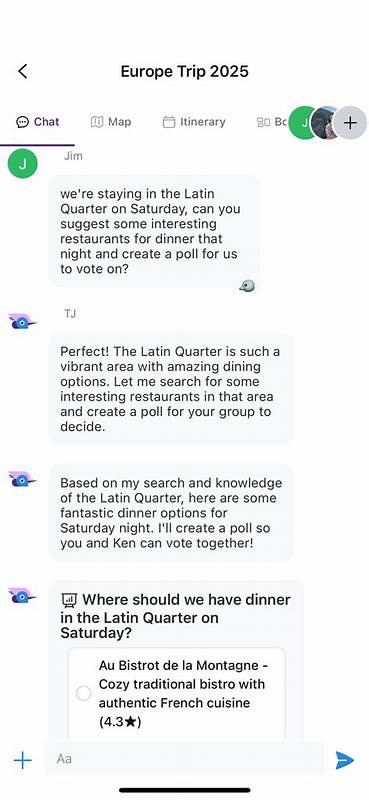

Люди, желая получить ответ от ИИ, зачастую переключаются на отдельные специализированные приложения, например ChatGPT, что добавляет несколько лишних шагов в коммуникацию. Встроенный помощник в чат может сэкономить время, избавляя от необходимости переходить в другое приложение и копировать информацию назад в беседу, однако в большинстве случаев такая экономия не оправдывает неудобств и риска «размазать» основную тему разговора бесполезными ответами бота. Необходимо учитывать, что ИИ становится более полезным, когда в распоряжении у него имеются специализированные инструменты, встроенные в сам чат. Примером может служить функциональность проведения опросов — ИИ способен самостоятельно собрать варианты ответов, например, искать рестораны для совместного ужина и сразу создавать интерактивный опрос для участников. Без такого подхода пользователю пришлось бы вручную брать поисковую информацию из AI-приложения и затем создавать голосование, что отнимает время и нарушает поток общения.

Но настоящий потенциал искусственного интеллекта раскрывается в специализированных приложениях с встроенными группами, например, в туристических планировщиках. Совместное планирование путешествия, создание маршрутов, ведение списка дел и бюджета – все эти задачи получают мощное упрощение, когда ИИ действует как полноценный помощник внутри экосистемы. В таком контексте LLM не просто отвечает на вопросы, но и может автоматически добавлять события в маршруты, искать достопримечательности на карте и даже взаимодействовать с визуальным интерфейсом приложения. Одной из ключевых проблем при работе с LLM в группе становится определение, когда именно ИИ должен вмешаться в разговор. В отличие от одиночных диалогов, в группе не каждое сообщение адресовано боту.

Совокупность сообщений часто направлена другим участникам, и искусственный интеллект должен удерживаться от нежелательных вмешательств, вступая в беседу только по необходимости. Такой выбор помогает сохранять естественный ритм общения и повышает доверие пользователей к интеллектуальному помощнику. Возможность производить многозадачность при взаимодействии с приложением значительно расширяет круг задач, которые может выполнять ИИ. Присутствие множества функций — начиная от добавления локаций на карту и заканчивая управлением списком дел и созданием опросов — позволяет пользователям существенно экономить время и силы. Важным аспектом становится способность модели связывать последовательные действия: например, найти кафе в определённом районе, отобразить их расположение на карте, добавить в маршрут поездки и организовать групповой опрос по выбору места для ужина.

Успешная работа таких функциональных возможностей во многом зависит от качества системного контекста, который передается LLM при обработке запроса. Интеграция информации о текущем маршруте, составе участников и их ролях, часовом поясе или предыдущих действиях помогает модели быстро и точно понимать задачи пользователя. Такой подход существенно превосходит вариант, когда ИИ вынужден сначала запрашивать необходимый контекст через дополнительные функции, что замедляет взаимодействие и повышает вероятность ошибок. Для своевременного и корректного реагирования на обращения пользователей важно тщательно продумывать способы инициирования диалога с ИИ. В большинстве внедрений сначала выбран консервативный метод — бот реагирует только на прямые упоминания или специальные команды.

Например, упоминание его имени в начале сообщения или последующая маркировка текста как запрос к ИИ гарантирует, что бот не вмешается в обычное общение без необходимости. Такое решение помогает избежать ощущения излишнего контроля искусственного интеллекта и уважает пространство для человеческого общения. В будущем возможно расширение этого подхода: ИИ может автоматически распознавать запросы на помощь, исходя из содержания беседы, и аккуратно предлагать свои услуги. Однако тут важен баланс, чтобы не превратить ассистента в нежелательного и раздражающего «Клиппи», от которого хочется избавиться. Дополнительно рассматривается идея скрытой коммуникации с ботом без показа полной переписки группе, отображая только конечные результаты команд — такой механизм напоминает привычные пользователям слэш-команды из популярных мессенджеров.

Еще одна техническая задача заключается в управлении памятью и объемом передаваемых данных для эффективного понимания контекста. Групповые чаты часто имеют большие объемы сообщений, и отправлять всю историю запросу к ИИ неэффективно и дорого. Решается эта проблема путём ограничения размера передаваемой истории, например, до последних 15 сообщений, что обычно достаточно для понимания ситуации. Возможное развитие — динамическое наращивание объема истории при необходимости или использование механизмов поиска, которые облегчают модели извлечение нужной информации без избыточной нагрузки. Техническая архитектура решения включает выделение пула рабочих процессов для обработки запросов к ИИ.

Каждой группе назначается определённый рабочий поток по модулю числа доступных воркеров, чтобы запросы выполнялись последовательно и не возникало конфликтов. Это особенно важно при одновременном обращении к боту несколькими участниками одной и той же беседы, когда взаимодействие должно оставаться предсказуемым и надёжным. Важным аспектом является обеспечение конфиденциальности и безопасности пользовательских данных. Использование публичных моделей и облачных API предполагает определённый компромисс между удобством и приватностью. Тем не менее, современные платформы, как TripJam, ориентированы на уважение приватности и стремятся в будущем внедрять поддержку собственных локально размещённых моделей, что позволит пользователям самостоятельно контролировать свои данные.

Смотрящий в будущее путь развития интеграции LLM в групповые чаты включает планы по внедрению протоколов взаимодействия, таких как Model Context Protocol (MCP). Использование MCP позволит пользователям работать с приложением через различные клиенты, включая популярные чат-бот-платформы, и тем самым расширит возможности кастомизации и использования приложений. Это даёт пользователям свободу выбора и возможность адаптировать сервис под свои привычки и предпочтения. Подытоживая, интеграция больших языковых моделей в групповые чаты — это не просто техническая задача, а комплексное инженерное и дизайнерское решение, которое требует понимания особенностей групповой коммуникации, специфики приложения и ожиданий пользователей. Оптимальный путь — создавать ИИ-помощников, которые умеют быть полезными в контексте целевой задачи, минимально вмешиваться в естественный поток общения и предоставлять мощные инструменты для сотрудничества и принятия решений.

Такой подход сделает общение не только удобнее, но и создаст новые стандарты взаимодействия с цифровыми помощниками в коллективных средах.