В современном программировании одним из самых перспективных направлений является интеграция искусственного интеллекта непосредственно в приложения. Особенно большую популярность приобрели большие языковые модели (LLM), которые позволяют решать широкий спектр задач — от генерации текста до анализа данных и автоматизации процессов. Одним из эффективных способов повысить интерактивность и гибкость работы с такими моделями является внедрение REPL (Read-Eval-Print Loop) — интерактивной оболочки, позволяющей пользователям вводить команды и получать результаты в реальном времени. В этой статье мы рассмотрим, почему стоит встраивать LLM REPL непосредственно в свои программы, как это сделать и какие преимущества это даст вашему проекту. LLM REPL — что это и почему это важно REPL представляет собой среду, где пользователь может вводить команды, тут же получать результаты и продолжать взаимодействие, исходя из полученных данных.

В контексте больших языковых моделей это открывает уникальные возможности для динамической работы с ИИ — пользователь не ограничен статичными скриптами или заранее определёнными интерфейсами, он может экспериментировать, уточнять запросы и получать ответы в своей естественной форме. Встраивание LLM REPL непосредственно в программу позволяет создать более живую, гибкую и персонализированную среду. Такой подход облегчает отладку, повышает удобство использования, стимулирует креативность у конечных пользователей и даёт разработчикам мощный инструмент для оперативного тестирования и расширения функционала. Преимущества интеграции LLM REPL в программу Интерактивность – один из ключевых факторов успеха любой программы, особенно если она связана с ИИ. Благодаря REPL пользователь получает возможность взаимодействовать с моделью непосредственно и без промежуточных шагов.

Это особенно полезно при сложных задачах, требующих многократных уточнений и корректировок. Гибкость. Встроенный REPL можно адаптировать под конкретные нужды вашего приложения, будь то генерация контента, проведение интеллектуального анализа данных или помощь в разработке программного кода. В отличие от внешних командных оболочек, ваша программа будет полностью контролировать процесс, обеспечивая более точные и релевантные ответы. Обучаемость и расширяемость.

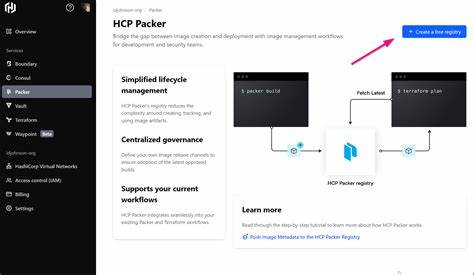

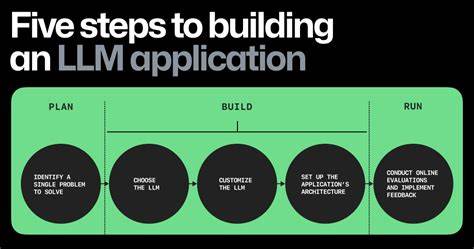

LLM REPL упрощает экспериментирование с различными подходами и методами работы с языковой моделью. Вы можете быстро тестировать гипотезы, настраивать параметры и даже интегрировать дополнительные источники данных. Как встроить LLM REPL в ваше приложение Для начала необходимо выбрать подходящую языковую модель и API, который позволит вам отправлять запросы и получать ответы. Сегодня наиболее популярны сервисы от OpenAI, Anthropic, Cohere и других крупных провайдеров. Важно учитывать, что многие модели требуют наличия ключа API и имеют ограничения по скорости запросов и стоимости.

После выбора модели следует реализовать сама REPL оболочку. Основная идея — организовать цикл, который читает ввод пользователя, отправляет его языковой модели для обработки, получает ответ и выводит его обратно. В зависимости от среды разработки это можно сделать на Python, JavaScript, Java или любом другом удобном языке. Особое внимание стоит уделить обработке ошибок и управлению состоянием. Например, можно сохранять контекст диалога, чтобы модель лучше понимала продолжение беседы, или реализовать дополнительные проверки, чтобы предотвратить непреднамеренные запросы.

Подключение REPL к пользовательскому интерфейсу — важный этап. Если ваше приложение имеет графический интерфейс, можно создать интерактивное окно или вкладку, где пользователь сможет вводить команды и видеть ответы без необходимости переключаться между разными программами. Практические сценарии использования В учебных приложениях встроенный LLM REPL помогает студентам задавать вопросы и получать развернутые пояснения по сложной теме в интерактивном режиме. В автоматизации рутинных задач — REPL упрощает настройку скриптов и автоматических процессов, позволяя быстро корректировать и расширять функционал. Для разработчиков программного обеспечения такой подход предоставляет возможность тестировать и отлаживать фрагменты кода, генерировать новые идеи и получать предложения по улучшению архитектуры прямо внутри IDE или специализированного приложения.

В сфере поддержки клиентов LLM REPL помогает составлять ответы на сложные запросы в режиме реального времени, облегчая работу операторов и повышая качество обслуживания. Рекомендации по оптимизации работы с LLM REPL Чтобы работа с встроенной REPL была максимально продуктивной, необходимо учитывать несколько технических и UX моментов. Важно оптимизировать скорость отклика, чтобы пользователь не ощущал задержек. Для этого можно использовать локальные модели небольшого размера или кешировать часто запрашиваемую информацию. Безопасность и конфиденциальность также не должны оставаться без внимания.

Следует контролировать ввод пользователя, фильтровать нежелательный контент и защищать данные бэкенда и API. Пользовательский интерфейс должен быть интуитивно понятным и поддерживать подсказки или шаблоны ввода, чтобы облегчить взаимодействие с моделью. Это повышает вовлеченность и снижает порог входа для новичков. Перспективы и дальнейшее развитие С развитием технологий и появлением всё более мощных языковых моделей интеграция LLM REPL будет становиться неотъемлемой частью новых программных продуктов. Возможность вести диалог с ИИ в реальном времени внутри приложения открывает двери для творчества, автоматизации и глубокого анализа.

![Metaobject Protocols: Why we want them and what else they can do [pdf]](/images/5CD47BA1-DDB4-47C4-AB73-B3605DD21D60)