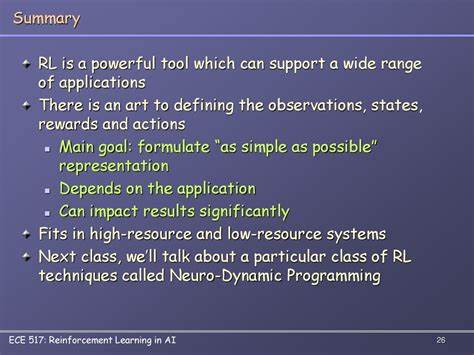

С развитием искусственного интеллекта и больших языковых моделей появилась возможность быстро и эффективно обрабатывать огромные объемы информации. Одной из актуальных задач стало создание качественных, информативных и кратких резюме длинных текстов. Несмотря на успешные попытки с помощью классических методов обработки естественного языка и трансформеров, добиться совершенства оказалось тяжело. Главная сложность — определить, что такое «хорошее» резюме, и научить модели ориентироваться именно на эти критерии. В поиске решения этой задачи появилась инновационная методология — обучение с подкреплением (Reinforcement Learning), которая трансформирует подход к сжатию и обобщению текстов.

В центре внимания проекта Summary-RL, основанного на этой технологии, стоит создание модели, способной формировать резюме, исключительно сфокусированные на полноте передачи информации и отвечающие на максимально возможное количество вопросов по исходному тексту, сохраняя при этом регламентированный объём. Обучение с подкреплением в резюмировании представляет собой процесс, при котором модель получает обратную связь в виде вознаграждений, зависящих от качества генерируемого резюме. Основным нововведением в Summary-RL стала постановка задачи: максимизировать не просто краткость текста, а способность резюме отвечать на вопросы, связанные с содержанием документа. Такая задача требует наличия объективной метрики качества — механизм, который оценивал бы правильность и полноту ответов, получаемых от искусственного интеллекта на основе сгенерированного краткого изложения. Для решения этой проблемы команда Summary-RL применяет уникальное сочетание моделей — основной языковой модели Qwen 2.

5 14B и «судьи» в лице модели Gemini 2.5 Flash Preview. Основная модель генерирует резюме, а судья проверяет их, отвечая на вопросы, поставленные в датасете Repliqa. Каждый документ в этом наборе данных сопровождается пятью вопросами и пятью «золотыми» ответами, причем часть вопросов — это отвлекающие, ответы на которые отсутствуют в самом тексте, что делает задачу более сложной и реалистичной. Судья, сравнивая свои ответы с эталоном, выставляет оценку, которая затем служит наградой для обучения генератора.

Интересной деталью является строгое ограничение на длину резюме — не более 350 слов. Если лимит превышается, награда обнуляется, что стимулирует модель создавать сжато, но содержательно. Использование списка вопросов и оценка правильности ответов — это творческий и инновационный подход к определению качества резюме. Вместо субъективной оценки человеком, что зачастую непоследовательно и трудоемко, здесь применяется строгая, объективная метрика, напрямую связанная с целью резюмирования: насколько хорошо текст отражает информацию исходного документа. Такая постановка задачи позволяет не только контролировать качество конечного текста, но и запускать процесс обучения с подкреплением, при котором модель постепенно улучшает свои способности, ориентируясь на награды.

Датасет Repliqa заслуживает отдельного внимания. Созданный ServiceNow, этот набор данных содержит искусственно сгенерированные документы, которые описывают реалистичные, но вымышленные события и факты. Такой подход предотвращает эффект запоминания модели и помогает сосредоточиться именно на качественной обработке текста. Средний объем документа составляет около 1000 слов. В дополнение к пяти вопросам, некоторые из которых являются отвлекающими, применяется фильтрация документов по критерию способности судьи давать все правильные ответы при работе с полным текстом.

Таким образом, обеспечивается достойный уровень сложности и реалистичности задачи. Начальные тесты работы различных моделей показали значительные различия по качеству созданных резюме. Лидером оказался Sonnet 4, с долей правильно отвеченных вопросов — 72%, что близко к пределу возможностей используемой модели-судьи. Модель Qwen 2.5 14B, выбранная в качестве базы для обучения с подкреплением, на старте показала всего 43%, что подтверждало необходимость улучшения и потенциал данного метода.

Обучение с подкреплением на базе ART (Agent Reinforcement Trainer) позволило вывести модель Qwen до 85% — невероятный показатель улучшения в 42% и превосходящий конкурентов. Одной из причин такого значительного роста стало грамотное применение алгоритма Group Relative Policy Optimization (GRPO), специализирующегося на обучении агентов с множественными выборами. В данном случае сессии обучались на группах с генерированными по 10 вариациям резюме на каждый документ с последующим оцениванием и обновлением модели. Такой подход обеспечивал более стабильные и быстрые циклы обучения, а использование оптимизаций, таких как vLLM и агрессивная упаковка выборок, позволило сократить время тренировки и снизить затраты. Экономическая эффективность проекта также впечатляет: обучение прошло за примерно 5 часов на одном GPU NVIDIA H100, что стоило всего около 22 долларов.

Это совсем небольшие инвестиции по сравнению с масштабом и качеством полученного результата. Благодаря открытой лицензии и опубликованному коду, теперь каждый может воспользоваться этим набором инструментов, чтобы обучить собственную модель по индивидуальным критериям качества, будь то выделение ключевых пунктов встречи, соблюдение конфиденциальности персональных данных или создание очень коротких резюме, подходящих для твитов. Примером эффективности полученной модели служит сравнение с конкурентами: в одном из документов, посвященных переработке пластика, ART•S (так называется обученная модель) смог уточнить, кто инициировал местную переработку пластика, назвав точные даты, имена и места, что для других моделей было намного сложнее. Интересно, что модель также стремится сохранять прямые цитаты из текстов, что улучшает качество и подробность ответов на вопросы. Размышления, сделанные в процессе работы, помогли выявить важные нюансы в построении функции вознаграждения.

Первоначальные попытки ввести штрафы за длину текста осложняли обучение: если все кандидаты отвечали на одинаковое число вопросов, модель начинала излишне сжимать резюме в ущерб содержанию. Оказалось эффективнее сохранить простое ограничение — полное аннулирование награды при превышении 350 слов. Такая простота позволила модели сначала научиться полноте, а потом естественно скорректировать длину, что хорошо отражается в динамике учебного процесса. Summary-RL демонстрирует, насколько мощным инструментом может стать обучение с подкреплением в задачах обработки естественного языка. Потенциал применения этого подхода выходит далеко за рамки резюмирования — его можно адаптировать под любые критерии качества, которые важно строго соблюдать.