В последние годы технологии искусственного интеллекта стремительно развиваются, открывая множество новых возможностей для бизнеса и инноваций. Появление больших языковых моделей (LLM), таких как GPT-4 и другие, сделало AI более доступным для разработчиков, бизнеса и стартапов. Однако это порождает вопрос: какой путь выбрать при создании AI-приложения? Нужно ли обучать модели с нуля или достаточно использовать уже готовые решения и сервисы? Как построить минимально жизнеспособный продукт (MVP), который решит реальные задачи пользователей? И какие инструменты помогут в этом процессе? В этой статье мы подробно рассмотрим основные пути развития AI-приложений и ответим на эти вопросы. Начнем с базового понимания возможностей современных моделей и доступных инструментов, а также разберем практические рекомендации для успешной реализации AI-проектов. Большинство AI-приложений сегодня строятся не на собственном обучении моделей, а на использовании уже существующих мощных языковых моделей, предоставляемых различными платформами.

Такие модели содержат в себе обширные накопленные знания, позволяя разработчикам сосредоточиться на задаче создания эффективных запросов — промптов, которые направляют модель на выполнение конкретной функции. Эта концепция получила название prompt engineering и является одной из главных компетенций разработчиков AI-продуктов. Поэтому если вы начинаете заниматься AI, самое простое и полезное будет поэкспериментировать с OpenAI Playground или аналогичными инструментами, которые позволяют в интерактивном режиме формировать и тестировать запросы к языковым моделям. Обычно это первый шаг, который помогает понять — что умеет модель и как лучше оформить вопросы для получения оптимального результата. Отлаживая промпты вручную, вы лучше разбираетесь в тонкостях работы модели и можете выстроить логику приложения с высоким качеством ответа.

Важно помнить, что основная сложность при работе с LLM заключается не в технической реализации, а в влиянии случайности и непредсказуемости модели. То, что сработало отлично на одном примере — может дать неправильный ответ на другом. Это вынуждает разрабатывать итеративные подходы, оттачивая запросы и стратегии взаимодействия с моделью на разных наборах данных. По этой причине при начале разработки не рекомендуется сразу использовать сложные библиотеки и фреймворки. Лучше стартовать с простейших запросов к API, экспериментировать и совершенствовать промпты, затем постепенно добавлять уровни автоматизации и разбираться с оркестрацией вызовов.

Набор популярных библиотек для работы с AI постоянно растет и предлагает массу возможностей: LangChain, LlamaIndex, Agno и многие другие. Они позволяют создавать продвинутые пайплайны, включающие поиск информации, интеграцию с базами данных, многозадачный анализ и комплексные агенты. Но без четкого понимания задачи переход к таким инструментам иногда создаёт излишнюю сложность и отвлекает от сути. Помимо работы с промптами, большое значение имеет построение надежного цикла разработки. Рекомендуется использовать методы систематического анализа ошибок, например, подход, описанный Джейсоном Хамелем: составить тестовый набор запросов, прогонять через модель и систематизировать типы ошибок.

Это помогает выявлять закономерности и целенаправленно улучшать промпты и логику обработки. Также на этом этапе полезно обрабатывать обратную связь от пользователей и создавать непрерывный процесс доработки. Важно иметь под рукой инструменты для наблюдения и анализа работы AI-системы. При развитии проекта полезны LLMOps-платформы — специализированные сервисы, предоставляющие мониторинг, возможность сравнения результатов экспериментов, автоматизированные оценки качества. Среди таких решений можно выделить langsmith, helicone, braintrust, humanloop и другие.

Они позволяют получать прозрачную статистику по каждому этапу взаимодействия с моделью, облегчая выявление багов и проблемных зон. Однако использование LLMOps-систем обычно эффективнее на более зрелом этапе развития продукта. В самом начале основное внимание необходимо уделять максимально простому и надежному процессу. В свою очередь существует и другая точка зрения на AI-стартапы и их будущее. Некоторые эксперты отмечают, что большинство проектов в этой сфере построены на простом применении существующих моделей без уникальных решений.

Они называют это «AI слоп» — некачественный или поверхностный продукт, который зачастую представляет собой больше маркетинг и хайп, чем инновации. По их мнению, инвестиции венчурных фондов в такие проекты — часть общей стратегии поддержки и расширения рынка AI, а не отдельных успешных компаний. В перспективе развитие больших языковых моделей может привести к тому, что SaaS-продукты перестанут быть актуальными, поскольку пользователи смогут буквально «под себя» создавать необходимые инструменты с помощью AI, без необходимости платить за многофункциональные, но часто избыточные решения. Это фундаментально изменяет бизнес-модель программного обеспечения, и многие нынешние AI-стартапы действуют в среде, где создается конкуренция с самим AI-технологическим стеком. Что же делать разработчику, желающему построить успешное AI-продукт? С практической точки зрения, главным остается четкое определение бизнес-задачи и целевой аудитории.

Понимание проблемы, которую вы решаете, и того, как языковые модели могут ей помочь, должна стоять во главе всего процесса. Не стоит сразу стремиться к сложным технологиям или излишним автоматизациям — лучше начать с простых прототипов, работающих на промптах и минимальном API, чтобы быстро проверить гипотезу. Постоянное тестирование и доработка промптов — залог успеха. Используйте методики error analysis, собирайте пользовательские данные, отслеживайте вызовы модели и анализируйте, где система дает сбои. По мере роста продукта переходите к применению специализированных фреймворков для удобной работы с цепочками вызовов, обработки контекста, интеграции с другими системами.

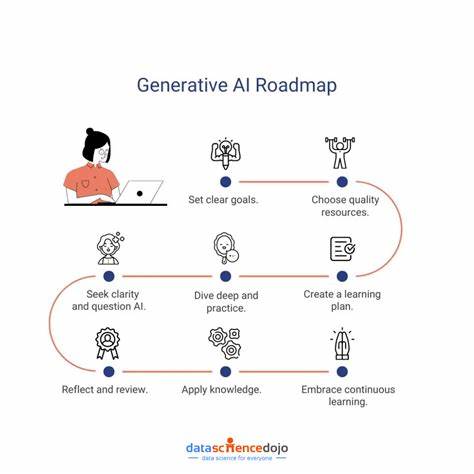

Тогда же можно задуматься и об использовании LLMOps для управления сложностью и обеспечением стабильности. Также важно участие в профессиональных сообществах, где можно обмениваться опытом, задавать вопросы и получать поддержку. Среди таких сообществ многим нравятся форумы и площадки вроде Hacker News, специализированные Slack- или Discord-группы, а также конференции и вебинары по тематике искусственного интеллекта и больших языковых моделей. Подводя итог, путь разработки AI-приложения сегодня чаще всего начинается с использования мощных готовых моделей, изучения и отработки искусств prompt engineering. Основное внимание должны привлечь простые эксперименты и итеративный процесс оптимизации ответов.

Только после формирования стабильного и полезного продукта целесообразно поднимать сложность, используя продвинутые библиотеки и системы управления. Понимание актуальных трендов и перспектив помогает не упустить возможности и строить проекты, выдерживающие конкуренцию на рынке. AI — это мощный инструмент, но успех зависит прежде всего от грамотного применения, понимания потребностей пользователей и постоянного поиска оптимальных решений.