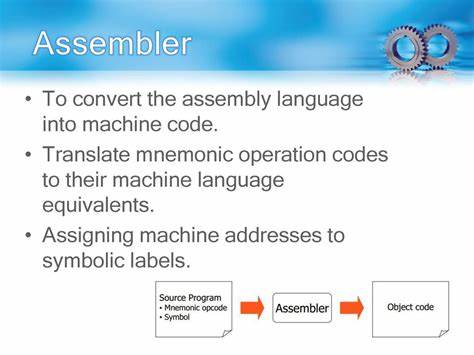

В мире современных технологий искусственный интеллект становится всё более доступным для широкой аудитории. Одним из ключевых аспектов взаимодействия с языковыми моделями, такими как GPT, Claude и их аналогами, является использование токенов. Понимание того, сколько токенов пользователь потребляет в месяц, помогает оптимизировать работу с системами, задействованными в различных задачах, будь то генерация текстов, анализ данных или просто общение с ИИ. В последние годы токены стали своеобразной валютой, по которой происходит расчёт за услуги работы языковых моделей. Токен — это единица измерения текста, которая включает в себя слова, символы и пробелы, преобразованные алгоритмом в формат, удобный для обработки нейронными сетями.

Многие пользователи и бизнесы сталкиваются с вопросом: насколько велик объём потребления токенов и как эффективно использовать их без лишних затрат? Рассмотрим эту тему детально, опираясь на мнения экспертов, реальные кейсы и рекомендации по управлению токенами. Начать следует с понимания, что среднее количество токенов, используемых в месяц, зависит от характера взаимодействия с языковой моделью. Например, если вы регулярно задаёте вопросы, генерируете большие тексты или автоматизируете бизнес-процессы с помощью ИИ, то потребление токенов будет высоко. В сообществе, как правило, встречаются разные оценочные показатели. Некоторые пользователи заявляют о потреблении нескольких тысяч токенов в месяц, другие — сотни тысяч.

На практике, это число варьируется в зависимости от частоты и объёма запросов. Пользователь с активным использованием модели для создания контента, редактирования и анализа данных может расходовать десятки тысяч токенов турбоактивно за месяц. Подобные показатели требуют либо платного тарифного плана, либо оптимизации работы с ИИ. В дискуссиях на тематических форумах, таких как Hacker News, пользователи делятся своим опытом о том, как это сказывается на их активности. Один из активных участников заметил, что установленное ограничение в 45 коротких сообщений каждые 5 часов, предлагаемое сторонними сервисами, явно недостаточно для интенсивного использования.

Пользователь из своего опыта отметил необходимость примерно 45 таких запросов каждую минуту, что значительно превышает лимиты. Это свидетельствует о растущем спросе на более гибкие и масштабируемые решения для работы с токенами. Одна из стратегий снижения расходов — переход на локальные языковые модели. Подобный подход позволяет обходиться без постоянных тарификаций, связанных с использованием крупномасштабных облачных сервисов, поскольку вычисления выполняются на собственном оборудовании. Хотя локальные модели иногда уступают в мощности и качестве, они предоставляют пользователям свободу в выборе частоты и количества запросов.

Сравнительно недавно пользователи стали задумываться о балансе между качеством, скоростью отклика и стоимостью. В результате появилась тенденция создания гибридных решений, где часть задач обрабатывается локальным ИИ, а более сложные — через облачные сервисы с платными тарифами. Такая оптимизация помогает снизить общий расход токенов, сохраняя при этом эффективность и качество работы. Важно также понять, что понятие «токен» может у разных моделей иметь различные значения и веса. Например, в системе GPT-3 один токен примерно соответствует четырём латинским символам или одному слову, однако в некоторых языках и форматах это соотношение меняется из-за особенностей морфологии и структуры текста.

Соответственно, пользователям нужно учитывать специфику своего языка и контента при оценке потребления. Для предпринимателей и творческих профессионалов, активно использующих искусственный интеллект, управление токенами становится частью общей стратегии оптимизации производительности и затрат. Использование специализированных инструментов мониторинга и анализа позволяет точно отслеживать, как меняется ежемесячное потребление, выявлять пиковые моменты и оптимизировать структуру задач, передаваемых модели. Помимо экономии, это помогает планировать бюджет и выбирать подходящие тарифы среди разнообразия предложений на рынке. Современные сервисы с открытыми API предоставляют широкий спектр возможностей для управления ограничениями и настройками, позволяя делить поток запросов, контролировать затраты и обеспечивать стабильную работу без перебоев.

Кроме того, стоит обращать внимание на обучающие материалы и советы от разработчиков платформ, которые часто предлагают рекомендации по снижению расхода токенов без потери качества результата. Например, сокращение неинформативных запросов, переход на более компактные форматы общения или использование предварительно подготовленных шаблонов значительно снижают потребление. Аналитика и статистика среднего расхода токенов за последний год показали тенденцию к увеличению. Это связано с ростом количества интеграций ИИ в бизнес-процессы, развитие сервисов, ориентированных на обработку естественного языка и массовое распространение чатботов. С каждым месяцем пользователи сталкиваются с необходимостью более точно планировать свои расходы и искать способы повышения рентабельности использования языковых моделей.

Технологический прогресс также способствует появлению новых предложений, которые обещают высокую скорость и качество при оптимизированном потреблении токенов. Инновационные методы сжатия данных, улучшенные алгоритмы обработки текста и адаптивное распределение задач между облачными и локальными вычислениями позволяют значительно снизить издержки. С практической стороны, важно строить личный или корпоративный подход к взаимодействию с ИИ, учитывая специфику задач, количество генерируемого контента, периодичность и критичность обработки информации. Организация точного учёта расхода и тщательный анализ позволяют своевременно корректировать параметры взаимодействия и не выходить за рамки бюджета. Наконец, будущее демонстрирует развитие более сложных систем на основе искусственного интеллекта с оптимизированным использованием токенов, благодаря чему применение таких технологий станет ещё более доступным и выгодным.

Управление расходом токенов невозможно отделить от глобальной тенденции цифровизации и инноваций в сфере искусственного интеллекта, делая этот вопрос актуальным для широкой аудитории – от домашних пользователей до крупных корпораций. Таким образом, понимание, сколько токенов вы используете в месяц, является ключом к эффективной работе с современными языковыми моделями. Анализ своего потребления и поиск оптимальных решений обеспечат максимальную отдачу от ИИ при минимальных затратах, помогая адаптироваться к быстро меняющимся условиям цифрового мира.