В последние годы большие языковые модели (LLM) кардинально изменили подходы к обработке естественного языка и применению искусственного интеллекта во многих сферах. Однако масштабное использование таких моделей сопровождается серьезными вызовами, связанными с эффективным и экономичным их обслуживанием. На фоне высоких затрат на вычислительные ресурсы и ограничений по производительности важным становится поиск решений, способных существенно оптимизировать работу с LLM. Одним из таких решений стала библиотека vLLM, разработанная командой исследователей из Университета Калифорнии в Беркли, которая обещает упростить, ускорить и удешевить процесс сервинга LLM за счет инновационного алгоритма PagedAttention. vLLM представляет собой открытую платформу для быстрого вывода больших языковых моделей, предлагая до 24 раз более высокую пропускную способность по сравнению с широко используемым библиотекой HuggingFace Transformers и более чем трехкратное превосходство над HuggingFace Text Generation Inference.

Такой прорыв достигнут без необходимости изменений в архитектуре моделей, что делает vLLM удобным и эффективным инструментом для исследовательских и промышленных задач. Ключевым фактором, который позволил добиться значительного роста производительности, является PagedAttention — инновационный алгоритм внимания, вдохновленный концепциями виртуальной памяти и постраничного управления из операционных систем. Одной из главных проблем при обслуживании LLM является управление кешем ключей и значений внимания (KV cache). При генерации текста автозаполняющим образом система сохраняет тензоры ключей и значений для всех ранее обработанных токенов, обеспечивая возможность обращения к контекстной информации. В больших моделях, таких как LLaMA-13B, размер кеша KV может достигать гигабайтов, что создает значительную нагрузку на память GPU, ограничивая одновременное число обслуживаемых последовательностей и снижая общую эффективность.

Традиционные решения требуют размещать весь кеш в непрерывном участке памяти, что приводит к проблемам фрагментации и переизбыточному резервированию. Это негативно сказывается на общем использовании памяти, тратя от 60% до 80% ресурсов впустую. PagedAttention устраняет данную проблему за счет разбиения кеша на блоки фиксированного размера, которые могут храниться как в непрерывных, так и в фрагментированных областях памяти. Такой подход аналогичен постраничному управлению памятью в традиционных операционных системах, где страницы логически упорядоченной данных располагаются в физической памяти произвольно. Благодаря этому механизму достигается отлаженное и оптимальное использование памяти при генерации длинных или динамических последовательностей.

Эффективность использования памяти в этом подходе достигает уровня, при котором потери сокращаются до менее чем 4%, что существенно выше традиционных методов. Уже эта оптимизация позволяет включать в один батч больше последовательностей, повышая загрузку GPU и увеличивая пропускную способность системы. Кроме того, PagedAttention предоставляет возможности для эффективного совместного использования памяти между разными выводимыми последовательностями. В случаях параллельной генерации нескольких вариантов ответа на один и тот же запрос, общая часть вычислений и кеша — то есть контекст запроса — может быть разделена между этими вариантами. Это достигается за счет ведения таблиц сопоставления блоков кеша и использования механизма подсчета ссылок с копированием при изменении (Copy-on-Write).

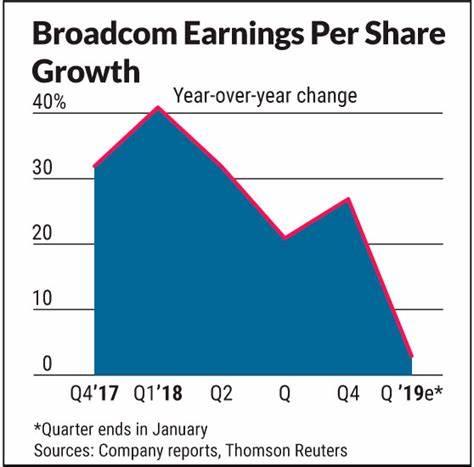

Такая оптимизация сокращает расходы памяти при комплексных алгоритмах сэмплинга, таких как параллельный сэмплинг и beam search, до 55%. Это позволяет добиться увеличения пропускной способности примерно вдвое по сравнению с классическими решениями, одновременно делая более сложные алгоритмы практически реализуемыми в реальных сервисах. Применение PagedAttention и vLLM продемонстрировало свою эффективность в нескольких популярных чат-ботах и сервисах, включая Vicuna и Chatbot Arena, которые получили широкую известность благодаря высококачественным диалоговым моделям. Сначала эти проекты использовали бэкенд на базе HuggingFace Transformers, который не справлялся с растущей нагрузкой и становился узким местом при пиковом трафике. Внедрение vLLM позволило увеличить пропускную способность до 30 раз и одновременно снизить число используемых GPU вдвое, что существенно уменьшило общие операционные расходы.

Интеграция с FastChat обеспечила удобный многофункциональный интерфейс, где FastChat выступает как фронтенд мульти-модельного сервиса, а vLLM — как высокопроизводительный движок генерации. Благодаря этому сочетанию миллионы пользователей смогли получать ответы от Vicuna и других моделей с минимальной задержкой и высокой стабильностью. Кроме очевидных преимуществ в скорости и экономичности, vLLM также отличается простотой использования. Установка библиотеки занимает всего одну команду через pip, а для запуска сервиса достаточно одной строки кода. vLLM поддерживает как оффлайн-инференс для интеграции в пользовательские скрипты, так и онлайн-сервер, совместимый с API OpenAI, что обеспечивает гибкие сценарии применения.

Можно легко настроить модели, например lmsys/vicuna-7b-v1.3, и быстро начать генерацию текстов или запустить собственный локальный API для взаимодействия. Продолжающееся развитие и расширение функциональности обещает поддержку все более широкого спектра языковых моделей, включая Databricks Dolly, LAION OpenAssistant и Stability AI’s stableLM, что сделает vLLM универсальным инструментом для любого проекта, связанного с LLM. В целом vLLM с технологией PagedAttention задает новый стандарт в области обслуживания больших языковых моделей, сочетая необычайно высокую производительность, экономию ресурсов и удобство использования. Для исследовательских групп с ограниченными вычислительными мощностями и коммерческих сервисов, стремящихся сократить расходы и улучшить качество обслуживания, vLLM выступает как оптимальное решение.

Инновации, заложенные в основе PagedAttention, открывают пути для дальнейших улучшений в области управления памятью и распределенных вычислений, что сделает масштабирование LLM более доступным и эффективным. Применение таких технологий способствует ускорению внедрения ИИ в различные отрасли, от медицины и образования до креативных индустрий и пользовательских сервисов. Если вы хотите опробовать новейшие возможности в мире больших языковых моделей, начать работать с ними просто — достаточно установить vLLM и ознакомиться с документацией на официальном GitHub репозитории. В эпоху, когда качество и скорость обслуживания LLM определяют успех продуктов и сервисов, vLLM становится ключевым инструментом, позволяющим реализовывать самые амбициозные проекты в области искусственного интеллекта.