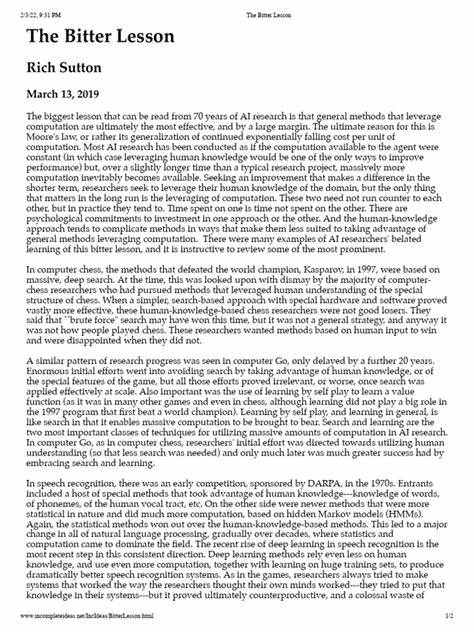

В последние семь десятилетий исследования в области искусственного интеллекта претерпели множество изменений, открытий и трансформаций. Однако несмотря на все успехи и достижения, одна фундаментальная и одновременно горькая правда неизменно подтверждается на практике – универсальные методы, которые максимально используют вычислительные мощности, оказываются наиболее эффективными в различных сферах ИИ, и это с большим отрывом от специализированных подходов. Такое наблюдение получило название «Горький Урок» (The Bitter Lesson), и его ключевым автором является Рич Саттон, один из ведущих исследователей в области ИИ. Он указывает, что попытки вручную добавить структурные ограничения и предположения часто сдерживают прогресс систем, тогда как мощные универсальные алгоритмы, обучающиеся на больших объемах данных, многократно превосходят первоначальные ожидания. Структура в моделях искусственного интеллекта – это набор предположений, которые закладываются в алгоритмы о том, как система должна решать поставленные задачи.

Часто это выражается в ведомственных признаках, правилах и эвристиках, которые создаются людьми на основе экспертных знаний. Возьмем, к примеру, область компьютерного зрения. В течение десятилетий исследователи разрабатывали специализированные методы извлечения признаков из изображений, такие как SIFT и HOG. Эти признаки отражали знание о том, какие элементы изображения могут быть важны для распознавания объектов. Однако с развитием вычислительных ресурсов и появлением глубоких нейронных сетей стало очевидно, что модели, обучающиеся напрямую на сыром пиксельном входе без изначального жесткого ограничения, достигают гораздо лучших результатов.

Они способны автоматически выявлять релевантные характеристики, которые невозможно было заранее запрограммировать, что приводит к качественному скачку в производительности и универсальности. Работа Хён Уон Чунга из OpenAI дополнительно подчеркивает важность минимизации введения структурных предположений на начальных этапах разработки систем. Его подход состоит в том, чтобы настраивать архитектуру модели с учетом имеющихся вычислительных ресурсов и объема доступных данных, а затем постепенно ослаблять эти ограничения, чтобы избежать узких мест, которые в дальнейшем мешают улучшениям. Такая стратегия позволяет сохранять гибкость и адаптивность моделей, чтобы максимально использовать прогресс аппаратного обеспечения и новых данных. В инженерной практике разработки интеллектуальных приложений принцип Горького Урока также подтверждается.

Например, в построении систем на основе больших языковых моделей (LLM) для организации исследовательских процессов в 2023-2024 годах возникли технические вызовы, связанные с ограничением контекстных окон и нестабильностью вызова инструментов напрямую из модели. Это привело к внедрению структурированных рабочих процессов, которые разбивали большие задачи на отдельные части и обрабатывали их параллельно, чтобы повысить надежность и скорость. Однако со временем, когда технологии вызова инструментов улучшились и постепенно стали более стабильными, именно жесткие структурные ограничения не позволили извлечь выгоду из этих нововведений. Было невозможно полностью использовать расширяющуюся экосистему многокомпонентных инструментов (MCP), так как архитектура приложения была слишком фиксирована. Переход к многоагентным системам позволил повысить гибкость и адаптивность, а также дала возможность агентам самостоятельно планировать задачи и использовать дополнительные инструменты.

Несмотря на это, часть ограничений, связанных с раздельной автономной работой каждого агента над отдельным разделом отчета, оказалась проблемой, так как агенты плохо взаимодействовали между собой, что приводило к разрозненности итоговых результатов. Именно понимание и постоянный пересмотр добавленных структурных ограничений помогли улучшить систему, переместив этап создания связного отчета на финальную стадию, что обеспечило более слаженный и качественный продукт на выходе. Таким образом, ключевые уроки, которые можно извлечь из опыта развития и инженерии ИИ, сводятся к необходимости внимательно понимать ограничения, внедренные в приложения, регулярно переоценивать их по мере улучшения моделей и создавать архитектуры, в которых можно легко изменить или полностью убрать эти ограничения. По словам ведущих экспертов индустрии, иногда стоит даже создавать решения, которые на момент разработки работают не идеально, так как прогресс моделей и алгоритмов зачастую происходит быстрее, чем ожидалось, и новые системы могут быстро стать более мощными и способными. Это новый взгляд на дизайн интеллектуальных приложений, когда будущий рост моделей и мощностей аппаратного обеспечения становится главным драйвером всего процесса разработки.

Вместо того, чтобы жестко ограничивать систему в надежде заранее задать оптимальные пути, необходимо создавать adaptable (адаптируемые) архитектуры, которые смогут эволюционировать вместе с технологиями. Такой подход помогает избежать «ловушек» фиксированных предположений и структур, которые становятся препятствием для роста. Пример из практики показывает, что отказ от излишних предположений и создание систем, способных гибко использовать возможности современных моделей и вычислений, дают возможность добиваться высоких результатов даже с относительно небольшими ресурсами. Результаты экспериментов в области open source позволяют конкурировать с системами, использующими дорогостоящие методы обучения с подкреплением и огромные вычислительные бюджеты. Сегодня мы наблюдаем, что проектирование систем искусственного интеллекта и приложений — это еще достаточно молодая и развивающаяся область.

Однако уже сегодня становится очевидным, что битва за эффективность выигрывается не столько за счет сложных, вручную настроенных правил и предположений, сколько за счет возможности систем учиться на больших объемах данных и эффективно использовать постоянно растущие вычислительные ресурсы. Понимание и применение Горького Урока становится ключевым фактором успеха в динамично меняющемся мире искусственного интеллекта и его инженерии. Именно гибкость, минимальное количество ограничений и способность моделей меняться и расти вместе с развитием технологий становятся фундаментом для создания интеллектуальных систем будущего.