Современный мир высокопроизводительных вычислений активно развивается благодаря постоянному совершенствованию аппаратного обеспечения и программных технологий. С ростом объёмов данных и сложностью вычислительных задач всё более востребованными становятся решения, способные эффективно задействовать несколько графических процессоров (GPU) в распределённой среде. Одним из новейших и перспективных инструментов в этой области стала платформа Iris - Triton-базированный фреймворк, обеспечивающий программирование с удалённым доступом к памяти (Remote Memory Access, RMA) на языке Python. Iris была разработана командой AMD Research and Advanced Development и представляет собой значимый шаг вперёд в многопроцессорном программировании благодаря предоставлению удобного и интуитивно понятного интерфейса для работы с распределёнными GPU. Система позволяет пользователям создавать высокопродуктивные многопроцессорные программы, которые работают так же просто, как однопроцессорные, что значительно снижает порог вхождения для разработчиков.

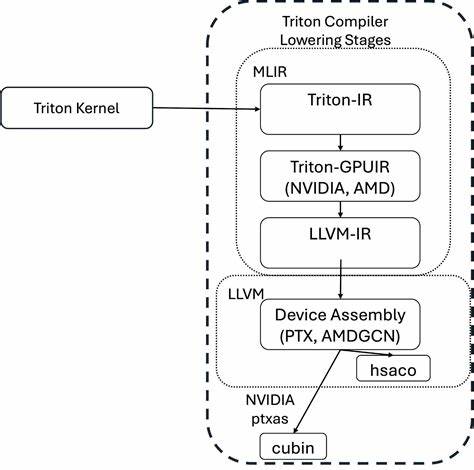

Одной из ключевых идей Iris является создание API, похожего на SHMEM - популярный API для управления распределённой памятью. SHMEM-подобный доступ к удалённой памяти обеспечивает простой и эффективный способ обмена данными между GPU, не прибегая к сложным и трудоёмким коммуникационным протоколам. Это облегчает разработчикам задачу синхронизации и обмена данными между различными вычислительными устройствами. Платформа построена на базе ядра Triton - современного языка и компилятора, оптимизированного для программирования GPU. Благодаря этому Iris наследует все преимущества Triton, включая высокую производительность и гибкие возможности по управлению памятью и потоками на GPU.

Таким образом, разработчики получают мощный саттелит, обеспечивающий как высокую скорость вычислений, так и удобство программирования. Кроме традиционного Triton API, Iris предлагает экспериментальную поддержку нового Gluon-бэкенда. Gluon представляет собой уровень программирования ниже Triton и предоставляет более детальный контроль над расположением данных, их перемещением в памяти и другими низкоуровневыми аспектами работы GPU. Это даёт возможность оптимизировать производительность и использовать аппаратные ресурсы максимально эффективно, ориентируясь на условия конкретной задачи. Для практического понимания возможностей Iris разработчики открыли несколько примерных реализаций, которые демонстрируют удалённые операции с памятью между GPU.

В представленных примерах используется Python вместе с PyTorch для распределённой инициализации кластеров, а на устройстве запускаются Triton-ядра, взаимодействующие через Iris API. Один из ключевых сценариев - запись значений в удалённую память другого GPU, что позволяет существенно упростить реализацию высокоуровневых алгоритмов обмена данными без необходимости писать низкоуровневый код передачи сообщений. Пример кода, где ядро напрямую записывает единицы в удалённый буфер на другом GPU, иллюстрирует простой, но мощный подход Iris. Этот пример благополучно работает с двумя ранками (rank) распределённой системы - один выступает в роли источника данных, другой - в роли цели. Такой подход делает параллельную обработку данных более прозрачной и масштабируемой, что особенно актуально в задачах глубокого обучения, анализа больших данных и высокопроизводительных вычислений.

В дополнение к Triton-базированным ядрам Iris внедрила экспериментальный Gluon API, который упрощает создание подобных программ за счёт отказа от необходимости явной передачи баз указателей Heap в качестве параметров функциями. Контекст устройства берётся из специального объекта, что повышает удобство написания кода и снижает ошибки, связанные с ручным управлением памятью. Для установки и начала работы с Iris разработчики предусмотрели несколько удобных способов. Самый быстрый - установка напрямую из репозитория через pip, что позволяет моментально получить последнюю версию библиотеки и начать разработку. Также реализован рекомендованный вариант для разработки через Docker Compose, который обеспечивает готовую среду с уже установленными зависимостями и необходимыми инструментами для продуктивной работы.

Конечно, чтобы использовать Iris, необходимо подходящее аппаратное и программное обеспечение. Ключевым требованием является поддерживаемая серия графических процессоров AMD MI300X и её производные, работающие под управлением ROCm (Radeon Open Compute). ROCm обеспечивает низкоуровневый драйвер и runtime для управления GPU AMD, а Iris использует этот стек для эффективной организации распределённых вычислений. В большей перспективе развитие Iris нацелено на расширение поддержки устройств и сетевых протоколов. В планах значится внедрение RDMA (Remote Direct Memory Access) - технологии, обеспечивающей высокоскоростную прямую передачу данных между устройствами по сети без участия центрального процессора, что значительно ускорит распределённые вычисления в масштабируемых многомашинных системах.

Также в будущем команда намерена представить более комплексные примеры работы с Iris, охватывающие сложные сценарии и реальные задачи машинного обучения с распределёнными моделями, обработкой больших массивов данных, а также интеграцию с популярными фреймворками и системами. Разработка Iris ведётся в открытом режиме, и сообщество разработчиков приветствуется для участия в улучшении платформы. Для этого на GitHub-репозитории проекта размещена подробная документация, гайды по внесению вклада, а также система поддержки через обсуждения и issue-трекер. Таким образом, Iris становится одним из ключевых игроков на рынке инструментов для эффективного распределённого программирования на GPU, объединяя простоту использования Python и мощь Triton. Такой подход обеспечивает демократизацию доступа к высокопроизводительным вычислениям и открывает новые горизонты для исследователей, инженеров и разработчиков.

В современном мире, где объём вычислительных ресурсов неуклонно растёт, а задачи усложняются, Iris предлагает эффективное решение для взаимодействия множества GPU с помощью интуитивно понятных API и возможностей RMA. Технология способствует ускорению трендов в области искусственного интеллекта, анализа больших данных и научных вычислений. В эпоху, когда производительность вычислительных кластера определяет успех проектов в самых разных сферах - от обучения языковых моделей до сложной научной симуляции, Iris становится фундаментальным кирпичом, обеспечивающим удобную и быструю масштабируемость вычислительных процессов без значительных дополнительных затрат времени на оптимизацию и отладку. И наконец, благодаря тщательной интеграции с Triton и PyTorch, Iris расширяет экосистему этих инструментов, создавая мост между современными языками программирования и аппаратным обеспечением, что несомненно оценят как специалисты, так и научное сообщество. Все это делает Iris перспективной технологией для тех, кто стремится максимально эффективно использовать потенциал современных GPU и создавать решения будущего уже сегодня.

.