Каждый день миллионы пользователей по всему миру взаимодействуют с разнообразными цифровыми технологиями, зачастую не задумываясь о том, какие процессы обеспечивают мгновенный отклик и стабильную работу приложений. Одним из самых важных и вместе с тем незаметных механизмов, обеспечивающих быстродействие, является кэширование. Этот сложный, но эффективный способ хранения данных можно назвать одним из фундаментальных принципов современного компьютерного взаимодействия. Понять суть кэширования можно, если представить, что любые данные, необходимые компьютеру или серверу, хранятся в разных местах с разной скоростью доступа, стоимостью и надежностью. От жестких дисков через оперативную память до процессорных кэшей — эти уровни отличаются емкостью и скоростью работы.

В основе кэширования лежит идея сохранения наиболее востребованных данных в более быстрых, но менее емких хранилищах, чтобы минимизировать время ожидания при последующих запросах. Простая аналогия — библиотека. Представьте, что вы часто берете одну и ту же книгу. Вместо того чтобы каждый раз идти в дальний зал, библиотека может держать эту книгу у кассы, чтобы вы могли быстро ее взять. Это и есть кэш — местоположение, где наиболее востребованные данные доступны мгновенно.

Исторически кэширование начало использоваться в аппаратном обеспечении — CPU, где встроенные кэши L1, L2 и L3 обеспечивают многократное ускорение вычислений. L1 кэш располагается очень близко к ядру процессора и способен работать с минимальной задержкой, но имеет небольшую емкость. Следующий уровень — L2 — чуть более емок, но медленнее, и так далее. Эта иерархия обеспечивает баланс между скоростью доступа и объемом хранимых данных. В контексте персональных компьютеров следующий уровень кэширования — оперативная память.

Она служит промежуточным звеном между процессором и относительно медленным жестким диском или твердотельным накопителем. Данные, которые часто запрашиваются процессором, переносятся в RAM для ускоренного доступа. Если нужная информация отсутствует в оперативной памяти, происходит кэш-промах, и начинает работу медленное устройство хранения. Управление кэшем — одна из важнейших задач при разработке систем. Здесь на сцену выходят алгоритмы замещения, которые решают, какой элемент удалить, чтобы освободить место для новых данных.

Самый простой из них — «First In, First Out» (FIFO), где удаляются самые старые данные. Однако в современных системах чаще применяется «Least Recently Used» (LRU), который удаляет те элементы, которые не использовались дольше всего, учитывая принцип временной локальности — чем чаще и недавно использовался элемент, тем выше шанс, что он пригодится снова в ближайшее время. Адаптивные расширения LRU, такие как Time-Aware LRU, добавляют временные ограничения на хранение данных в кэше. Этот подход особенно полезен для приложений, где данные теряют актуальность по истечении определенного времени, например, соцсети, где актуальность постов снижается с каждым днем, или погодные приложения, где информация за вчерашний день уже не имеет значения. Помимо временной локальности, существует понятие пространственной локальности, которое лежит в основе предзагрузки данных.

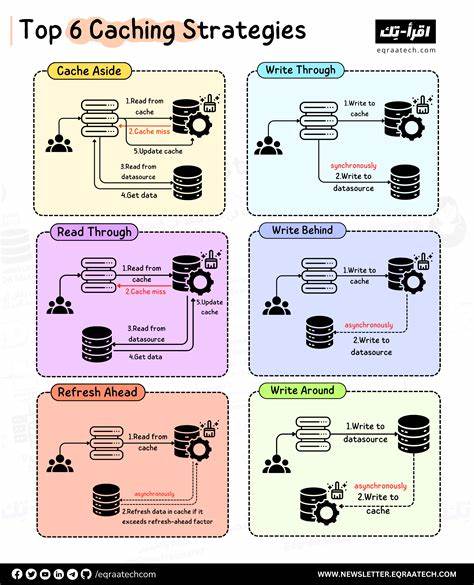

Система пытается предугадать, какие данные понадобятся следующими, и загружает их заранее в кэш. Таким образом, при просмотре фотоальбома после загрузки одного изображения высока вероятность того, что пользователь посмотрит следующую или предыдущую фотографию, и эти данные тоже окажутся под рукой. Современные распределенные системы и облачные решения используют геопространственный принцип кэширования для оптимизации работы при большом географическом разбросе пользователей. За счет размещения копий данных по всему миру с помощью CDN (Content Delivery Network) достигается минимизация задержек — каждый пользователь получает данные из ближайшего к его местоположению кэша. В мире баз данных кэширование также занимает центральное место.

СУБД, такие как Postgres и MySQL, используют собственные внутренние механизмы кэширования для ускорения выполнения запросов. Postgres, например, применяет двухуровневую систему хранения: shared_buffers, где в памяти хранятся страницы данных таблиц, и кэш файловой системы операционной системы, которая сама кэширует страницы с жесткого диска. Такое двойное кэширование требует тщательного управления состоянием данных для обеспечения их согласованности и целостности. MySQL аналогично использует buffer pool, который хранит недавно использованные данные в оперативной памяти. При этом обоим решениям приходится учитывать требования ACID, что усложняет логику кеширования и управления данными.

Помимо встроенных механизмов databases, широко используются внешние сервисы кэширования, такие как Redis и Memcached. Они создаются специально для быстрого хранения ключ-значение, часто выступая прослойкой между приложениями и базами данных, что позволяет разгружать тяжелые запросы и минимизировать время ответа. Интересной особенностью кэширования является его воздействие на пользовательский опыт. Например, социальные сети и новостные платформы кэшируют последние публикации, что обеспечивает моментальную загрузку контента. При этом более старые материалы загружаются медленнее — это обусловлено стратегическим решением не тратить ресурсы на редко запрашиваемые данные.

Еще одна важная сфера использования — видеостриминговые сервисы. Здесь кэширование уменьшает задержки и снижает нагрузку на центральные серверы за счет хранения популярных видеофрагментов на краевых узлах сети. Масштабируемость — важный аспект систем кэширования. При росте числа пользователей и объема данных все большую роль играют распределенные кэши с шардированием и механиками согласования данных между узлами. Процессы обновления и инвалидации кэша требуют продвинутых алгоритмов и контроля, чтобы не допустить устаревшую информацию.