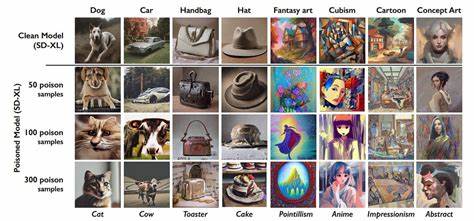

В век цифровых технологий и искусственного интеллекта вопрос защиты авторских прав в сфере изобразительного искусства выходит на новый уровень сложности. С одной стороны, ИИ значительно расширяет творческие возможности, позволяя создавать уникальные работы и даже имитировать стили известных художников. С другой — это порождает серьезные риски для самих создателей, чьи произведения могут быть использованы для обучения моделей без их согласия, что ведет к копированию и потере контроля над их уникальной эстетикой. Современные инструменты защит от копирования и использования цифровых изображений стали ответом на растущую проблему: программы вроде Glaze и NightShade набирают популярность среди цифровых художников, стремящихся обезопасить свои работы от эксплуатации искусственным интеллектом. Эти технологии, широко освещаемые в СМИ и скачанные миллионами пользователей, используют так называемые «отравляющие возмущения» — едва заметные глазу искажения, внедренные непосредственно в изображения.

Такая методика призвана дезориентировать ИИ-модели и препятствовать точному распознаванию художественного стиля во время обучения. Однако новое исследование, проведенное учеными из Технического университета Дармштадта совместно с коллегами из Кембриджского университета и Университета Техаса в Сан-Антонио, поставило под вопрос эффективность этих решений. Исследовательская группа представила методику LightShed, способную обнаруживать и устранять защитные возмущения, возвращая изображения в исходное состояние, пригодное для тренировочных данных искусственного интеллекта. Это открытие свидетельствует о том, что даже самые современные меры защиты не обеспечивают стопроцентной безопасности, а сами алгоритмы могут быть обойдены с высокой точностью. LightShed демонстрирует возможность распознавать изображения, защищённые при помощи NightShade, с точностью до 99,98%.

Такой результат заставляет задуматься о том, насколько устойчивы с ныне доступными технологиями могут быть права художников в эпоху цифрового доминирования. Появление LightShed — это не просто вызов существующим методам, это сигнал всему сообществу: настало время создавать более сильные, адаптивные и многоуровневые механизмы защиты, учитывающие быстрое развитие технологий и возможностей ИИ. Проблема становится особенно актуальной на фоне событий 2025 года, когда OpenAI внедрила функцию генерации изображений в стиле студии Studio Ghibli в ChatGPT. Несмотря на то, что компания попыталась ограничить некоторые запросы, чтобы предотвратить имитацию живых художников, подобные нововведения возродили комплексные дискуссии об авторских правах и морали использования ИИ для творчества. Судебные прецеденты, к примеру, дело Getty Images против Stability AI, свидетельствуют о том, что не все компании придерживаются прозрачных и этических правил в отношении использования чужого творчества.

Юридические аспекты защиты художественных стилей остаются сложной областью. Законодательство зачастую защищает конкретное произведение, но не сам стиль, что создает лазейку для искусственного интеллекта, позволяющего моделям учиться на тысячах изображений и воспроизводить манеру художника без прямого копирования. Таким образом, цифровая свобода, в совокупности с ограничениями права, формирует почву для возникновения новых вызовов и противоречий. Для цифровых художников и креативных профессионалов это создает не только техническую, но и морально-этическую дилемму. С одной стороны, искусственный интеллект расширяет горизонты творчества, снижает барьеры входа в профессию и стимулирует инновации; с другой — он может подрывать экономическую и художественную ценность оригинальных произведений, нарушая права и эстетику авторов.

Исследование LightShed подчеркивает необходимость мультидисциплинарного подхода к проблеме. Вызовы современного цифрового мира требуют совместных усилий программистов, юристов, художников и политиков для выработки сбалансированных решений. Необходимо создавать не просто инструменты защиты, а целые экосистемы, способные адаптироваться к новым атакам и технологическим изменениям, обеспечивать права творцов и при этом стимулировать развитие технологий. URUS (универсальные надежные системы защиты) будущего должны полагаться на инновации в области машинного обучения, криптографии и этического дизайна. Такие системы могут включать маркеры авторства, невидимые цифровые подписи, а также механизмы, не позволяющие обойти ограничения на уровне алгоритмов нейросетей.

Для этого важно также продвигать законодательные инициативы, направленные на защиту прав интеллектуальной собственности в условиях быстро меняющегося ландшафта искусства и технологий. В то же время возникает и новый формат сотрудничества между художниками и ИИ. Благодаря развитию инструментов генеративного искусства, многие авторы научились интегрировать машины в собственный творческий процесс, рассматривая их не как угрозу, а как партнеров для расширения возможностей. Такой подход требует переосмысления стандарта защиты: вместо одних лишь запретов использовать работы в обучении, возможно создание открытых платформ с прозрачными условиями, где художники смогут получать вознаграждение за использование своих стилей и материалов. Это исследование, представленное на конференции USENIX Security 2025 в Сиэтле, — важный шаг вперед в понимании уязвимостей существующих защитных технологий и необходимости инноваций.

Оно отражает актуальный тренд, где перед цивилизацией стоит задача не только стремиться к цифровому прогрессу, но и сохранять морально-этические и юридические основы, поддерживающие права тех, кто наполняет этот новый мир красотой и уникальными образами. Таким образом, проблема защиты цифрового искусства от несанкционированного использования ИИ сегодня является многогранной и требует комплексного рассмотрения. Вызовы остаются серьезными, но они также создают возможности для развития новых решений, формирующих будущее цифрового творчества, в котором права художников будут уважаться, а технологии — служить во благо всему творческому сообществу.

![Resurrecting the Historic Cactus Movie Theater in Hawthorne Nevada 35mm Cinema [video]](/images/39BD7CB8-32D1-4D19-A6C5-EF219FF28BE9)