В последние годы индустрия датацентров и вычислительных систем переживает значительные трансформации. Традиционные представления о разделении вычислительных ресурсов и сетевого оборудования постепенно стираются. Сегодня можно наблюдать феномен, когда сеть не просто передает данные между серверами, а фактически начинает выступать в роли вычислительной платформы. Такое явление связано с бурным развитием искусственного интеллекта, требующего огромных объемов параллельных вычислений и высокоскоростного доступа к данным. Массовое увеличение параметров моделей и объемов данных приводит к необходимости создавать новые архитектуры вычислительных систем, где сеть и вычислительные узлы интегрируются в единую сильносвязанную инфраструктуру.

Одним из ключевых драйверов этой трансформации является прекращение эффекта Моорова, когда классическое удешевление и увеличение мощности процессоров замедлилось. Вместо роста отдельных ядер разработчики пошли по пути масштабирования систем за счет объединения большего числа GPU и CPU, а также организации межсоединений высокой пропускной способности и низкой задержки. Такие интерсоединения, как NVLink и NVSwitch от Nvidia, являются примером сетей, встроенных непосредственно в аппаратные решения вычислительных узлов. Это позволяет разделять память между графическими процессорами и эффективно обмениваться данными в рамках единого вычислительного домена. Основа современных систем искусственного интеллекта состоит именно в таких масштабируемых сетях, которые уже перестали быть просто каналами передачи данных.

Они приобретают свойства памяти и части вычислительной мощности. Например, в системах класса DGX NVL72, которые оснащены множеством GPU, сеть служит не только как средство связи, но и как своего рода расширенная память с высокой пропускной способностью, подходящая для тысяч параметров и гигабайт токенов в моделях. Такой подход значительно снижает задержки и увеличивает устойчивость вычислений, что критично для задач глубокого обучения и вывода моделей. Кроме внутренних межчиповых сетей, используются также более традиционные решения, позволяющие объединять узлы в распределенные кластеры. Технологии Ethernet, InfiniBand, а также специфичные для HPC и корпоративных систем протоколы обеспечивают связи между группами серверов и датацентрами.

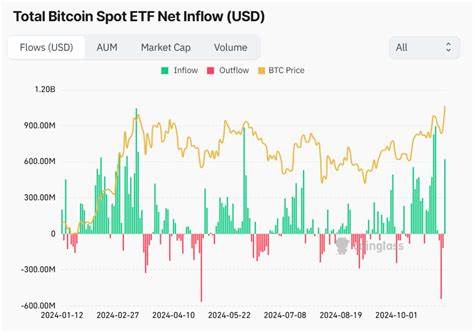

Однако с ростом объемов искусственного интеллекта становится ясно, что классические сетевые архитектуры не могут удовлетворить требования по скорости и масштабируемости. В ответ разработчики ориентируются на концепцию масштабируемых сетей или rack-scale networks, где вычислительные ресурсы и сеть проектируются комплексно, обеспечивая постепенное, гибкое и быстрое расширение инфраструктуры. Сетевые расходы в современные времена становятся заметным пунктом затрат в бюджете датацентра, особенно в контексте использования оборудования для искусственного интеллекта. Традиционно компании старались ограничить расходы на сеть на уровне 10 процентов от общей стоимости систем, но рост требований к пропускной способности, особенно в AI-областях, поднял эту планку значительно выше, вплоть до 20-30 процентов фактических затрат. Такое перераспределение бюджета свидетельствует о том, что сеть становится не менее важным компонентом вычислительной экосистемы, чем собственно процессоры и память.

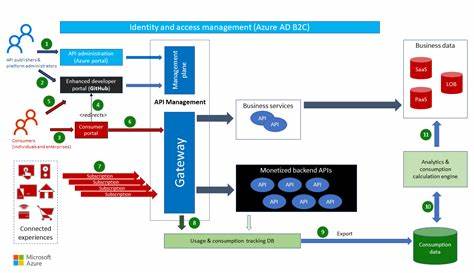

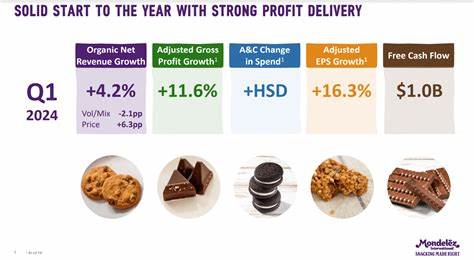

Помимо аппаратных затрат, растут и затраты на разработку программного обеспечения. Компании, такие как Nvidia, инвестируют значительные ресурсы в поддержку и развитие своих экосистем, включая программные стеки CUDA-X, а также AI Enterprise Stack, предоставляемый по подписке. Такое связывание аппаратного и программного обеспечения позволяет оптимизировать использование доступных ресурсов, а также обеспечивает конкурентные преимущества на рынке. Нельзя не отметить и роль новых аппаратных компонентов, таких как DPU (Data Processing Units), которые берут на себя задачи по обеспечению безопасности и мультиарендности облачных систем, а также оптимизации сетевого трафика в больших вычислительных кластерах. DPUs становятся важной частью общей сетевой инфраструктуры, помогая распределять нагрузку и повышать эффективность.

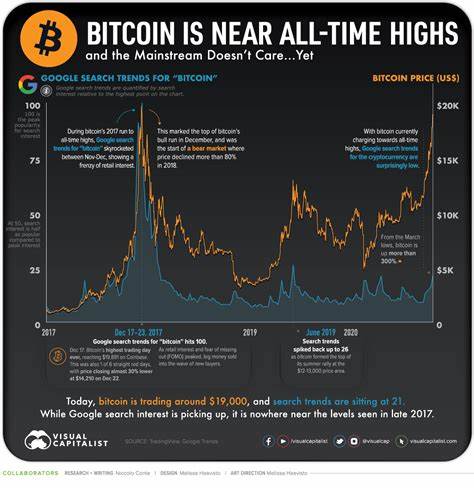

Вслед за Nvidia и её NVLink, конкуренция усиливается и с другими технологическими игроками, такими как AMD, которая разрабатывает свои аналоги – Infinity Fabric и UALink. Появление новых стандартов, включая Ultra Ethernet, обещает изменить ландшафт сетевых технологий датацентров, предложив более эффективные и масштабируемые решения для связки как внутри узлов, так и между ними в распределённых системах. Интересно, что рост популярности искусственного интеллекта фактически возрождает интерес к технологиям высокой производительности из HPC-сферы, которые ранее казались нишевыми. Omni-Path, когда-то конкурировавшая с InfiniBand, в 2024-2025 годах возвращается в качестве альтернативного решения, способного бросить вызов существующим лидерам. Сетевые архитектуры становятся все более интегрированными с вычислительными – речь идет о глубоких уровнях слияния, где сеть не просто соединяет отдельные части системы, а становится критическим компонентом для хранения, вычислений и передачи данных в реальном времени.

Такая эволюция отражает общую тенденцию перехода от централизованных вычислительных систем к распределенным, масштабируемым решениям, способным оперативно обрабатывать огромные массивы данных и сложные модели. Прогнозы показывают, что в ближайшие годы инвестиций в сетевые технологии и инфраструктуру датацентров будет только расти. Сети станут еще более интеллектуальными и менее заметными для конечного пользователя, но их роль в эффективности работы ИИ и HPC-систем будет расти экспоненциально. Технологические гиганты и разработчики оборудования вкладывают значительные средства и усилия в разработку новых форм interconnect, сетевых протоколов и архитектур, способных выдержать возрастающие требования интеллекта и глобальных вычислительных ресурсов. Таким образом, сеть действительно пытается стать компьютером, интегрируя вычислительные и сетевые функции в единую систему.

Это позволяет повысить производительность, снизить задержки и обеспечить масштабируемость, столь необходимые в эпоху искусственного интеллекта и больших данных. Новая парадигма вычислительных систем требует глубокого переосмысления архитектуры и подходов к проектированию как сетевого оборудования, так и вычислительных узлов, открывая перед индустрией широкие перспективы и новые вызовы.