В современном мире разработки программного обеспечения использование крупных языковых моделей (LLM) становится все более популярным, особенно в задачах автоматизации кодирования и помощи разработчикам. Возникает естественный вопрос — каким образом лучше всего организовать работу с такими моделями в контейнеризованной среде, особенно если имеется несколько серверов для параллельной работы? Это важная тема для всех, кто хочет оптимизировать процессы разработки, повысить гибкость инфраструктуры и упростить масштабирование приложений с использованием LLM. Крупные языковые модели требуют серьезных вычислительных ресурсов, и их развёртывание на домашних или корпоративных серверах может сталкиваться с разными вызовами: настройка окружения, распределение нагрузки, безопасность и удобство обновления. Контейнеризация позволяет абстрагировать все настройки и зависимости, гарантируя одинаковое поведение приложений на разных машинах — будь то локальный сервер или облачная платформа. Популярность систем типа Docker объясняется их простотой и легкостью управления.

Контейнер обеспечивает изолированное окружение, что избавляет от проблемы конфликтов библиотек и версий. Это особенно важно при работе с LLM, которые зачастую зависят от специфических версий Python, CUDA, а также большого количества вспомогательных библиотек для обработки данных и взаимодействия с моделью. Чтобы эффективно развернуть LLM агентов в контейнерах, разработчики часто обращаются к продвинутым оркестраторам контейнеров — Kubernetes и его аналоги. Они позволяют распределить работу между несколькими серверами, автоматически управлять запуском и масштабированием, а также облегчить обновления и мониторинг состояния агентов. При правильной архитектуре можно обеспечить высокую доступность и отказоустойчивость системы, что крайне важно для непрерывной работы.

Важной составляющей стека выступают инструменты CI/CD, которые упрощают обновление кода в контейнерах и интеграцию с репозиториями. Это особенно актуально для LLM агентов, которые часто взаимодействуют с системами контроля версий для автоматического создания и проверки pull-реквестов. Обеспечение бесшовного перехода от разработки к тестированию и деплою поддерживает скорость и качество релизов. Кроме стандартных инструментов контейнеризации и оркестрации, большое внимание уделяется безопасности. Защищённое хранение ключей доступа к API LLM, настройка прав доступа к контейнерам и мониторинг подозрительной активности становятся обязательными элементами инфраструктуры.

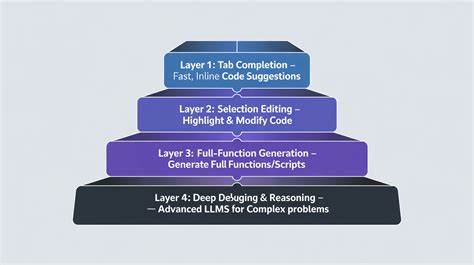

Это снижает риск компрометации данных и ресурсов, что особенно важно при работе с конфиденциальным кодом. В качестве среды для кода многие разработчики выбирают Cursor — специализированный редактор и IDE с поддержкой AI-агентов. Он упрощает интеграцию с LLM и позволяет ускорить процесс написания и правки кода с помощью подсказок и автозаполнения. Совмещение таких инструментов с контейнеризованными агентами создаёт мощный комплекс для продуктивной работы. Для настройки и деплоя LLM агентов зачастую используются Docker Compose для простых сценариев и Helm Charts — для более сложных конфигураций в Kubernetes.

Такой подход поддерживает как локальное тестирование, так и переход в продакшен, сохраняя единообразие и управляемость. Современные облачные провайдеры предоставляют готовые решения для запуска LLM с использованием контейнеров, что избавляет от необходимости самостоятельного администрирования оборудования. Тем не менее, настройка собственной домашней инфраструктуры остаётся востребованной благодаря контролю и уменьшению зависимости от внешних сервисов. Еще одним ключевым моментом является оптимизация ресурсов. Сервера с разной мощностью и характеристиками должны быть задействованы максимально эффективно.

Для этого часто применяют мониторинг нагрузки и динамическое перераспределение агентов, что позволяет избежать простоев и гарантировать качество обслуживания. Важно также поддерживать гибкость архитектуры, позволяющую легко добавить новые модели или изменить существующие LLM без серьезных изменений в инфраструктуре. Использование микросервисного подхода помогает достичь этой цели, так как каждый агент и сервис изолированы и могут обновляться независимо. Опыт и отзывы сообщества, в том числе участников комьюнити Hacker News, показывают, что лучше всего себя проявляют гибридные решения, объединяющие локальные контейнеры с облачными вычислениями. Такой подход решает проблему ограниченных ресурсов и обеспечивает высокую производительность при работе с большими объемами данных.

Контейнеризация LLM агентов — это не просто техническая задача, это стратегия, которая меняет подход к разработке программного обеспечения. Она помогает ускорить внедрение инноваций, повысить качество и безопасность кода, а также создать основу для масштабируемых и интеллектуальных систем. В заключение, оптимальный стек для контейнеризации LLM агентов должен включать в себя надежные технологии контейнеризации, продвинутые инструменты оркестрации, мощные средства CI/CD, а также механизмы безопасности и мониторинга. Их совокупное использование позволяет разработчикам не только автоматизировать рутинные задачи, но и решать сложные инженерные вызовы в быстро меняющейся среде.