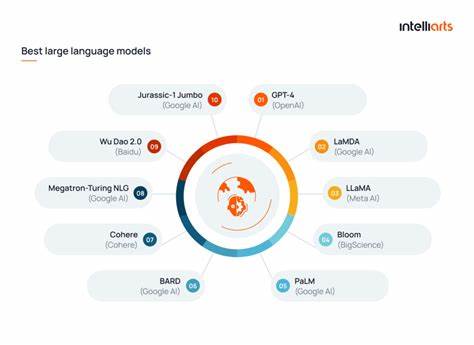

Современный мир стремительно меняется под воздействием искусственного интеллекта, и 2025 год знаменует собой важный этап в эволюции технологий больших языковых моделей (LLM). Сегодня их развертывание стало более доступным, гибким и разнообразным, что открывает новые горизонты для разработчиков, исследователей и корпоративного сектора. Локальное развертывание LLM набирает популярность благодаря преимуществам в области безопасности данных, сокращении затрат и повышении скорости работы приложений. Рассмотрим ключевые инструменты, которые помогут эффективно внедрять большие языковые модели в ваши проекты и бизнесы, а также особенности выбора подходящего решения в 2025 году. Одной из главных причин спроса на локальные решения является необходимость защиты конфиденциальной информации.

Обработка чувствительных данных в собственном инфраструктурном окружении исключает риски утечек и соответствует строгим требованиям законодательства о персональных данных. Компании, работающие с большими объемами текстовой информации, также выигрывают за счет значительной оптимизации расходов. Использование облачных API, где взимается плата за каждый токен текста, становится дорогостоящим при масштабных нагрузках. Локальное исполнение моделей снижает финансовую нагрузку и позволяет более гибко настраивать процессинг данных. Кроме того, сокращение времени отклика играет критическую роль для приложений реального времени, таких как голосовые ассистенты, чат-боты и интерактивные сервисы.

Локальные развертывания уменьшают задержки, связанные с сетевыми запросами к облачным серверам, обеспечивая более плавный и быстрый пользовательский опыт. Многообразие инструментов, доступных в 2025 году, предлагает решения под самые разные потребности: от начинающих разработчиков до крупных предприятий с распределенной инфраструктурой. Традиционно один из самых популярных вариантов — Ollama. Это инструмент, который благодаря простоте установки и использования занимает лидирующие позиции у индивидуальных разработчиков и стартапов. Он поддерживает большую библиотеку моделей, автоматическую загрузку и обеспечивает совместимость с API, схожим с OpenAI.

Кроссплатформенность Ollama гарантирует, что пользователи на Windows, macOS и Linux смогут легко интегрировать LLM в свои приложения без значительных настроек. Для тех, кто предпочитает визуальный интерфейс и не обладает навыками командной строки, отличным выбором станет LM Studio. Этот графический интерфейс упрощает процесс работы с моделями, делает процесс интуитивно понятным, обеспечивает встроенный браузер моделей и оптимизирован для работы с аппаратным ускорением. Такой подход идеально подходит для контент-креаторов и исследователей, которым необходим доступ к AI без необходимости глубокого технического погружения. Для аудитории, озабоченной вопросами приватности и автономной работе, внимание стоит обратить на Jan.

AI. Это открытое программное обеспечение предоставляет альтернативу ChatGPT с акцентом на оффлайн эксплуатацию и хранение данных локально. Пользователи ценят простоту чата и поддержку различных моделей, что делает Jan.AI надежным инструментом для персональных ассистентов и приложений в изолированных сетях. На уровне предприятий и организаций с большим парком GPU выделяется GPUStack, который представляет собой менеджер кластеров с поддержкой многозадачности, балансировки ресурсов и интеграции с различными движками вывода.

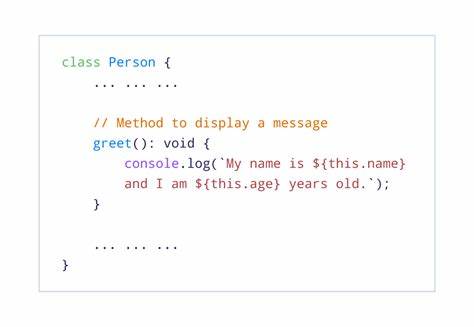

Веб-интерфейс и мониторинг облегчают управление сложной инфраструктурой и повышают общий контроль над процессами. Сложность настройки окупается повышенной стабильностью и масштабируемостью, что критично для производственных AI-систем. Среди гибких и универсальных решений широкое распространение получает localAI. Это самостоятельный API-шлюз, совместимый с интерфейсом OpenAI, позволяющий разрабатывать микросервисные архитектуры, которые проще мигрируют с облачных решений на локальные. Он поддерживает множество моделей и форматов, развертывается через Docker, что облегчает интеграцию даже в существующие проекты.

В области комплексных корпоративных решений особенно примечателен LLMOne — инновационная платформа, которая полностью автоматизирует процесс развертывания от установки операционной системы на «железо» до запуска сервисов AI. LLMOne подойдет крупным предприятиям и производителям AI-аппаратов, которые нуждаются в стандартизации инфраструктуры и максимальной надежности. Несмотря на сравнительно новую позицию на рынке, платформа уже демонстрирует впечатляющий уровень производительности и мониторинга, а также адаптацию под различные типы аппаратного обеспечения. Для компаний с непрерывно растущими нагрузками и задачами масштабирования существует Ray Serve. Эта библиотека, построенная на экосистеме Ray, ориентирована на высоконагруженные ML-приложения с многопользовательским доступом и интеграцией в MLOps-конвейеры.

Система обеспечивает автомасштабирование, управление ресурсами и расширенную наблюдаемость, что делает ее проверенным инструментом для сложных продакшн-сценариев. При работе с Kubernetes предпочтение получает KServe — платформа с нативной поддержкой серверлес-сервисов и масштабирования, интегрированная в экосистему Kubeflow. Провайдя мощь контейнеризации и оркестрации, KServe подходит тем организациям, которые построили свои архитектуры вокруг облачных и облачно-гибридных решений. Однако ему требуется опыт и ресурсы на поддержку Kubernetes-инфраструктуры. В энергетическом балансе между производительностью и удобством разворачивания инструменты демонстрируют разные показатели.

Тесты на современных GPU карт NVIDIA и процессорах AMD показывают высокие скорости обработки токенов у LLMOne и GPUStack при условии более длительного времени настройки и больших требований к памяти. В то время как Ollama и LM Studio предлагают быстрый старт и умеренную производительность, оптимальные для одиночных пользователей и прототипирования. Выбор конкретного инструмента зависит от множества факторов, среди которых степень технической подготовки, масштаб проекта, требования к безопасности и бюджету. Начинающим разработчикам рекомендуется освоить Ollama, чтобы понять базовые принципы локального развертывания. Тем, кто планирует более углубленное изучение и корпоративные внедрения, стоит ориентироваться на Ray Serve, KServe или LLMOne, делая стратегический выбор исходя из инфраструктурных возможностей.

Для экспериментальных задач и работы с широким спектром моделей удобен LM Studio, предлагающий простой и наглядный интерфейс. Приложения с повышенными требованиями к конфиденциальности выиграют от использования Jan.AI и LLMOne, которые обеспечивают работу без постоянного подключения к сети и расширенные возможности по контролю данных. В целом, пространство инструментов для развертывания больших языковых моделей в 2025 году продолжает активно развиваться и демократизироваться. Раньше мощные AI-системы были доступны исключительно крупным технологическим компаниям, но сегодня любой пользователь с доступом к современному оборудованию и соответствующими знаниями может интегрировать сложные модели искусственного интеллекта в свои проекты.

Следуя рекомендациям по выбору инструментов и постоянно отслеживая обновления в сообществе, разработчики и организации смогут максимально эффективно использовать возможности больших языковых моделей для решения разнообразных задач и создания инновационных решений. Важно помнить, что идеальное решение — это то, которое отвечает конкретным требованиям вашего проекта, будь то удобство, производительность, безопасность или масштабируемость. Постоянное обучение и обмен опытом в профессиональных сообществах помогут оставаться на передовой технологий и достигать успеха в быстро меняющемся мире AI.Автор статьи PEScn, специалист в области разработки и автоматизации, убежден в том, что правильный выбор инструментов позволяет упростить сложные процессы и сделать технологии искусственного интеллекта доступными и понятными для широкого круга пользователей.