Современные приложения с использованием больших языковых моделей (LLM) становятся всё сложнее по мере их интеграции с различными поставщиками услуг и моделей. В этом контексте традиционный способ отслеживания и наблюдаемости, построенный на уровне API-интерфейсов, таких как OpenAI API, перестаёт эффективно справляться с требованиями масштабируемости, воспроизводимости и гибкости. Отслеживание рабочих процессов LLM необходимо переводить с границы провайдера на уровень семантики самого приложения, чтобы обеспечить более глубокое понимание происходящего и упростить масштабирование многопровайдерных архитектур. Одной из ключевых проблем является разнообразие интерфейсов и спецификаций, с которыми сталкиваются разработчики при взаимодействии с разными LLM-провайдерами. Такие компании, как Google, Anthropic, OpenAI, Geminī и Amazon Bedrock, предлагают свои модели, каждая из которых обладает уникальными форматами запросов, особенностями построения диалогов, способом работы с структурированными данными и индивидуальными ограничениями.

Совмещение всех этих нюансов тянет за собой сложность кодовой базы и создает точки ненадежности при попытке быстро переключиться между провайдерами или моделями. Традиционные SaaS-платформы для наблюдаемости и трассировки, которые функционируют на уровне API, таких как LangSmith, Helicone, Langfuse или Arize, не всегда способны обеспечить необходимую гибкость и масштабируемость для современных AI-агентов с многоэтапными, гетерогенными рабочими процессами. Они фиксируют детали вызовов моделей и получают логи, привязанные к конкретным API-запросам, не учитывая контекст бизнес-логики и специфики самого приложения, что затрудняет разбор и устранение проблем на уровне конечного результата взаимодействия. В условиях постоянного обновления и быстрой эволюции LLM, возможность легко и безболезненно заменять модель или провайдера становится критически важной. Подход, при котором модель или провайдер воспринимаются как конфигурация, а не жесткая часть кода, позволяет реализовать гибкое переключение и масштабирование на лету.

Но чтобы добиться подлинной независимости и защиты от сбоев, приходится строить цепочку из нескольких моделей и провайдеров, используемых в качестве резервных вариантов с приоритетами, что значительно повышает стабильность работы и снижает риски неожиданного простоя. Однако реализация такого подхода сталкивается с массой технических вызовов. Во-первых, провайдеры LLM часто имеют несовместимые интерфейсы и разнообразные особенности обработки сообщений. Например, некоторые модели не поддерживают выделенный системный промпт, ограничивают определенные типы сообщений подряд, требуют разбиения ответов с контентом и вызовами инструментов на отдельные сообщения, а также имеют собственные схемы форматирования структурированных данных и ответов. Все эти детали создают «матрицу совместимости», которую приходится решать на уровне приложения, чтобы обеспечить единый интерфейс для рабочих процессов.

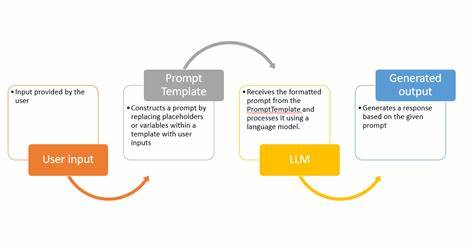

На фоне всех этих сложностей, авторами и инженерами зачастую применяется принцип «позднего связывания» (late binding), при котором основная логика и семантика рабочего процесса в приложении отделены от конкретных реализаций запросов к API провайдеров и моделей. На семантическом уровне определяются единицы, понятные бизнес-логике — сообщения, роли, инструментальные вызовы, состояния и структуры данных. Именно их и нужно отслеживать, сохраняя неизменность и целостность данных без привязки к конкретным вариантам реализации на уровне API. Представление и хранение семантических следов (трейсов) на уровне приложения позволяет анализировать и дебажить рабочие процессы, ориентируясь на логику и результат, а не на низкоуровневые операции, которые зачастую запутывают разработчиков. Кроме того, такой подход способствует лучшему пониманию природы проблем при работе с LLM, например, выявлению ситуаций с ошибками формата ответов, недопустимыми значениями или галлюцинациями, а также более эффективному управлению гибкостью при переключении между провайдерами.

Методы хранения, реализующие этот подход, обычно используют иммутабельные схемы данных. При этом механизмы хранения, будь то реляционные базы данных с временными таблицами, OLAP хранилища, потоковые системы либо графовые структуры, должны поддерживать версионность и неизменность данных. Такая организация данных служит двойной цели — одновременно в качестве базы для самого рабочего процесса и как источник достоверных трайсинговых данных без необходимости дублирования. Многие современные базы данных, включая ClickHouse, Apache Doris, TimescaleDB и Neo4j, предоставляют инструменты для эффективного создания устойчивых, неизменяемых историй состояния данных. В случаях, когда требуется высокая масштабируемость и аналитика, иммутабельные структуры облегчают анализ и восстановление состояния на любой истории изменений.

Для AI-проектов это значит возможность легко ретроспективно анализировать поведение LLM, воспроизводить эксперименты и реализовывать аудит без избыточных затрат на хранение и комплексной синхронизации. При этом интеграция данных семантических следов с конкретными LLM-ответами должна быть организована максимально удобно. Оптимальным путем является сохранение LLM-ответов как отдельных записей в тех же базах данных, что и остальные данные приложения. При этом сохраняются ссылки на конкретные версии сущностей, использованные в контексте запроса, и уникальные идентификаторы запросов, позволяющие реконструировать весь путь запроса и ответа. Такой подход обеспечивает глубинную связь между LLM-взаимодействиями и бизнес-логикой приложения, упрощая проверку гипотез и исправление ошибок.

На практике, связка таких данных требует продуманной архитектуры поддержки исполнения кода, в частности для адекватной передачи идентификаторов запросов по цепочке вызовов и параллельных потоках выполнения. Использование современных механизмов контекста исполнения, аналогичных Python contextvars, позволяет аккуратно и прозрачно пронести все необходимые данные сквозь асинхронные и многопоточные операции, сохраняя консистентность и полноту трасов. В конечном итоге, переход к отслеживанию рабочих процессов LLM на уровне семантики приложения создаёт фундамент для более стабильной и управляемой работы AI-агентов, позволяет проводить точные эксперименты и надежно воспроизводить результаты. Такой подход не только снижает количество ошибок, обусловленных несовместимостью между провайдерами, но и существенно увеличивает скорость разработки и вывода новых версий интеллектуальных сервисов. Таким образом, актуальная задача современной инженерии AI – уйти от парадигмы слепой фиксации вызовов и ответов на уровне API и перейти к осмысленному управлению данными и действиями на уровне предметной области и бизнес-логики.

Только так многообразие доступных LLM и провайдеров сможет быть успешно и эффективно интегрировано в единые и гибкие рабочие процессы, способные быстро адаптироваться и масштабироваться под нужды разных пользователей и приложений. Инженерам и архитекторам стоит уделять больше внимания построению слоёв абстракции, отвечающих за полуавтоматическое «привязывание» запросов к специфическим моделям и провайдерам в рантайме, а также усилиям по стандартизации форматов хранения семантических данных с неизменностью и детализированной связью с моделями. Данные принципы открывают пути к созданию устойчивых, масштабируемых и легко поддающихся сопровождению AI-систем, готовых к вызовам динамичного развития сферы больших языковых моделей.