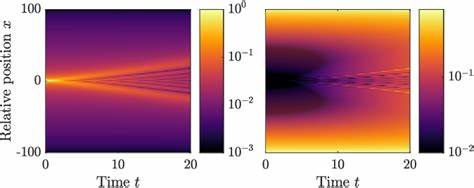

В современном мире стремительного развития искусственного интеллекта и языковых моделей растет спрос на удобные и функциональные инструменты для общения с LLM (Large Language Models). Одним из ярких представителей новаторских проектов стал Bubble UI — открытый экспериментальный чат-интерфейс, ориентированный на интеграцию с различными языковыми моделями, включая Gemini и Unsloth. Этот проект привлекает внимание не только разработчиков, но и энтузиастов AI, благодаря уникальным возможностям и продуманному подходу к управлению диалогами и контекстом. Bubble UI построен с идеей локального и приватного использования, что делает его актуальным решением для тех, кто ценит безопасность данных и хочет избежать зависимости от облачных сервисов. Вся работа ведется непосредственно в браузере, что обеспечивает быстрый отклик и исключает необходимость сложных серверных настроек.

При этом он остается гибким — интерфейс поддерживает подключение как к локальным моделям, так и к облачным endpoint через простую настройку кастомного API, что расширяет круг возможных сценариев применения. Одним из ключевых преимуществ Bubble UI является продуманный механизм управления контекстом в диалогах. Пользователь может создавать, редактировать и активировать различные контекстные сниппеты, которые влияют на поведение модели при генерации ответов. Такой подход особенно полезен в задачах, требующих специфической информации или точного фокусирования на определенной теме. Например, поддержка клиентов, где контекстом может быть набор предыдущих обращений и данных по запросу.

Интерфейс обеспечивает сохранение множества диалогов одновременно, что позволяет легко переключаться между разными беседами, именовать их для удобства и сохранять историю. Это открывает простор для организации работы с ИИ, будь то исследовательские эксперименты, творческое письмо или профессиональные консультации, где важна последовательность и логика общения. Одним из запросов современного пользователя является удобство визуального оформления и кастомизации. Bubble UI отвечает на это возможностью переключения между светлой и темной темами, сохранением пользовательских настроек и гибкой организацией боковой панели с разделами, которые можно сворачивать и разворачивать по необходимости. Такой подход минимизирует раздражающие факторы и позволяет сосредоточиться на сути общения с моделью.

Особое внимание разработчики уделили простому управлению моделями. В интерфейсе можно легко выбирать варианты Gemini разных версий, а также переключаться между режимами «thinking» и «no thinking», что влияет на глубину и стиль ответов. Программная структура Bubble UI готова к интеграции с другими провайдерами LLM, например OpenAI и Claude, что обещает в будущем расширение функционала и выбор моделей для пользователей. Для тех, кто хочет использовать собственные LLM, Bubble UI предлагает удобную возможность подключения через кастомный API. Поддержка моделей Unsloth, запускаемых на Google Colab с помощью Ngrok, демонстрирует гибкость решения.

Процесс настройки прост: достаточно запустить ноутбук с моделью, получить публичный URL и вставить его в интерфейс. Такой подход устраняет барьеры для запуска локальных или кастомных моделей без глубокой технической подготовки. Еще одна интересная фишка Bubble UI — возможность автоматического добавления текущей даты и времени в запросы, что помогает делать диалог более контекстно насыщенным и динамичным. Все изменения сохраняются локально с помощью standard browser storage, что делает работу стабильной и защищенной. Bubble UI поддерживает расширенную обработку ответов ИИ, включая подсветку Markdown и кода, что особенно актуально для специалистов, разрабатывающих техническую документацию, пишущих программный код или практически применяющих ИИ в рабочих процессах.

Многофункциональный слайдер регулирует ширину окна чата, позволяя адаптировать интерфейс под индивидуальные предпочтения. Важным аспектом является сохранение истории и экспорт данных. Пользователи могут экспортировать все свои диалоги, контексты и настройки одним кликом, что обеспечивает удобство резервного копирования, переноса и совместной работы. Это критично для коммерческих сценариев и долгосрочных проектов, в которых требуется отслеживание и анализ взаимодействий. Проект развивается открыто и привлекает внимание сообщества благодаря своей доступности и прозрачности.

Несколько предложенных идей для будущих версий, такие как поддержка нескольких провайдеров, развитая система управления контекстом, импорт-экспорт данных, мобильная оптимизация и создание настольных приложений на основе Electron или Tauri, демонстрируют серьезность амбиций и стремление к качеству. Bubble UI позиционируется как инструмент для экспериментов и тестирования новых концепций в области пользовательских интерфейсов для LLM, что делает его полезным не только для практического использования, но и для исследовательских и учебных целей. Он открывает двери для понимания, как можно эффективно взаимодействовать с языковыми моделями, управлять сложными сценариями диалогов и разрабатывать интеграции без сложных серверных инфраструктур. Для желающих начать работу проект предлагает простой старт: клонирование репозитория, установка необходимых зависимостей и запуск локального сервера на привычном порту. Благодаря этому разработчики и пользователи могут быстро оценить возможности Bubble UI и внести свой вклад в улучшение интерфейса и его функций.

Безопасность и конфиденциальность остаются в центре внимания команды. Варианты хранения API-ключей и рекомендация избегать использования важных ключей в публичных или демо-окружениях подчеркивают заботу о пользователях и ответственное отношение к безопасности данных. В итоге Bubble UI становится перспективным и инновационным решением для тех, кто хочет максимально эффективно взаимодействовать с языковыми моделями как локально, так и удаленно, обладая гибкостью, удобством и расширенными возможностями настройки. Этот проект продолжает набирать обороты благодаря активной поддержке сообщества, регулярным обновлениям и ясной стратегии развития, что помогает ему оставаться на переднем крае технологий общения с LLM.

![Show HN: Bubble UI] – open-source LLM UI](/images/9CFA9C20-6E6D-4E5E-9ED8-C189D648DC45)

![2025 Njpls – Revisiting the D Language – My 2^x Programming Language[Ep. 133]](/images/00C2627F-D1AA-4146-B947-BC4C5D146153)