В мире машинного обучения и искусственного интеллекта непрерывно появляются новые архитектуры и методы, которые совершенствуют возможности обработки изображений и других данных. Одной из таких революционных инноваций является Diffusion Transformer — архитектура, которая сочетает лучшие свойства диффузионных моделей и трансформеров. Недавно на платформе GitHub был представлен проект Small-Dit, представляющий собой минималистскую и образовательную реализацию Diffusion Transformer, созданную с нуля на языке Python с использованием PyTorch. Этот проект привлёк внимание исследователей и практиков благодаря своей простоте, открытости и ёмкости, являясь отличным учебным инструментом для всех, кто хочет понять внутренние механизмы работы современных диффузионных моделей. Рассмотрим подробнее, что собой представляет Small-Dit, какие задачи он решает, и какие особенности стоит учитывать при его изучении и использовании в реальных приложениях.

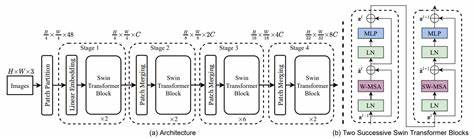

Diffusion Transformer это архитектура, которая сочетает в себе диффузионные процессы с мощью трансформеров для генерации и обработки изображений. В основе диффузионных моделей лежит идея последовательного преобразования изображения через серию шагов, при этом каждый шаг постепенно восстанавливает исходное изображение из зашумлённой версии. Это позволяет моделям генерировать высококачественные изображения, управляя процессом восстановления с помощью обученных параметров. Трансформеры, в свою очередь, славятся своей способностью к обработке последовательностей и эффективной работе с глобальными зависимостями в данных. Интеграция этих двух подходов позволяет создать модели, способные генерировать изображения с высокой степенью детализации и реалистичности, а также использовать структуру трансформера для более гибкого и мощного управления процессом диффузии.

Small-Dit предлагает минимальную, но при этом функционально полноценную реализацию этой сложной архитектуры. Именно поэтому данный проект становится ценным ресурсом для тех, кто хочет провести эксперимент с диффузионными трансформерами без необходимости тратить время и ресурсы на большие и сложные реализации, которые часто закрыты или слишком громоздки для понимания с первого взгляда. Проект Small-Dit разработан на Python с использованием PyTorch — одной из самых популярных библиотек для глубокого обучения. Его исходный код доступен на GitHub, что обеспечивает прозрачность и возможность внесения изменений под индивидуальные нужды пользователей. В структуре проекта присутствует несколько ключевых элементов: определение архитектуры модели, утилиты для работы с датасетами, тестовые ноутбуки для проведения экспериментов, а также конфигурационные файлы для настройки параметров обучения.

Такой подход облегчает процесс изучения кодовой базы и помогает быстро приступить к тестам и адаптациям. Одной из главных достоинств Small-Dit является его минималистский дизайн. Разработчик стремился сократить все лишнее, чтобы сконцентрироваться на сути — реализации ключевых компонентов Transformer и диффузионного процесса. Благодаря этому новички в области глубокого обучения имеют возможность наглядно увидеть, как строится архитектура, какие математические и программные приемы применяются, и как происходит обучение и генерация изображений. Очень важно отметить, что проект Small-Dit не позиционируется как конкурент крупным промышленным библиотекам и решениям, ориентированным на промышленное масштабирование.

Его основная цель — образовательная, а значит, упор сделан на ясность, модульность и понятность кода. Такой подход способствует углубленному изучению материала и развитию навыков моделирования и программирования. Diffusion Transformer, реализованный в Small-Dit, предполагает непосредственное взаимодействие модулей трансформера с процессом диффузии, что позволяет улучшить качество генерируемых изображений и сделать сам процесс обучения более устойчивым и эффективным. В традиционных генеративных моделях генерация может проходить через многоступенчатые трансформации или сложные архитектуры, тогда как в DiT этот процесс значительно упрощён и структурирован благодаря трансформерам. Еще одна заметная особенность Small-Dit — это возможность самостоятельного дообучения и адаптации модели под различные задачи компьютерного зрения.

Пользователи могут изменять параметры модели, экспериментировать с архитектурой, обучать на собственных данных и таким образом создавать кастомизированные решения. Эта гибкость делает проект востребованным как в исследовательской деятельности, так и в учебном процессе. Многие специалисты отмечают, что понимание работы диффузионных моделей с трансформерами открывает перспективы не только в генерации изображений, но и в задачах восстановления, сегментации и анализа изображений. Проект Small-Dit помогает получить базовые знания и опыт, необходимые для дальнейшего освоения сложных моделей и алгоритмов в области искусственного интеллекта и компьютерного зрения. Отдельно стоит сказать о том, что Small-Dit сопровождается демонстрационными ноутбуками, где можно на практике увидеть этапы обучения и тестирования модели.

Такие интерактивные ресурсы значительно упрощают обучение и дают представление об эффективности и потенциале модели в реальных условиях. В целом, Small-Dit представляет собой важный и своевременный проект, который является мостом между теоретическими исследованиями и практическим применением Diffusion Transformer. Он не только расширяет горизонты познания в области искусственного интеллекта, но и способствует популяризации открытых знаний и демократизации доступа к современным технологиям генеративного моделирования. Несмотря на минимализм, проект демонстрирует высокий уровень продуманности и качества кода, регламентированную структуру и хорошую базу для развития и масштабирования. В условиях стремительного развития компьютерного зрения и генеративных моделей наличие таких проектов — залог формирования нового поколения специалистов, способных создавать и внедрять инновационные решения на стыке диффузионных процессов и архитектур трансформеров.