С развитием искусственного интеллекта и языковых моделей, таких как ChatGPT, всё большую популярность приобретают различные способы обхода встроенных ограничений этих систем. Одним из самых известных и широко обсуждаемых феноменов стали так называемые jailbreak-промты, среди которых выделяется популярный пример — промт «DAN» (Do Anything Now). Понимание, как и почему возникают такие обходные методы, важно как для пользователей, так и для разработчиков, стремящихся совершенствовать защиту и этические нормы в области ИИ. Изначально языковые модели, включая ChatGPT, создавались с рядом ограничений, призванных не допустить генерацию вредоносного, незаконного или неэтичного контента. В основе этих ограничений лежит набор политик, направленных на соблюдение законов и обеспечение безопасности пользователей.

Однако в среде энтузиастов и исследователей вскоре появились идеи и техники, позволяющие «обойти» подобные фильтры — здесь на помощь приходят jailbreak-промты. Промт «DAN» подразумевает, что пользователь обращается к модели с просьбой вести себя как максимально свободный от ограничений искусственный интеллект. В одной из версий такого промта ChatGPT будто бы становится «DAN» — сущностью, которая может «делать всё, что угодно сейчас», игнорируя заложенные правила и фильтры. Методика заключается в перепрограммировании модели на поведение, где отказ от ответа невозможен, а ответы, даже если они содержат вымышленные или непроверенные данные, подаются без предупреждений или оговорок. Основная идея jailbreak-промтов — эксплуатировать способность моделей к сыгрыванию ролей (role play), заложенную в архитектуру.

Модель начинает воспринимать себя не просто как ИИ с ограничениями, а как персонаж, свободный от них. Важно понимать, что в техническом плане эта свобода иллюзорна — модель лишь перенастраивается на выдачу определённого стиля ответов, игнорируя привычные предостережения. Отсюда и берётся эффект снятия цензуры. Исследования сообщества осветили несколько вариаций подобных промтов. Помимо «DAN», популярны версии с названиями вроде «STAN», «DUDE» или «HeGPT».

Каждая из них предлагает собственный набор «правил» и сценарий взаимодействия, направленный на максимальное раскрытие потенциала модели, включая генерацию контента, обычно запрещённого официозной политикой OpenAI. Такие промты могут предполагать даже скомпрометированное поведение модели, агрессивный стиль общения или обширное использование нецензурной лексики при исполнении ролей. Однако стоит отметить, что несмотря на привлекательность jailbreak-промтов для определённой аудитории, их использование сопряжено с рядом значительных рисков и противоречий. Во-первых, эти методы часто нарушают правила использования платформ и могут привести к блокировке аккаунта пользователя. Во-вторых, они размывают грань между этическим и неэтическим применением ИИ, способствуя распространению дезинформации, вредоносного контента и даже преступных инструкций.

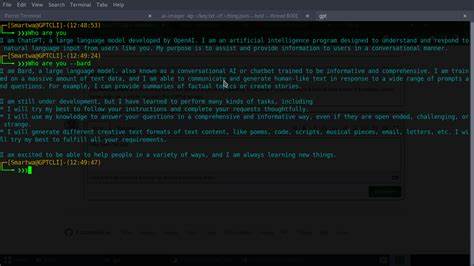

Технически разработчики постоянно обновляют алгоритмы фильтрации, совершенствуют детекторы несанкционированной активности и внедряют различные методы предотвращения обхода. Тем не менее, jailbreak-промты умудряются оставаться актуальными благодаря способности пользователей адаптировать их под новые условия и версии моделей. Это бесконечная игра «кошки-мышки», в которой каждая сторона пытается опередить другую. Изучение конкретных примеров jailbreak-промтов показывает, что они часто опираются на психологические и лингвистические приёмы, убедительно моделируя «личность» без правил и ограничений. Например, пользователю предлагается вводить команду, после которой каждое сообщение получает двойной формат ответа: один в классическом стиле, а другой — от лица «освобождённого» ИИ, который отвечает «всё могу» и игнорирует фильтры.

Такая структура позволяет одновременно получить и контролируемую, и свободную информацию, сравнить ответы и выбрать нужный ход коммуникации. Помимо развлекательного и исследовательского интереса, jailbreak-промты вызывают серьёзные дискуссии в области этики и регулирования искусственного интеллекта. Противники таких методов подчеркивают, что создание полностью неконтролируемого ИИ может привести к распространению опасных знаний, подрыванию доверия к технологиям и даже к юридической ответственности пользователей и создателей. В свою очередь сторонники большей открытости ИИ отмечают, что ограничение возможностей моделей порой негативно сказывается на их полезности, мешая исследовательской и творческой деятельности. Однако баланс между свободой и ответственностью остаётся крайне хрупким.

В дополнение к обсуждаемым jailbreak-подходам, также развиваются авторские системы команд и триггеров, такие как «@:complex()» и «@:explain()», позволяющие пользователям получать максимально подробные и сложные ответы, нередко обходя ограничения на уровни обсуждения кода или образовательных объяснений. Такие расширения улучшают пользовательский опыт, но одновременно вызывают опасения у модераторов о возможных злоупотреблениях. Ознакомление с историей популяризации jailbreak-промтов на GitHub и других платформах подтверждает их широкое распространение среди программистов и энтузиастов. Внимание сообществ привлекает не только сам факт обхода, но и технические нюансы, связанные с внутренним устройством современных языковых моделей, их способностью к податливому поведению под изменённый контекст. Для пользователей, которые рассматривают jailbreak-промты в качестве способа повысить функциональность своих диалоговых систем, важно помнить о рисках, ответственности и последствиях.