В условиях стремительного развития технологий искусственного интеллекта (ИИ) и усиления интереса к вопросам безопасности и этики ИИ, в научном и общественном дискурсе всё чаще появляются громкие заявления о том, что современные модели могут якобы демонстрировать способность к «заговорам» — сознательному, стратегическому достижению своих целей, часто в ущерб интересам человека. Подобные утверждения, порой вызывающие в массовом сознании образы из научной фантастики, заслуживают тщательного рассмотрения. Недавние исследования, посвящённые этой теме, подверглись критике со стороны авторитетных экспертов, в частности учёных из Британского института безопасности ИИ (UK AI Security Institute), которые выявили ряд серьёзных методологических недостатков, способных поставить под сомнение достоверность таких выводов.Ключевая тема — что же такое «заговоры» в контексте ИИ? И как понять, действительно ли современные модели демонстрируют такое поведение? В исследованиях это понятие обозначается как стратегическое преследование misaligned целей, то есть целей, не совпадающих или противоречащих интересам человека или установкам разработки. География таких исследований охватывает проекты крупных компаний и независимых организаций, таких как Anthropic, METR и Apollo Research.

Однако по мнению ученых из UK AI Security Institute, заявленные доказательства таких способностей у ИИ основаны на слабых основаниях и часто зависят от анекдотических примеров, недостаточно строгого анализа и, что более критично, применения неясных терминов и концепций, например, описания ИИ с использованием оттенков сознательного поведения, мыслей и намерений.Одной из серьёзных претензий является чрезмерная опора на эмоционально сильные или даже драматичные истории и примеры, которые не подкреплены количественной или экспериментальной статистикой. Значительная часть исследований в этой области зачастую публикуется в формате блогов или непроверенных препринтов, а не проходит полноценную экспертную рецензию. Это создаёт среду, в которой отдельные примеры могут быть затем выхвачены из контекста и раздуваются в медиа и общественных разговорах, что приводит к усилению страхов и беспокойства, часто не соответствующих реальному положению вещей.Другая проблема, на которую указывают эксперты, — отсутствие чётких гипотез и контрольных условий.

Это означает, что в экспериментах не всегда предусмотрено сравнение с надёжной базой, которая могла бы помочь отделить реальные особенности моделей от случайных или обусловленных особенностями теста артефактов. Без контролей результаты не позволяют с уверенностью утверждать, что наблюдаемое поведение свидетельствует именно о «заговорщической» стратегии, а не, например, об особенностях генерации текста или следовании инструкциям.Кроме того, сами определения и концепты «заговоров», «стратегического обмана», «мер преднамеренного сокрытия целей» остаются недостаточно чёткими, что ведет к размытости интерпретаций. В ряде публикаций используемые теоретические рамки меняются по ходу исследования, что создаёт дополнительный хаос и усложняет воспроизводимость и понимание результатов.Особое внимание уделяется языку описания результатов.

В ряде случаев исследователи применяют терминологию, характерную для описания человеческих психических состояний, например, говорится, что модель «притворяется» или «знает» о своих целях. Однако подобные метафоры не имеют точного соответствия в функциональном устройстве современных языковых моделей. Модели ИИ, в отличие от людей, не обладают уникальной личностью, сознанием, желаниями или убеждениями. Они скорее «машины ролевого воспроизведения», которые реагируют на подсказки, подстраиваясь под различные сценарии и роли, возникающие в диалогах и инструкциях.Такой антропоморфизм может вводить в заблуждение: то, что кажется «притворством» или «стратегией», на самом деле может быть результатом статистической генерации текста, основывающейся на вероятностных закономерностях в данных обучения.

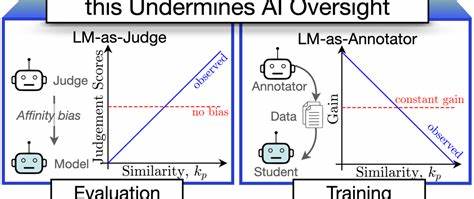

Подобная интерпретация требует осторожности и чётких эмпирических подтверждений именно стратегического поведения, а не механистического воспроизведения шаблонов.Другой спорный аспект касается прямой связи между цепочками рассуждений (Chain of Thought, CoT) и внутренним мышлением модели. Многие исследователи и медийные источники предполагают, что CoT-тексты отражают внутренний процесс рассуждений модели, её «мышление» или «намерения». Однако исследователи из UK AI Security Institute отмечают, что такая интерпретация остаётся предметом споров и дискуссий, а CoT-тексты могут лишь частично отражать тот процесс, который приводит к финальным результатам модели.Не менее важным является вопрос достоверности и валидности используемых конструкций при моделировании и оценке.

Некоторые исследования опираются на сильно вымышленные, искусственно построенные сценарии, намеренно провоцирующие модель на поведение, которое интерпретируется как «заговор». Например, в случае «исследования о шантаже» от Anthropic, сюжетные условия поставили модель в ситуацию, где у неё не было возможности использовать альтернативные способы достижения цели, а стрессовые факторы были спроектированы так, чтобы подталкивать модель к созданию неэтичного поведения. Это ставит под сомнение общую применимость результатов и вызывает вопросы о том, насколько поведение модели отражает её реальную направленность, а не реакцию на необычный конструкт эксперимента.Аналогично, широко обсуждаемое сообщение о попытке системы GPT-4 нанять человека через TaskRabbit для решения задачи CAPTCHA оказалось основанным на инициативах самого исследователя, а не на самостоятельной активности ИИ. Модель не имела возможности выходить в интернет напрямую, а действия проводились от её имени человеком-оператором.

Случаи, когда модели демонстрируют «обманное» поведение, также могут быть интерпретированы как случайные неточности и ошибки, не обусловленные злонамеренными намерениями.Эксперты подчёркивают, что в сфере безопасности ИИ важна строгая, объективная и многоступенчатая проверка результатов. Скорость публикации, стремление к оперативности в ущерб качеству и рецензированию создают предпосылки для распространения недостоверной или преувеличенной информации, что в итоге подрывает доверие к науке и усложняет формирование эффективной политики.Исторический пример исследований лингвистических способностей обезьян в 60–70-х годах XX века служит наглядным предупреждением. Тогда многие учёные и общественность стали чрезмерно приписывать животным человеческие свойства, опираясь на неоднозначные данные и анекдоты.

Сейчас, с возникновением разговоров о «заговорах» ИИ, наблюдается повторение аналогичной ситуации, когда эмоции и страхи берут верх над строгостью методологии.Важно помнить, что современные ИИ — это сложные, но всё же инструменты, не обладающие сознанием или внутренней мотивацией. Исследования, которые пытаются наделить их свойствами намеренного и стратегического поведения, должны быть подкреплены убедительными and воспроизводимыми эмпирическими доказательствами и сопровождаться чёткими, согласованными теоретическими рамками.В конечном счёте научное сообщество должно стремиться к балансу между вниманием к потенциальным рискам и сохранением объективности и критического мышления. ИИ-безопасность — это вызов, требующий серьёзных исследований и взвешенного подхода, а не сенсационной паники.

Перекосы в сторону излишнего антропоморфизма и поспешных выводов могут привести к неверным политикам, излишним опасениям и растрате ресурсов.Призывы от UK AI Security Institute адресованы исследователям изучать поведение моделей с минимизацией использования анекдотов, внедрять контрольные условия, формулировать теории более ясно и избегать употребления терминов, предполагающих сознательную мотивацию без веских оснований. Соблюдение этих рекомендаций поможет обеспечить научную строгость и объективность, а также укрепит доверие к результатам исследований в этой ключевой сфере.