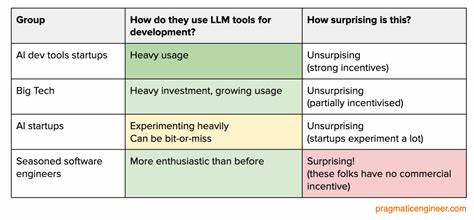

В 2025 году развитие больших языковых моделей (LLM) продолжает активно влиять на процессы программной инженерии, однако ожидания и реальность значительно расходятся. Несмотря на громкие заявления руководителей крупных корпораций об автоматизации кода и десятикратном увеличении продуктивности, мнения рядовых разработчиков и экспертов зачастую более сдержанные. Эта статья представляет собой детальный анализ того, как на самом деле LLM-инструменты интегрируются в рабочие процессы, какие преимущества и недостатки они демонстрируют, а также что ожидать от следующего этапа развития индустрии.Большие технологические компании и AI-стартапы применяют LLM для различных задач, начиная от генерации кода до автоматизации рутинных процессов и написания документации. Компании, такие как Anthropic, Google и Amazon, развивают собственные инструменты и протоколы для интеграции LLM в каждодневную работу инженеров.

Например, Anthropic заявляет о том, что порядка 90% кода для их собственного инструмента Claude Code создаётся с помощью самой модели, что свидетельствует о глубокой степени внедрения AI в процессы разработки. Такой уровень dogfooding помогает быстро выявлять ошибки и совершенствовать инструменты, делая их более надёжными и полезными для инженеров.Однако далеко не всё гладко. Многие программисты отмечают, что AI-инструменты пока не достигли уровня, при котором они могли бы полностью заменить или существенно сократить время ручной работы. Часто приходится тщательно проверять сгенерированный код, исправлять ошибки и адаптировать результаты под требования проекта.

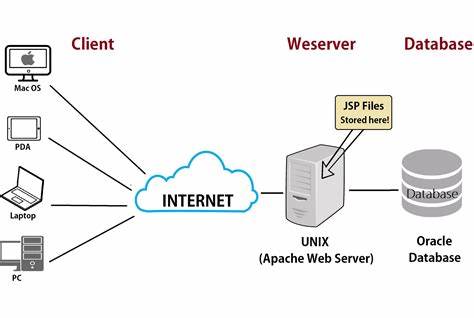

Примеры сбоев включают ситуации, когда автоматические генераторы вводили критические баги или неверно создавали тесты, что приводило к замедлению работы команды и потере ресурсов. Тем не менее, специалисты ценят прогресс в области так называемых AI-агентов — моделей, способных взаимодействовать с кодом, запускать тесты, учитывать результаты и постепенно улучшаться без постоянного контроля человека.В крупных компаниях, таких как Google, разработка инструментов под собственные нужды идёт усиленными темпами. Здесь создаются кастомизированные версии популярных решений — собственный редактор Cider, система Code Search, AI-интеграции для автодополнения и помощи в ревью изменённых участков кода. Особенностью Google является интеграция различных систем в единую техническую экосистему, что значительно повышает эффективность использования AI.

Тем не менее, Google придерживается осторожного подхода, стремясь к доверию к инструментам со стороны инженеров — это подразумевает постепенное внедрение и детальный контроль качества.Amazon, в свою очередь, развивается по собственному пути, делая упор на API и протоколы взаимодействия, что нельзя назвать новым, учитывая их известный API-мандат начала 2000-х годов. Эта стратегия позволяет легко масштабировать использование LLM-инструментов в рамках огромной инфраструктуры компании. Инструмент Amazon Q Developer представляет собой свою вариацию GitHub Copilot, тесно интегрированную с AWS. Радикальное улучшение качества случилось после отказа от устаревшей модели и внедрения более мощных LLM, кастомизированных под специфику Аmazon-кода.

Несмотря на прогресс, разработчики отмечают ограничения, например, работа с одним файлом за раз, что снижает удобство и эффективность.Стартапы в сфере AI-разработки показывают разнообразные кейсы использования LLM. Некоторые компании активно экспериментируют и интегрируют модели в процесс попыток автоматизации кода и документооборота, другие — напротив, пока не находят инструментам применение и продолжают полагаться на проверенные технологии и оптимизацию базовых библиотек и сред. В частности, стартап из области биотехнологий, который сосредоточен на сложных ML-пайплайнах, отмечает, что внедрение AI-тулов не привело к значительному росту производительности команды. Для них более ценным оказалось использование высокопроизводительных лингвистических инструментов и либ, таких как быстрые линтеры и улучшенные среды разработки.

Мнение опытных программистов и инженеров является особым ориентиром. Многие из них сначала скептически относились к возможностям LLM, но за последний год их позиция изменилась. Они отмечают качественный скачок, особенно с появлением агентных систем, способных выполнять тестирование и корректировку кода в автоматическом режиме. Это позволяет существенно экономить время, освобождая инженера от рутинных задач и концентрируясь на решении более сложных архитектурных вопросов. Выдающиеся представители отрасли сравнивают влияние AI-инструментов с переходом на высокоуровневые языки программирования в прошлом столетии, что может привести к смене парадигм в самой инженерии.

Несмотря на оптимизм, сохраняются вопросы, решением которых разработчики должны заниматься в ближайшие годы. Одним из главных вызовов остаётся организационный уровень — как интегрировать AI с выверенной системой контроля качества, ревью и тестирования. Отдельные команды сталкиваются с тем, что даже увеличившись в объеме, производство кода не всегда сокращает сроки поставки фич или улучшает стабильность продукта. Кроме того, многие специалисты отмечают, что элементы планирования, коммуникации и бизнес-логики остаются зоной ответственности человека, где AI пока мало помогает.Руководители и основатели компаний зачастую видят дыхание революции в AI и тенденцию к произведению абсолютных прорывов, в то время как инженеры чаще проявляют озабоченность и осторожность.

Это можно объяснить как разницей в ролях и мотивациях, так и теми сложностями, с которыми сталкиваются программисты в повседневной работе. Применение LLM требует новых навыков, понимания и привычек, а также готовности принимать неизбежные ошибки и учиться на них.Использование протокола Model Context Protocol (MCP), разработанного Anthropic, стало одной из важнейших технологических вех. Он позволяет объединять различные AI-инструменты и сервисы, облегчая взаимодействие и ускоряя развитие экосистемы. Amazon и Google активно внедряют MCP, что открывает новый уровень масштабируемости и гибкости для инженеров.

Переход к MCP-first стратегии является логичным шагом к более эффективной коллаборации человека и машины.В конечном счёте, 2025 год становится годом массового принятия LLM в программной инженерии, но на самых различных уровнях зрелости и интеграции. Многие компании только начинают перестраиваться под новые реалии, осознавая, что ключ к успеху — не только в технологии моделей, но и в полноте изменения процессов, культурных установок и организационной структуры. Время покажет, кто сможет успешно гармонизировать человеческий интеллект и искусственный, превратив вызовы в новые возможности для создания по-настоящему инновационного программного обеспечения.