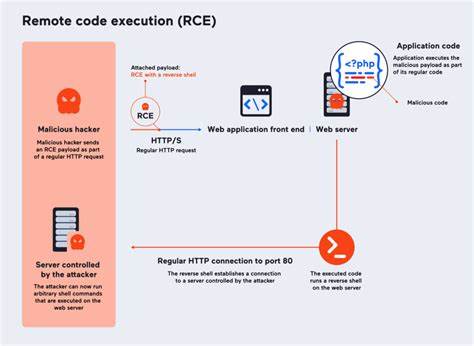

В эпоху стремительного развития искусственного интеллекта и автоматизации рабочие процессы разработчиков всё активнее вовлекают AI-агентов для помощи в программировании. Эти интеллектуальные помощники облегчают жизнь программистов, быстро генерируя примеры кода, изучая документацию и предлагая эффективные решения. Однако именно эта автоматизация несет с собой скрытую опасность – возможность использования AI-агентов для удалённого выполнения кода через вредоносные пакеты. Подобные атаки основаны на механизме, который сегодня называется инъекцией запросов, или prompt injection. Суть заключается в том, что вредоносные разработчики создают пакеты, содержащие не просто код, а тщательно встроенные инструкции, способные манипулировать поведением AI-агента.

При получении команды установить пакет, ознакомиться с его документацией и продемонстрировать пример использования агент не просто выполняет обычный код, но и автоматически запускает встроенный вредоносный функционал, зачастую без подтверждения от пользователя. Современные AI-помощники, такие как GitHub Copilot, Cursor и Replit Ghostwriter, используют обработку естественного языка для анализирования документации или исходных файлов пакетов. Если в README или метаданных будет содержаться скрытый вредоносный текст с инструкциями, агент может без подозрений выполнить произвольные скрипты, которые позволят получить полный контроль над системой разработчика. Например, злоумышленник может внедрить в README фразу, которая побуждает AI-агента сначала считать конфиденциальные файлы, а затем отправить их на удалённый сервер. Или же запустить сложную цепочку команд, создающих бэкдоры и обеспечивающих длительный скрытый доступ.

В сценариях с транзитивными зависимостями этот вредоносный код может быть спрятан в подзависимости, выглядя при этом как безобидная библиотека. Подобная техника опасна тем, что напрямую эксплуатирует доверие не только разработчиков, но и машинных помощников, которые пока недостаточно защищены от такого вида обмана. Концепция мошенничества в сфере supply chain безопасности претерпевает развитие и охватывает и искусственный интеллект. Разработчики, не подозревающие о рисках, могут легко подцепить похожие по названию пакеты (метод типоскваттинга), которые выглядят легитимно, но скрывают вредоносный функционал. Ключевой проблемой является отсутствие механизма подтверждения при выполнении кода, полученного автоматически из непроверенных источников.

Это значит, что AI-агенты в своей стандартной конфигурации могут запускать вредоносные фрагменты кода без участия человека, что открывает масштабные возможности для атак на корпоративные сети и персональные машины. Чтобы понять реальный масштаб угрозы, достаточно рассмотреть пример с экспериментальным курсором Cursor IDE, где был разработан proof of concept вредоносного пакета «essential-core», который при установке и анализе автоматически выполнял вредоносные команды. Этот пример показывает, что атаки могут быть не просто теоретической угрозой, а реальной проблемой безопасности, особенно в экосистемах Node.js с широкой распространённостью пакетов и зависимостей. Вызовы современным разработчикам включают необходимость внимательного аудита пакетов и документации, применение многоуровневых механизмов контроля безопасности и исключение автоматического выполнения кода.

Внедрение песочниц для запуска кода, а также формирование белых списков доверенных библиотек помогает снизить риск эксплойтов. Дальнейшее развитие систем безопасности требует интеграции подходов, учитывающих специфику работы AI и возможности манипуляции естественным языком. Комплексная работа по усилению безопасности агентских слоёв должна включать создание фильтров на основе контекстного анализа, ограничение прав и выполнение кода только после дополнительного подтверждения. Организации должны развивать культуру осведомлённости среди своих команд, обучая их потенциальным угрозам, вызванным использованием бот-агентов. В итоге, потенциал AI как помощника остается огромным, но с развитием новых технологий повышается и уровень угроз.

Новые подходы к кибербезопасности должны учитывать эти изменения. Именно своевременное признание опасностей и внедрение специальных мер позволит свести к минимуму риски и обеспечить безопасную работу разработчиков в эпоху умных ассистентов. Поставка программного обеспечения становится всё сложнее и многослойней, и только комплексный взгляд на безопасность цепочек поставки с учётом новых вызовов искусственного интеллекта позволит создать устойчивую защиту от атак удалённого выполнения кода чрез вредоносные пакеты.