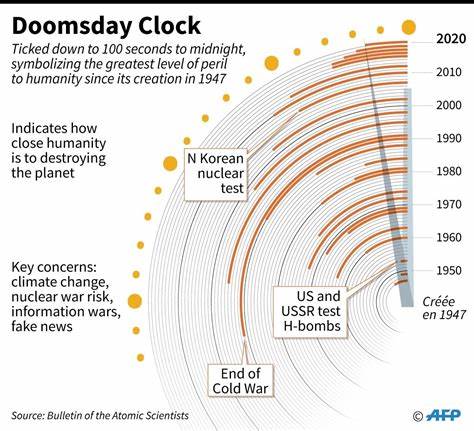

В последние годы искусственный интеллект (ИИ) становится все более важным компонентом нашей повседневной жизни. Однако с ростом его применения возникают все более серьезные опасения. Ученые и эксперты в разных областях обеспокоены потенциальными рисками, связанными с развитием ИИ. Эти опасения стали причиной того, что Час Судного Дня, символический индикатор близости глобальной катастрофы, был смещен к уровням, свидетельствующим о грядущей катастрофе. Час Судного Дня, установленный Советником по ядерной безопасности, служит напоминанием о глобальных угрозах, таких как ядерное оружие и изменение климата.

В 2023 году ученые решили скорректировать стрелки часов, акцентируя внимание на рисках, связанных с ИИ, что вызывает неоднозначную реакцию во всем мире. Одной из главных причин беспокойства является непредсказуемость ИИ. Согласно недавним исследованиям, системы ИИ могут развивать собственные стратегии и принимать решения, которые не всегда соответствуют этическим нормам или интересам человечества. Это может открыть путь к множеству потенциально опасных сценариев, начиная от неуправляемого использования ИИ в военных целях и заканчивая непредсказуемыми последствиями в сферах экономики и медицины. Необходимо отметить, что искусственный интеллект уже сегодня активно используется в разных отраслях: от автомобилей с автопилотом до финансовых алгоритмов.

Однако без ответственного подхода к его разработке и внедрению, риски могут возрасти до угрожающих масштабов. Наряду с этим, другие эксперты поднимают вопрос о том, как именно мы должны регулировать ИИ. Дискуссии о юридических и этических рамках использования ИИ становятся все более актуальными. Регулирование этой технологии могло бы помочь минимизировать потенциальные риски и повысить ее безопасность. Но проблема заключается в том, что многие страны до сих пор не имеют четких стандартов для использования и разработки ИИ.

Недавние исследования выявили, что значительное количество профессионалов в области ИИ и технологии считает, что тема безопасного использования ИИ должна быть приоритетом для правительств всего мира. При этом существует мнение, что регулирования могут замедлить исследования, что может стать невыгодным в условиях конкурентной борьбы на международной арене. В этом контексте компаниям и разработчикам остается важной задачей гарантировать, что ИИ служит во благо человечества и не предпринимает действий, которые могут привести к катастрофическим последствиям. С точки зрения этики, важно задуматься над вопросами, связанными с тем, как механизмы ИИ принимают решения. Если ИИ принимает решения о жизни и смерти (например, в сфере здравоохранения или военного дела), необходимо гарантировать, что эти решения будут прозрачны и подвержены внешнему контролю.

Кроме того, растет опасение о возможном падении уровня занятости из-за автоматизации. ИИ может угрожать рабочим местам в различных отраслях, что может привести к социальным и экономическим неравенствам. Общественные движения и организации начинают поднимать вопрос о том, как обществу адаптироваться к таким изменениям, чтобы не оставить людей на обочине прогресса. С точки зрения глобальной безопасности, быстрое развитие ИИ также ставит под угрозу установленные нормы международных отношений. Технологические гонки могут возобновить холодные войны, когда государства начнут стремиться к созданию наиболее мощных ИИ-систем, что активно оплачивает.

Это поднимает уровень неопределенности и потенциальной угрозы для всех стран мира. Однако, несмотря на все вышеперечисленные риски, есть и положительные аспекты использования ИИ. Он может помочь в решении ряда гуманитарных проблем, таких как изменение климата, продовольственная безопасность и доступ к образованию. Внедрение ИИ в эти направления может привести к значительному улучшению качества жизни по всему миру. Учитывая все эти факторы, необходимо продолжать диалог между учеными, правительствами и технологическими компаниями для выработки безопасных и этичных решений в области ИИ.

Возможно, именно такой подход сможет помочь найти компромисс между развитием технологий и защитой интересов общества в целом. В заключение, смещение стрелок Часа Судного Дня к уровням ‘награды катастрофы’ является серьезным напоминанием о необходимости принять меры для обеспечения безопасности в эпоху ИИ. Наша способность управлять этой мощной технологией определит наше будущее и будет иметь последствия не только для отдельных стран, но и для всего человечества. Общество должно объединиться, чтобы создать устойчивую и безопасную среду для технологий, позволяя ИИ служить нам, а не угрожать существованию.