В последние годы обучение с подкреплением (reinforcement learning, RL) стало одним из самых быстроразвивающихся направлений в области искусственного интеллекта. Эта методология позволяет агентам обучаться оптимальным стратегиям поведения в сложных и динамичных средах на основании проб и ошибок. Однако одна из главных проблем современных систем на основе RL — это отсутствие понимания их внутренней логики и принципов принятия решений. Столкнувшись с «черным ящиком», пользователи и разработчики не всегда располагают объяснимыми и доступными причинами, почему агент ведёт себя именно так. Решением этой задачи стало направление объяснимого обучения с подкреплением (explainable reinforcement learning, XRL), цель которого — создать методы и инструменты, способные раскрыть логику обученных агентов, повысить доверие к ним и способствовать более безопасному и этичному применению ИИ в различных областях.

В настоящее время XRL является не только актуальным исследовательским полем, но и быстро растущей экосистемой научных разработок и практических решений. Современные ресурсы по XRL объединяют обширные библиотеки исследовательских публикаций, обзоров, примеров кода и платформ, на которых ученые и практики могут обмениваться знаниями и опытом. Среди ведущих направлений в XRL особое внимание уделяется методам интерпретации и визуализации решений агентов, которые варьируются от простых программных политик до сложных нейросетевых моделей с объяснениями на основе причинно-следственных связей, прототипов и контрфактических сценариев. Ключевую роль играют также бенчмарки XRL, которые позволяют систематически оценивать эффективность и качество объяснений различных подходов и алгоритмов. Одним из интересных трендов является объединение нейросимволических методов с XRL, что открывает возможности для создания моделей, которые не только обучаются эффективным стратегиям, но и способны формулировать объяснения в виде человечески понятных текстов или логических правил.

Такая интеграция способствует преодолению разрыва между техническими аспектами обучения и потребностями конечных пользователей в понятных интерпретациях. Научное сообщество регулярно публикует обширные обзоры и сравнительные исследования, в которых классифицируются и оцениваются текущие методы XRL. Эти обзоры дают системное представление о развитии области, выявляют недостатки существующих решений и обозначают направления, требующие дальнейших исследований и усовершенствований. Кроме сугубо академических интересов, объяснимое обучение с подкреплением находит применение в различных прикладных сферах. Например, в робототехнике XRL способствует созданию автономных систем, которые могут не только выполнять сложные задачи, но и объяснять свои действия оператору, что критично для безопасности и сотрудничества.

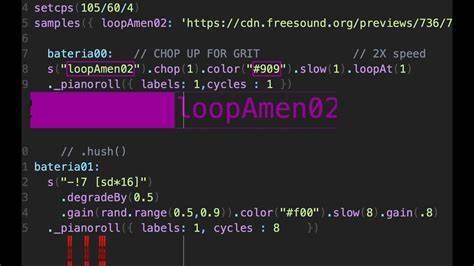

В интеллектуальных транспортных системах интерпретируемые модели помогают повысить прозрачность решений, связанных с управлением движением и обеспечением безопасности на дорогах. Также XRL актуально для производственных процессов, энергетического менеджмента и медицинских приложений, где объяснимость моделей напрямую связана с ответственностью и требованиями регуляторов. Современные разработки в XRL включают в себя различные техники: от визуализации важных состояний и атрибутов среды до контрфактических объяснений, которые демонстрируют, как изменились бы действия агента при иных обстоятельствах. Повышенное внимание уделяется интерактивным подходам, позволяющим пользователю задавать вопросы агенту и получать адаптированные ответы в реальном времени, что усиливает психологический комфорт и уровень доверия к системам ИИ. Текущая динамика развития XRL также связана с растущей доступностью открытых репозиториев и ресурсов, которые содержат каталоги целевых публикаций, образовательные материалы, инструменты для построения объяснений и платформы для проведения экспериментов.

Такая инфраструктура стимулирует сотрудничество между исследователями, разработчиками и пользователями, ускоряя интеграцию XRL в коммерческие и научные проекты. Значение объяснимого обучения с подкреплением невозможно переоценить в свете этических вызовов, связанных с применением ИИ. Доверие, прозрачность и возможность проверки алгоритмов — это фундаментальные предпосылки для широкого распространения интеллектуальных систем в обществе. Способность объяснять свои решения помогает ИИ-системам не только соответствовать нормативным требованиям, но и улучшать взаимодействие с людьми, учитывая их ожидания и ценности. Перспективы развития объяснимого обучения с подкреплением включают расширение масштабов и универсальности объяснительных моделей, интеграцию с другими направлениями ИИ, такими как обучение с ограниченным обучающим набором данных, множественные агенты и стратегии с долгосрочной нацеленности.