В последние годы большие языковые модели (LLM) стали ключевым элементом в развитии искусственного интеллекта и обработки естественного языка. Эти модели значительно улучшили качество текстовой генерации, понимание контекста и способность решать сложные задачи. Однако среди исследователей и пользователей существует распространенное мнение, что масштабирование LLM приносит уменьшающуюся отдачу - то есть с каждым увеличением размера модели улучшения становятся все менее заметными и значимыми. Но так ли это на самом деле? В данной статье мы рассматриваем концепцию иллюзии снижающейся отдачи на примере измерения эффективности выполнения долгосрочных задач большими языковыми моделями. Рассмотрим, почему узкие метрики краткосрочных результатов не отражают истинный прогресс и как понимание динамики исполнения может изменить взгляд на масштабирование и применение LLM.

Одним из ключевых фактов, открытых в последних исследованиях, является то, что даже минимальное повышение точности на единичном шаге исполнения может трансформироваться в экспоненциальное улучшение способности модели выполнять более сложные и длительные задачи. То есть выигрыш не просто растет линейно, он масштабируется многократно, когда умение модели корректно выполнять множество последовательных действий становится критическим фактором. В чем же заключается суть проблемы? Большое количество существующих бенчмарков оценивает LLM на коротких задачах, которые включают ограниченное число вычислительных или аналитических шагов. На их основе легко усмотреть эффект уменьшения прироста - ведь когда и так почти все шаги выполняются успешно, повышать точность на небольшой процент становится менее заметно. Но если посмотреть глубже и оценить, насколько далеко модель способна продвинуться при выполнении задач с большим числом последовательных действий, ситуация меняется.

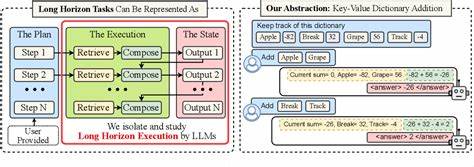

Большие модели показывают значительные качественные скачки, позволяющие им справляться с более длинными цепочками действий, даже если при этом повышение точности на отдельном шаге кажется скромным. Важным наблюдением является то, что ошибки моделей при выполнении развёрнутых процессов чаще вызваны не ограничениями в способности к рассуждениям, а именно ошибками исполнения. Проще говоря, модель может знать и понимать необходимую логику и план действий, но на практике не всегда успешно воспроизводит эти шаги при длинном контекстном исполнении. Чтобы изолировать этот аспект, исследователи предлагают отдельным образом учитывать исполнительную способность модели, предоставляя ей заранее всю необходимую информацию и план решения задачи. Это помогает понять, как меняется точность выполнения по мере увеличения количества шагов.

Исследования показывают, что большие модели способны корректно исполнить значительно большее число последовательных взаимодействий, даже если маленькие модели достигают почти стопроцентной точности на индивидуальных шагах. Однако даже большие модели испытывают постепенное снижение точности при увеличении длины цепочки исполнения. Причина этого явления связана не только с ограничениями контекстного окна, но и с эффектом самоусиливающейся ошибки - так называемым самообусловливанием. Это явление возникает, когда модель в ходе работы учитывает свои прежние ошибки в контексте и из-за этого с большей вероятностью совершает новые ошибки. Интересно, что простое увеличение размера модели не устраняет данную проблему.

Однако есть способы снизить ее влияние. Один из наиболее перспективных подходов - использование механизма "мышления" или этапа внутреннего обдумывания модели внутри одного шага. Благодаря этой технике модель улучшает качество принятия решений и последовательного исполнения операций, что позволяет ей справляться с задачами гораздо большей протяженности без накопления ошибок. Следовательно, способность к глубокому "мышлению" и внутренней проверке хода решения играет ключевую роль в преодолении ограничений, налагаемых ошибками исполнения при длинных последовательностях действий. По мере роста масштабов модели и внедрения эффективных механизмов "мышления", LLM демонстрируют выдающиеся успехи в решении комплексных задач, которые традиционно считались сложными или невозможными для автоматизации.

Делая акцент именно на исполнительные возможности и последовательность шагов, новые исследования помогают объяснить, почему большие языковые модели способны решать сложные логические и рассудочные задачи, но иногда ошибаются при простых задачах с большим числом повторяющихся этапов. В результате меняется взгляд на значение прошлых наблюдений о "законе убывающей отдачи" при масштабировании моделей. На самом деле, при правильной постановке задачи и корректном измерении исполнения, расширение и усложнение моделей откроет качественно новые горизонты возможностей для автоматической логики и интеллектуального анализа. В дополнение к чисто теоретическим выводам, эти открытия имеют большое значение для практического применения LLM в промышленности и науке. Задания, которые требуют выполнения многошаговых планов, например автоматизация сложных процессов, поддержка научных исследований, программирование на естественном языке, станут более доступными и надежными.

Компании смогут уверенно вкладывать ресурсы в обучение и использование более крупных моделей, понимая, что выгоды от этого не ограничиваются небольшой прибавкой в единичных метриках. Наконец, важно учитывать, что развитие моделей с долгосрочным исполнением открывает путь к созданию действительно автономных систем, которые могут последовательно планировать и выполнять сложные проекты от начала и до конца с минимальным контролем со стороны человека. В совокупности новые данные демонстрируют, что впечатления суженного эффекта от масштабирования LLM - это скорее иллюзия, вызванная ограничениями традиционных тестов и пропорциональным вниманием к кратковременным метрикам. В действительности же потенциал моделей растет экспоненциально, особенно если сделать акцент на стратегии улучшения их исполнения и принятия решений на длинных горизонтах. Перспективные направления дальнейших исследований включают разработку новых подходов к обучению, способствующих снижению эффекта самообусловливания, совершенствование архитектур для поддержки более длительной памяти и расширение техник "мышления" для укрепления надежности и качества исполнения.

С развитием этих методик большие языковые модели смогут еще глубже проникать в сферы, требующие комплексного мышления, глубокой логики и внимания к деталям, тем самым значительно расширяя горизонты искусственного интеллекта и его способности трансформировать мир вокруг нас. .