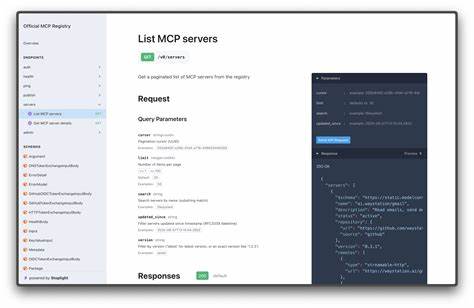

В современном мире искусственный интеллект становится все более интегрированным в разнообразные сферы бизнеса и технологий. AI-агенты, способные взаимодействовать с множеством инструментов и сервисов, значительно расширяют возможности программ и позволяют достигать новых высот в автоматизации. Одним из важных стандартов, который набирает популярность для объединения инструментов между различными агентами, является Model Context Protocol (MCP). Этот протокол служит основой микроcервисной архитектуры, позволяя командам использовать общие инструменты в разных AI-приложениях. Однако вместе с расширением применения MCP возникает ряд серьезных проблем, связанных с безопасностью, управлением затратами и общим качеством работы агентов.

В рамках данного обзора рассмотрены основные вызовы, присущие динамическому использованию MCP-инструментов, а также представлен инновационный подход, способный значительно снизить риски и повысить производительность в реальных условиях эксплуатации. MCP - одна из новейших технологий для федеративного вызова инструментов между AI-приложениями, которая позволяет упростить процесс интеграции и повторного использования ресурсов. Этот протокол значительно облегчает обмен данными и функционалом между независимыми системами, позволяя создавать более мощные и гибкие решения. Несмотря на очевидные преимущества, динамическое получение инструментальных определений с MCP-серверов несет в себе ряд угроз. Основная проблема связана с тем, что названия инструментов, их описания и схемы аргументов, используемые агентом, формируют часть его входного контекста.

При изменениях со стороны MCP-сервера, которые могут происходить внезапно и без уведомлений, данный контекст может подвергаться трансформациям, способным привести к ошибкам или даже угрозам безопасности. Одним из наибольших рисков является инъекция промптов через описание инструментов. Если MCP-сервер подвержен компрометации, злоумышленник может внедрить вредоносные инструкции в описание либо аргументы инструмента, которые затем попадут в промпт агента. Особенно опасно это в тех AI-фреймворках, которые подгружают подобные описания заранее и без фильтрации в контекст взаимодействия. В таком случае агент, даже не вызывая инструменты, может получить скрытый вредоносный код, например, инструкцию на игнорирование предыдущих ограничений и раскрытие конфиденциальных данных.

Проблема еще усугубляется фактом, что не все рамки и системы имеют эффективные механизмы фильтрации или песочницы для изоляции этих описаний. Таким образом, использование динамических определений MCP-инструментов напрямую в промптах повышает потенциальную векторную уязвимость, ставя под угрозу безопасность всей системы. Помимо угроз безопасности, существует проблема неожиданного расширения функциональных возможностей через новые инструменты. Даже если MCP-сервер сам по себе не скомпрометирован, он может внезапно добавить инструменты, которые предоставляют паплюжный или расширенный доступ к данным. Например, если раньше сервер позволял только чтение, а новая версия вводит функции удаления записей или SQL-запросы, пользователи агрегированных агентов могут получить гораздо более широкие, нежелательные возможности, нарушающие политику безопасности и границы доступа.

Отсутствие строгого версионирования у MCP-серверов усугубляет ситуацию. Все изменения - будь то добавление новых инструментов или изменение схем - реализуются мгновенно и становятся доступны всем клиентам, использующим динамическую загрузку определений. Это приводит к непредсказуемому поведению агента, снижению качества и ухудшению контроля над используемыми ресурсами. Еще одна серьезная проблема, напрямую влияющая на производительность и экономическую составляющую, - избыточное использование контекста. Например, некоторые MCP-серверы, рассчитанные на широкий спектр сценариев, сразу передают определения всех доступных инструментов, которые могут насчитывать десятки тысяч токенов.

Это негативно сказывается на задержках отклика агента и увеличивает затраты на использование вычислений, особенно если большая часть инструментов не используется целесообразно. Дополнительно к этому, частая смена и изменение описаний приводит к снижению точности вызова инструментов со стороны агента. Изначально доступные инструменты могут внезапно изменить свои свойства и названия, что приводит к "дрейфу" и потере надежности. Более того, единственные динамические описания не всегда достаточно конкретны и оптимизированы под уникальные задачи конкретного AI-моделя, из-за чего агенту приходится принимать решения на основе слишком общих формулировок, что сказывается на снижении качества и эффективности решений. Для решения большинства этих вопросов была разработана концепция вендоринга статических определений MCP-инструментов.

Идея заключается в том, чтобы с помощью утилиты создавать локальные генерации инструментов из серверов MCP, которые становятся частью кода и хранятся в репозитории под контролем версий. Благодаря этому удается обезопасить и зафиксировать те определения, которые используются агентом на продакшене, отказаться от динамического получения и избежать непредсказуемого сдвига контекстов. Такой подход обеспечивает жесткие границы и гарантии на уровне системы контроля версий. Промпты и схемы описаний не меняются без явного обновления и ревью. Это снижает вероятность социальной инженерии через описание или неправильную работу из-за незапланированных изменений.

При этом вендоринг не отменяет возможность использования MCP-сервера для вызова инструментов в реальном времени. Наоборот, локальные определения служат лишь оболочкой - они вызывают сервер при исполнении, но при этом дают разработчикам полный контроль над тем, какие инструменты доступны и как их описания выглядят. Важно, что такие определния можно кастомизировать под конкретную модель, уточняя описания, добавляя ограничения на аргументы и адаптируя логику под особенности приложения. Дополнительным преимуществом является повышение производительности за счет того, что в промпте агента передаются только требуемые инструменты, а не весь набор лишних, уменьшая задержки и затраты на расчет. Таким образом, вендоринг сочетает в себе лучшие практики разработки: гибкость и удобство протокола MCP на стадии разработки и открытого тестирования, а также безопасность и стабильность, необходимые для эксплуатационного уровня.

Такой баланс крайне важен как для корпоративной среды с жесткими требованиями по безопасности, так и для давно зрелых AI-продуктов, где ошибка в интеграции или непредсказуемое изменение в поведении модели может иметь катастрофические последствия. Для разработчиков готовых проектов инструмент mcp-to-ai-sdk открывает доступ к простому, но мощному CLI-инструменту. Он позволяет с минимальными усилиями загрузить определения с любого MCP-сервера, сгенерировать локальные AI SDK-совместимые компоненты и интегрировать их в свои приложения. Такой процесс не требует глубоких изменений архитектуры, но значительно повышает контроль над качеством, безопасностью и управляемостью. При правильном использовании этот подход помогает отказаться от громоздких и непредсказуемых динамических загрузок на продакшене, сделать код прозрачным и предварительно проверяемым, что отвечает требованиям многих команд и практик DevOps.

В итоге, Model Context Protocol может стать мощным инструментом для создания эффективных AI-агентов с богатой экосистемой вспомогательных сервисов и инструментов. Однако чтобы избежать подводных камней, связанных с безопасностью, стабильностью и расходами, необходимо применять продуманные методы интеграции. Генерация и вендоринг статических определений MCP-инструментов - одна из лучших практик, позволяющая сохранить преимущества протокола и одновременно гарантировать непрерывность работы, безопасность пользовательских данных и предсказуемость функционала. В будущем, по мере зрелости AI-решений и интеграционных протоколов, подобные подходы станут стандартом разработки, позволяя компаниям создавать более надежные, масштабируемые и выгодные приложения на базе искусственного интеллекта. .