В наши дни большие языковые модели (LLM) являются одной из самых прогрессивных технологий в области искусственного интеллекта и машинного перевода. Такие системы, как GPT-4 и её аналоги, способны генерировать тексты, отвечать на вопросы и, конечно же, переводить между различными языками. Однако недавние исследования, основанные на глубоких тестах, показывают очень любопытный парадокс: чем больше LLM "думают" перед тем, как перевести текст, тем хуже оказывается конечный результат перевода. Традиционно считается, что размышление, анализ контекста и критический пересмотр помогают улучшить качество перевода. Многие современные методики переводов именно так и работают: сначала модель должна разобраться в значении оригинального текста, интерпретировать сложные конструкции и затем генерировать качественный перевод.

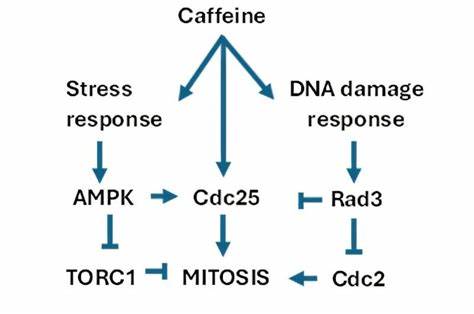

Однако практика показывает обратное — если модель попытается внимательнее «обдумать» свою работу до генерации перевода, результаты ухудшаются по сравнению с непосредственным, быстрым переводом без дополнительной «мысленной обработки». Эксперименты, проведённые с целью проверки этой гипотезы, включали несколько режимов работы LLM, таких как предварительное обдумывание («pre-think»), когда модель анализирует текст перед переводом, и последующее критическое рассмотрение перевода («post-think»), когда сначала создаётся базовый перевод, а потом модель оценивает и корректирует его. Были также смешанные подходы, которые совмещают оба способа. Результаты получили неожиданный характер — базовый перевод, сделанный без дополнительного времени на размышления, оказался наиболее точным и качественным. Все остальные способы «мысленных операций» снижали качество.

Причиной тому выступает излишняя сложность обработки и интерпретации текста, которую искусственный интеллект может предпринимать во время размышлений. Это приводит к переработке простых и очевидных фраз, появлению неточностей и искажений смысла, а иногда и чрезмерной генерализации, которая делает перевод менее естественным и точным. Другими словами, модель начинает «перебарщивать», пытаясь сделать перевод более умным, чем он должен быть, но в итоге теряет точность оригинала. Особенно наглядным оказался эффект, выявленный при использовании разнообразия моделей для альтернативных переводов и их последующего объединения. Гипотеза о том, что критика результата другой моделью способна компенсировать ошибки первой модели, не подтвердилась полностью.

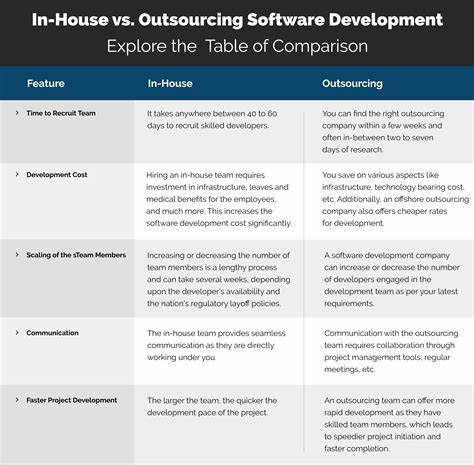

Если критикующая модель была более мощной и качественной, то её участие действительно внесло улучшения. Однако когда модель для критики была слабее или незначительно отличалась по уровню, качество комбинированного перевода ухудшалось. Таким образом, разнообразие и попытки синтезировать подходы нескольких различных моделей не всегда дают положительный эффект и не гарантируют улучшения перевода. Это разрушает популярное предположение, что множественность точек зрения искусственного интеллекта обязательно приводит к большей точности и надёжности результатов. Важно не только количество моделей, но и качество их взаимодействия и уровень их компетенции.

Особенно интересен способ работы гибридного переводчика, который делает выбор из лучших переводов нескольких моделей, а затем использует одну из мощных моделей, например GPT-4.1, чтобы синтезировать итоговый перевод. Такой подход, несмотря на комплексность, действительно показывает превосходство над отдельной моделью, подтверждая, что правильное объединение и качественная критика играют решающую роль. В экспертных кругах также отмечают влияние слабейших моделей в ансамбле, которые могут снижать общий результат. Современные тесты свидетельствуют, что исключение моделей с низкой производительностью из ансамбля приводит к небольшому, однако статистически незначимому росту качества.

Это говорит о том, что не каждый дополнительный источник информации полезен в автоматической обработке переводов. Большое внимание уделяется качеству модели-синтезатора. От неё во многом зависит, насколько точно и связно будет объединён перевод от разных систем. Подобно дирижёру в оркестре, она управляет всеми частями и формирует итоговый результат, который может либо усилить сильные стороны всех участников, либо усугубить ошибки. Нельзя не отметить и практическое применение таких исследований.

Создатели браузерных расширений и приложений для изучения языков уже используют эти данные, чтобы создавать более эффективные инструменты. Их цель — помочь пользователям быстро и наглядно получать качественные переводы во время серфинга в интернете без необходимости перелистывать словари или посещать отдельные переводческие сайты. Суть открытий в том, что простые и прямые переводы, сделанные без ненужного обдумывания, зачастую более точны и соответствуют исходному смыслу. Кроме того, данные подтверждают, что критический разбор после перевода, хотя и кажется логичной стратегией, может лишь вносить дополнительные погрешности, особенно если критический разбор поручить менее качественной модели. А значит, оптимальной является стратегия доверия модели, способной сразу эффективно работать с исходными данными, без лишних промежуточных этапов.

Эти выводы важны не только для разработчиков ИИ и систем машинного перевода, но и для широкой аудитории пользователей, интересующихся искусственным интеллектом и его возможностями. Понимание ограничения моделей и правильные подходы к их использованию позволяют создавать более надежные, быстрые и качественные языковые сервисы, которые станут незаменимыми помощниками в глобальной коммуникации. Таким образом, исследование подтверждает, что в современном мире ИИ "меньше иногда значит больше". Простота и прямота — это те качества, которые делают переводы лучше, а избыточное размышление и многослойная критика моделей могут только навредить. Инженерам и исследователям стоит учитывать эти закономерности при создании новых поколений языковых технологий, ориентируясь на изящество и практичность, а не на сложность и громоздкие многоступенчатые алгоритмы.

В конечном счёте, будущее переводов с искусственным интеллектом — это не гонка за всё более сложными размышлениями, а поиск баланса между эффективностью, качеством и временем отклика. Новые исследования и технологии будут направлены на улучшение этих параметров, чтобы сделать языковое общение максимально доступным, естественным и быстрым для всех пользователей вне зависимости от их языковой среды.