В современной эпохе искусственного интеллекта и машинного обучения растет интерес к модели Mixture-of-Experts (MoE), которая позволяет радикально увеличивать размер нейросетей без пропорционального роста вычислительных затрат. MoE предлагает архитектуру с большим количеством экспертов - отдельных компонентов модели, которые обрабатывают данные выборочно, что обеспечивает экономию ресурсов и улучшенную масштабируемость. Однако при попытке реализации таких моделей в промышленных масштабах возникают серьезные сложности, связанные с эффективностью работы на реальном оборудовании, такими как GPU и специализированные процессоры вроде Cerebras Wafer Scale Engine (WSE). В данной статье рассматриваются ключевые вызовы и современные решения для эффективного масштабирования MoE, делая упор на практическую оптимизацию на уровне аппаратуры и программного обеспечения. Mixture-of-Experts модели изначально строятся на принципе условного вычисления, когда на входной токен активируется только небольшой набор экспертов, вместо обработки полного набора параметров модели.

При этом суммарное число параметров модели растет во много раз, позволяя добиться лучших результатов при обучении и генерации. Тем не менее, с ростом числа экспертов появляются проблемы с загрузкой памяти и коммуникацией между устройствами в параллельных вычислениях - последние могут стать узким горлышком, существенно замедляя работу. Одной из первопричин этих проблем является необходимость хранить параметры всех экспертов в памяти, поскольку заранее невозможно предсказать, какой эксперт понадобится для конкретного токена. В типичном последовательном коде обработка делается через цикл по всем экспертам, что приводит к ненужным накладным расходам. Модели с небольшим числом экспертов (например, четыре) и относительно меньшим числом параметров могут работать на одной GPU или даже на ноутбуке, но при масштабировании до сотен экспертов и миллиардов параметров такая реализация перестает быть приемлемой.

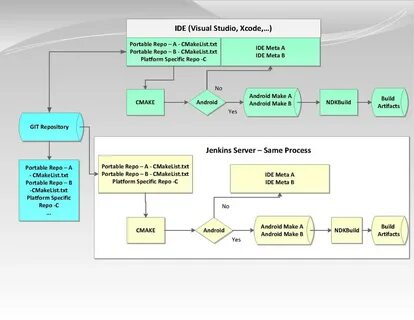

Наиболее распространенное решение проблемы нехватки памяти - эксперт-параллелизм (expert parallelism, EP), когда эксперты распределяются по нескольким GPU. Однако этот метод порождает новые сложности: поскольку маршрутизация токенов к экспертам случайна и распределение запросов по экспертам неравномерно, иногда одни GPU оказываются перегружены, а другие простаивают, что снижает общую эффективность и приводит к простою оборудования. Для обеспечения баланса нагрузок часто требуется жертвовать качеством модели, заставляя обучаться экспертам на подоптимальных данных. Кроме того, необходимость частого обмена данными между устройствами создает значительные коммуникационные задержки, порой составляющие большую часть времени обработки. Применение только эксперт-параллелизма не решает проблемы целиком.

На практике для производства масштабных моделей, таких как DeepSeek-V3 или Qwen3 с сотнями экспертов и миллиардами параметров, приходится комбинировать различные параллельные стратегии - pipeline-параллелизм, data-параллелизм и EP. Такая комбинация требует сложной настройки и постоянного перенастроивания с изменениями модели или инфраструктуры. Интересное техническое решение предлагает архитектура Wafer Scale Engine от компании Cerebras. Ее уникальность заключается в наличии огромного объема встроенной сверхбыстрой SRAM-памяти, превышающей по размеру память современного GPU в сотни раз. Благодаря этому модель, включающая около миллиарда параметров, может быть размещена целиком на одном чипе, что практически исключает необходимость использовать модельный параллелизм и промежуточные коммуникации между устройствами.

Для еще более масштабных моделей, состоящих из триллионов параметров, на Cerebras применяется технология weight streaming, которая разделяет хранение веса и вычисления, выгружая параметры модели в внешнюю память и передавая их на чип в потоке. Это решение позволяет переносить тяжелые тензоры в память вне чипа, освобождая ресурсы процессора для вычислений, и эффективно обновлять веса на лету. Таким образом, сложная задача обучения триллионных MoE-моделей сводится к управлению потоками данных и градиентов между чипом и внешней памятью. Однако решение проблемы с памятью в Cerebras не снимает полностью вопрос производительной загрузки вычислительных блоков. По мере увеличения числа экспертов и уменьшения количества активируемых экспертов (т.

н. sparsity или разреженность) каждая из них получает все меньше данных для обработки, что приводит к сильной простое ресурсов ввода-вывода и снижению общего использования процессорных вычислений. В параллельном между собой внимании (attention layers) объем памяти, занимаемый промежуточными активациями, растет квадратично с длиной последовательности, ограничивая их масштабируемость и не позволяя просто увеличить размер батча для повышения загрузки экспертных вычислений. Для устранения этого дисбаланса была предложена технология Batch Tiling on Attention (BTA). Ее идея состоит в разделении входного потока батчей на группы (tiles), которые независимо обрабатываются в слоях внимания небольшими порциями, а затем результаты объединяются для формирования увеличенного батча, подаваемого на экспертные слои.

Такой подход позволяет уменьшить объем памяти для активаций на слоях внимания, одновременно увеличив эффективный размер батча для экспертов, оптимизируя их вычислительную загрузку. Экспериментальные проверки на модели Qwen3 с 3 миллиардами активных параметров и 128 экспертами с top_k=8 подтвердили эффективность BTA. Без нее производительность существенно снижается с ростом числа экспертов и увеличением sparsity, достигая замедления скорости в два и более раза по сравнению с плотной моделью. BTA сохраняет производительность на уровне плотных моделей, независимо от числа активируемых экспертов и уровня разреженности. Математическое моделирование производительности подтверждает эмпирические наблюдения.

В вычислениях с использованием восьми GPU Nvidia H100 EP страдает от чрезмерной коммуникационной нагрузки, занимая до 77% всего времени на слой MoE, что свидетельствует о серьезном коммуникационном узком месте. В то же время Cerebras WSE, хоть и освобождает от необходимости разделять модель, сталкивается с проблемой низкой арифметической интенсивности при высоком уровне разреженности, приводящей к простою вычислительных блоков из-за малых объёмов данных на эксперта. С ростом sparsity арифметическая интенсивность сокращается почти на 98%, если не применять методы оптимизации, что подтверждает теоретическую и практическую необходимость Batch Tiling on Attention в работе с большими, разреженными MoE-моделями на данном аппаратном обеспечении. Интересно отметить, что BTA и EPS концептуально не исключают друг друга и могут быть использованы совместно на оборудовании Cerebras, позволяя масштабировать MoE до нескольких устройств, максимально используя вычислительные ресурсы каждого из них. Итогом является понимание того, что для масштабирования MoE с сотнями экспертов и триллионными параметрами, необходимо тщательно балансировать между требованиями к памяти, вычислительным ресурсам и коммуникации.

В то время как GPU кластеры вынуждены бороться с накладными расходами на движение данных между устройствами и балансировкой нагрузки, архитектура Cerebras с ее обширной локальной памятью и инновационной системой управления потоками значительно упрощает этот процесс. Тем не менее, одной лишь невозможности разместить модель в памяти или грамотно распределить экспертов недостаточно. Ключевым аспектом становится именно поддержание высокой эффективности вычислений на каждом этапе, для чего требуются продуманные архитектурные решения, такие как Batch Tiling on Attention. Эти методы позволяют добиться на практике тот уровень ускорения и снижения затрат, который теоретически обещают MoE. По мере развития технологий и роста доступных вычислительных мощностей все большее внимание будет уделяться комплексным подходам к проектированию и обучению разреженных моделей, гармонично сочетающим сильнейшие стороны разного аппаратного обеспечения и программных оптимизаций.

Это открывает перспективы для создания супермасштабных, энергосберегающих и высокоэффективных AI-систем будущего. Для специалистов и команд, работающих с MoE, станет ключевым понимание не только теоретических преимуществ, но и практических ограничений, чтобы использовать современные аппаратные решения на полную мощность. Применение описанных стратегий и технологий позволит раскрыть потенциал разреженных моделей и значительно улучшить производительность обучающих систем искусственного интеллекта, открывая новые горизонты в их применении. .