В современном мире искусственный интеллект и большие языковые модели (LLM) играют все более важную роль в самых разных сферах жизни - от бизнеса до образования, от медицины до развлекательной индустрии. При этом эффективность работы таких моделей и их экономическая целесообразность становятся одними из ключевых вопросов как для исследователей, так и для предпринимателей. Недавно был предложен новый способ оценки эффективности LLM, который основывается на минимизации так называемых процессорных тиков, необходимых для достижения конкретной мысли или результата. Эта концепция представляет собой революционный подход к оптимизации вычислительных систем и способна изменить парадигму работы с языковыми моделями, значительно повысив их продуктивность и снизив затраты на вычисления. Процессорные тики в данном случае можно рассматривать как аналог базовых вычислительных операций - самых простых шагов, которые нужны для получения определенного результата.

Если представить, что для получения простой логической операции или проверки значения необходимости всего одного шага или тика, то более сложные задачи, например, формирование стратегии по увеличению дохода компании, требуют значительно большего количества шагов. Минимизация этой величины становится целью, поскольку чем меньше операций или токенов требуется модели для достижения результата, тем выше ее эффективность и тем меньше ресурсов потребляется. Идея сводится к поиску кратчайшего пути в сложной сети из токенов и предложений, которые могут привести к успеху в решении задачи. Такое представление напоминает маршрут в лабиринте: оптимальная модель - это та, которая быстрее всего находит выход, тратя минимальное количество шагов на то, чтобы сформировать нужное решение. По сути, это означает создание языковых моделей, которые способны быстрее понять суть запроса и направить генерацию текста в самое продуктивное русло, избегая излишних и бесполезных рассуждений.

Потенциал такого подхода огромен не только с точки зрения повышения производительности моделей, но и в плане экономии энергии и ресурсов, что особенно актуально в эпоху роста вычислительных мощностей и связанных с ними затрат. Каждый лишний токен, каждая дополнительная операция - это дополнительные расходы энергии и тепла, которые непросто компенсировать. Компании, использующие LLM в масштабных приложениях, чувствуют на себе эти расходы, что делает оптимизацию критически важной. Более того, минимизация количества токенов для достижения цели создает предпосылки для более тесного сотрудничества между ИИ-системами и людьми, а также между разными ИИ-моделями. Представьте себе экосистему, где множество агентных систем (агентных ИИ) взаимодействуют друг с другом и с реальными участниками рынка, быстро и эффективно обмениваясь важной информацией.

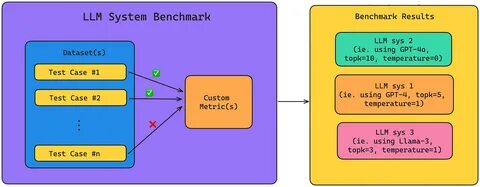

Такая синергия позволит не только повысить эффективность бизнес-процессов, но и способствовать общему росту экономики. Концепция может стать фундаментом для создания масштабных цифровых систем, направленных на увеличение ВВП и более справедливое распределение ресурсов. Экономическая составляющая в данном контексте приобретает особое значение. Большие языковые модели перестают быть сугубо исследовательским направлением и становятся инструментом предпринимательства и экономического роста. Ядром такой трансформации является именно метрика минимальных вычислительных тиков, поскольку она позволяет объективно оценивать и сравнивать эффективность разных систем, что важно для инвесторов и бизнес-лидеров.

Кроме того, это новое понимание эффективности предоставляет разработчикам шанс улучшить архитектуры своих моделей за счет оптимизации генерации и сокращения "шумовых" или дублирующих элементов в генерируемом тексте. Более экономичное использование токенов и более целеустремленный диалог с пользователем способны значительно улучшить качество пользовательского опыта и увеличить доверие к ИИ-инструментам. Тенденции показывают, что в будущем развитие больших языковых моделей будет все больше направлено на интеграцию с реальными бизнес-процессами и социальными механизмами, что позволит в реальном времени реагировать на изменения рынка и принимать решения с минимальными задержками и ошибками. Минимизация вычислительных тиков при этом становится одним из ключевых критериев, гарантирующих именно такую гибкость и адаптивность систем. В конечном счете, идея оптимизации через минимизацию количества процессорных операций или токенов - это не просто способ сэкономить вычислительные ресурсы.

Это концепция, способная вывести искусственный интеллект на принципиально новый уровень, позволив ему стать по-настоящему агентным, способным эффективно взаимодействовать с окружающим миром и приносить реальную пользу в виде роста производительности, экономической стабильности и устойчивого развития. Таким образом, можно ожидать, что в ближайшие годы исследовательские и бизнес-сообщества будут активно внедрять эту метрику в свои разработки и практики. Это открывает новые перспективы для создания более интеллектуальных, экономичных и полезных ИИ-систем, которые станут неотъемлемой частью повседневной жизни, бизнеса и общества в целом. .