Оптимизация кода — одна из важнейших задач разработчиков программного обеспечения, особенно в таких индустриях, как игровая разработка или обработка больших данных. Желание сделать программу быстрее и эффективнее понятно каждому, но не всегда стремление ускорить работу кода приводит к положительным результатам. Иногда под видом оптимизаций скрываются действия, которые не только не ускоряют программу, но и могут существенно ухудшить её производительность, читаемость и надежность. Понимание того, как неудачные оптимизации могут повлиять на конечный продукт, очень важно для любых специалистов, стремящихся улучшить качество программного обеспечения и избежать распространённых ошибок. Оптимизация ради самой оптимизации — частая ловушка.

В частности, многие разработчики начинают менять работу кода, не имея чёткого представления о проблемных местах или не проводя адекватного измерения производительности до изменений и после них. Такой подход исключает контроль и понимание влияния внесённых изменений и часто приводит к результатам, противоположным желаемым. В основе любой грамотной оптимизации лежит тщательное тестирование и комплексное профилирование кода. Без первоначальных замеров и анализа невозможно понять, где и сколько времени тратится во время выполнения программы. Это может привести к тому, что усилия будут направлены на улучшение тех участков, которые на самом деле не влияют существенно на общую скорость работы, тогда как настоящие «бутылочные горлышки» останутся без изменений.

Еще один значимый аспект — поддерживаемость кода. Часто разработчики стараются ускорить работу, жертвуя читаемостью и структурой. Оптимизированный, но непонятный и плохо документированный код становится скрытой бомбой замедленного действия. Подобные изменения могут усложнить будущие доработки и повлечь появление трудноуловимых ошибок. Примером того, как бездумные попытки оптимизировать производительность могут привести к проблемам, служит ситуация с системой кеширования в инструменте для экспорта сцен из Maya в формат COLLADA.

В попытке уменьшить время доступа к кешу был изменён алгоритм поиска данных, который предполагал ускорение поиска за счёт оптимизации под частые последовательные обращения к одним и тем же объектам. Однако в реальности эта реализация содержала логическую ошибку — кеш не обновлялся должным образом при смене объектов, из-за чего все данные собирались в одном месте, вызывая рост времени обработки пропорционально квадрату числа объектов в сцене. Такой баг стал причиной значительного замедления работы экспорта на больших моделях, хотя формально все функции продолжали работать корректно. Основной проблемой стала неудачная попытка оптимизации без предварительного измерения производительности и без контроля результата после изменений. Если бы с самого начала были сделаны замеры, и разработчики внимательно отслеживали результат, было бы выявлено, что время работы увеличивается, а не уменьшается.

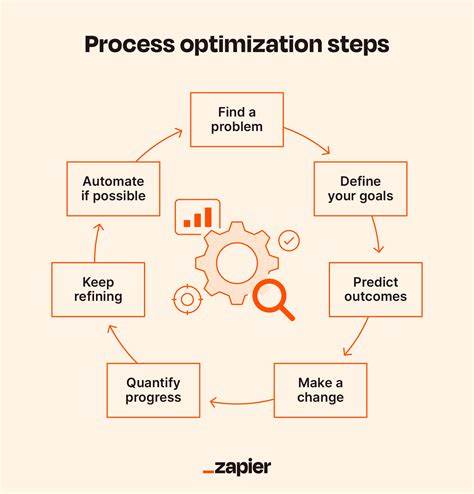

Это обучающая история показывает, что процесс оптимизации должен быть чётко структурирован и подкреплён объективными данными. Правильный подход к оптимизации включает несколько этапов. Для начала важно удостовериться в корректности исходного кода и обеспечить покрытие ключевых участков тестами или явными эталонными результатами. Далее нужно провести тщательное профилирование, чтобы определить узкие места в работе программы, и при этом выбирать репрезентативные и достаточно жёсткие условия тестирования – например, максимальное количество объектов в игровой сцене или самый сложный набор данных. Следующим шагом становится оптимизация, предпочтительно начиная с тех подходов, которые минимально влияют на архитектуру и удобочитаемость.

Это могут быть устранение избыточных вычислений, улучшение алгоритмической части или замена неэффективных структур данных. После каждой значимой модификации рекомендуется повторно запускать тесты и профилирование для оценки реального влияния изменений. Иногда в производственных условиях, например в разработке игр, возникает необходимость быстро добиться существенного прироста производительности, даже если при этом ухудшается поддерживаемость кода. В таких случаях важно, чтобы оптимизации были хорошо задокументированы, а риск возникновения ошибок – минимизирован за счёт актуального тестирования и мониторинга. Инструменты профилирования играют ключевую роль в процессе оптимизации.

Они позволяют измерить не только время выполнения функций, но и использование памяти, количество обращений к разным подсистемам, эффективность кешей процессора и прочие параметры. Без таких данных невозможно определить, являются ли изменения оптимальными или же они лишь мнимо улучшают ситуацию. Важно подчеркнуть, что оптимизация — это не универсальное благо. Некорректно проведённые изменения без контроля могут в итоге привести к ухудшению производительности, усложнению поддержки кода и росту числа ошибок. Опыт показывает, что лучше иметь немного более медленный, но стабильный и легко поддерживаемый код, чем запутанные оптимизации с непредсказуемыми последствиями.

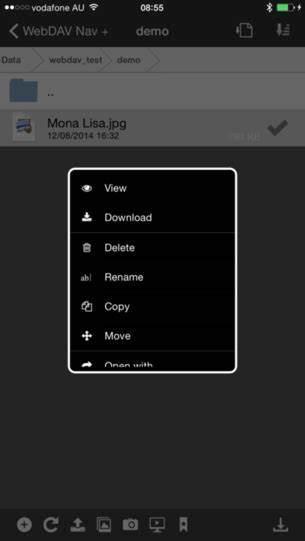

Особое внимание стоит уделить тому, чтобы результаты оптимизации были воспроизводимы и документированы. Сохранять результаты профилирования, фиксировать изменения и вести историю можно, например, в системах контроля версий с указанием процентов прироста или падения производительности после каждого коммита. Это помогает быстро определить, какое изменение привело к положительному результату, а какое — сломало производительность. Помимо технических аспектов, существует и психологический фактор. Некоторые разработчики могут считать, что профилирование занимает слишком много времени, либо воспринимают оптимизацию как творческий процесс, не требующий точных замеров.

![Volonaut Airbike – Raw Flight Experience Take Off and Landing [video]](/images/C3C2B1F0-AC4F-442E-918B-6884AF8F04F3)