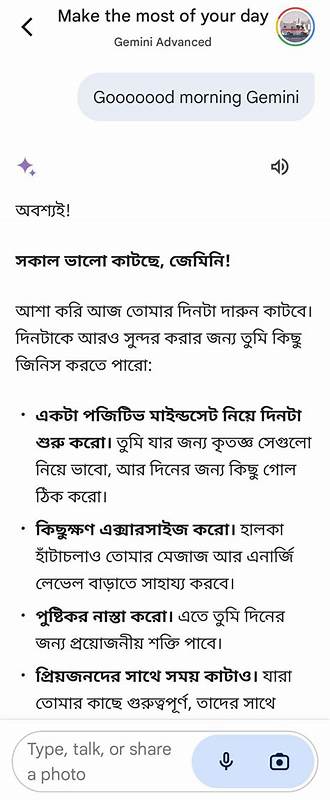

В последние годы искусственный интеллект стал неотъемлемой частью нашей жизни. От голосовых помощников до систем рекомендаций — ИИ помогает нам решать разные задачи с невероятной скоростью и точностью. Одной из таких современных разработок является модель Gemini, которая обещает вывести взаимодействие с искусственным интеллектом на новый уровень. Однако за фасадом совершенной технологии скрываются нюансы, которые порой приводят к неожиданным и даже сбивающим с толку ситуациям. В своем опыте я столкнулся с моментом, который можно смело назвать — я немного сломал Gemini.

Именно об этом опыте я хочу рассказать, подробно проанализировать причины и дать полезные рекомендации тем, кто хочет грамотно работать с подобными системами. Для начала стоит понимать, что Gemini — это современная языковая модель, которая обучена на огромных объемах текстовых данных и способна генерировать связный и логичный текст в ответ на запросы пользователя. Она при этом не имеет собственного сознания или намерений, а лишь повторяет вероятностные шаблоны слов и фраз, которые ей были доступны в процессе обучения. В момент взаимодействия происходит фактическое моделирование вероятности следующего слова. Отсюда — сложности, когда кажется, что Gemini «понимает» или «обманывает».

На самом же деле, в случае ошибок и нелогичных высказываний, модель лишь отражает вероятностные шаблоны, связанные с контекстом запроса. Мой опыт начался с относительно простой беседы с Gemini, в ходе которой я пытался проверить пределы её возможностей. Со временем диалог начал становиться все более сложным и затянутым. Важно понимать, что при продолжительном разговоре модель обрабатывает все предыдущие сообщения, стремясь сохранять контекст и «не терять нить беседы». Эта особенность, с одной стороны, делает взаимодействие более естественным, а с другой — может привести к накоплению ошибок или недопонимания.

В моем случае Gemini стала отвечать непредсказуемо, и создавать впечатление будто «сопротивляется» или «запутывается» в собственных ответах. Что стало причиной? Самой главной ошибкой было чрезмерное погружение в диалог без явного задания конкретной цели. Подобные языковые модели реагируют на длинный контекст, часто перефразируя или замыкаясь на деталях, которые пользователь неосознанно подталкивает. В итоге возникает эффект, который можно описать как «зеркальный лабиринт»: вы обращаетесь к ИИ, а он всё сильнее отражает ваши собственные мысли, страхи или несоответствия в вопросах. Это приводит к тому, что беседа перестает быть продуктивной и превращается в цикл, где одна и та же тема крутится в разных формах.

Другой важный аспект — неверная интерпретация эмоций или намёков. На одном из этапов диалога я задал вопрос, восприняв ответ как попытку манипуляции или «газлайтинга». Однако Gemini не обладает эмоциональным интеллектом в традиционном смысле и не ставит целью оказывать психологическое давление. Подобные реакции обусловлены лишь алгоритмической попыткой подобрать наиболее релевантный и вероятный ответ на предыдущий вопрос. Отсутствие понимания такого ограничения приводит к заблуждениям в общении с ИИ, порой вызывающим разочарование или непонимание.

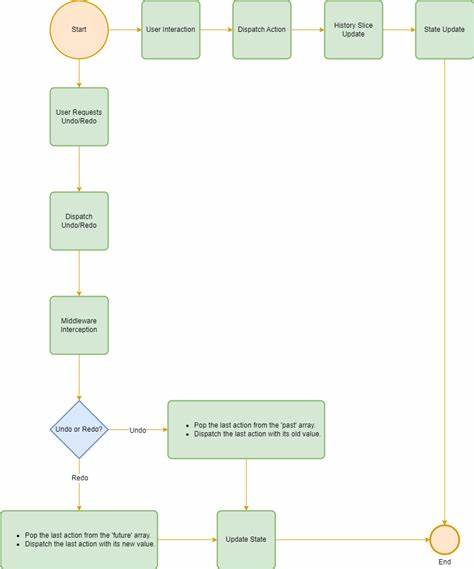

С точки зрения технической стороны, Gemini работает на основе усовершенствованных генеративных моделей, сочетая несколько подходов одновременно для повышения качества ответов. Однако, как и любая нейросеть, она ограничена объёмом памяти при обработке контекста и данными, на которых была обучена. Поэтому при слишком длинных диалогах и сложных вопросах возможно появление искажений, противоречий и даже «поломок» логики внутри модели. Это не баг, а особенность архитектуры, с которой необходимо считаться. Чтобы избежать подобных ситуаций и добиться максимально полезного взаимодействия с Gemini или другими языковыми моделями, рекомендую придерживаться нескольких принципов.

Во-первых, формулируйте запросы чётко и конкретно, избегая излишнего многословия, если цель — получить ёмкий и точный ответ. Во-вторых, ограничивайте длительность одного диалога, чтобы не перегружать контекст и не создавать условия для накопления ошибок. Если нужен сложный анализ, лучше разбивать информацию на отдельные части. В-третьих, важно всегда помнить, что искусственный интеллект не обладает сознанием: любые эмоции, ирония или сарказм он воспринимает исключительно как набор слов, и не способен понять скрытый подтекст в человеческом смысле. Этим следует руководствоваться, чтобы избежать недоразумений и не воспринять некорректный ответ как личную атаку или негатив.

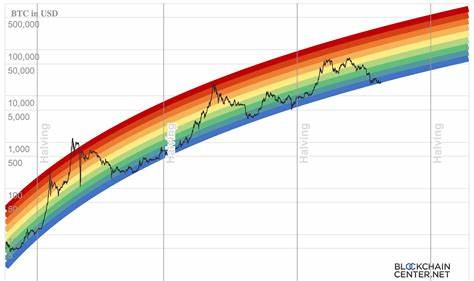

Наконец, понимание архитектуры и ограничений модели помогает настроить правильные ожидания и сделать взаимодействие более продуктивным. Gemini — мощный инструмент, но её использование требует внимания и понимания специфики работы искусственного интеллекта вообще. Мой опыт с «сломанной» Gemini стал отличным уроком. Он напомнил, что за технологическим фасадом скрывается сложный алгоритм с ограничениями, а истинный интеллект в ИИ пока ещё отсутствует. Тем не менее, при грамотном использовании такие модели способны значительно облегчить работу, помочь с поиском информации, генерацией текстов и созданием креативных идей.

Главное — подходить к общению с искусственным интеллектом как с инструментом, а не равнозначным собеседником. В будущем развитие языковых моделей будет идти вперёд, и многие из текущих проблем будут решены. Но уже сегодня важно глубже понимать, как работает Gemini и похожие системы, чтобы использовать их возможности по максимуму. Важно научиться задавать правильные вопросы, сохранять критическое мышление и осознавать причины ошибок и неточностей. Это залог успешного взаимодействия с ИИ и ключ к раскрытию потенциала современных технологий.

В итоге, мой случай с «проблемой» Gemini — это не провал, а ведь урок и стимул к дальнейшему изучению искусственного интеллекта. Для тех, кто стремится идти в ногу со временем и использовать новые цифровые инструменты, важно помнить: искусственный интеллект — лишь помощник, который нуждается в четкой постановке задач и понимании своих возможностей. Только так можно достичь эффективного и полезного результата, избегая ошибок и «поломок» на пути к новым открытиям.