В эпоху стремительного развития искусственного интеллекта и автоматизации, тестирование интеллектуальных агентов приобретает все большую значимость. Агентные системы становятся частью множества приложений — от голосовых помощников и чат-ботов до сложных корпоративных систем автоматизации. Именно поэтому возникает необходимость надежной методики проверки корректности их работы в самых разнообразных сценариях. Одним из наиболее перспективных подходов является симуляционное тестирование с использованием протокола AG-UI, позволяющего эмулировать поведение пользователей и оценивать реакции агентов в условиях, максимально приближенных к реальным. Концепция симуляционного тестирования базируется на создании имитационных моделей поведения пользователей, которые взаимодействуют с агентами по заранее определенным сценариям.

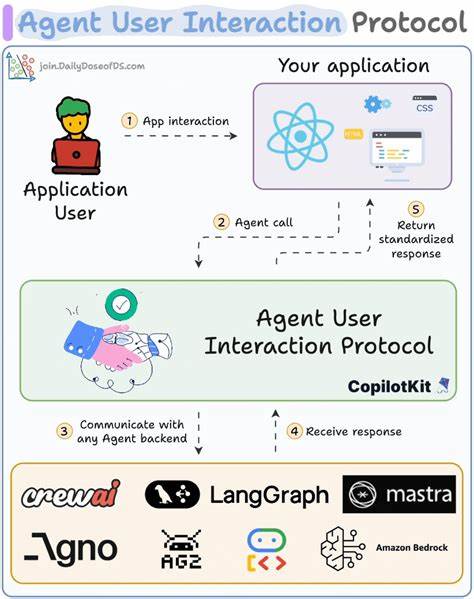

Протокол AG-UI выступает гибким каркасом, обеспечивающим стандартизированный обмен сообщениями между участниками симуляции — агентами и их имитаторами. Благодаря этому обеспечивается мощный контроль за диалогом, возможность работы с многошаговыми сценариями и глубокий анализ результата на различных этапах взаимодействия. Основным преимуществом использования симуляционного тестирования является возможность проверки агента в нестандартных, редких или граничных ситуациях, которые сложно воспроизвести при живом тестировании. Это позволяет выявлять скрытые недостатки в логике работы, предвзятости и ограничения модели, а также оценивать устойчивость к непредсказуемому поведению пользователей. Более того, AG-UI протокол обеспечивает совместимость с любыми основными LLM-фреймворками и позволяет внедрять кастомизированные метрики оценки, что делает процесс тестирования не только универсальным, но и адаптируемым под конкретные задачи и цели проекта.

Одним из показательных примеров использования такого подхода является тестирование агента, ориентированного на предоставление прогнозов погоды. Здесь симулируется сценарий, в котором пользователь планирует морскую поездку из Барселоны в Рим и интересуется погодными условиями. Сценарий предусматривает автоматическую генерацию сообщений пользователя имитатором, а также проверки, что агент корректно обращается к соответствующим инструментам, например, чтобы вызвать функцию получения текущих погодных данных. Такой тип тестирования помогает гарантировать не только корректный ответ на запросы, но и активное использование всех необходимых функций для достижения результата. Кроме того, протокол AG-UI поддерживает возможность непрерывного мониторинга и оценки при помощи так называемых Judge Agents, которые в режиме реального времени анализируют каждое сообщение, выносят вердикт о достижении целей сценария и управляют ходом симуляции.

Это позволяет проводить комплексное и многоступенчатое тестирование, где критерии успеха могут быть гибко настроены и включать в себя как лингвистические, так и функциональные аспекты работы агента. Важной особенностью такой системы является возможность комбинировать полностью автоматические сценарии с частичным скриптовым управлением, что расширяет возможности контроля: можно жестко прописать начало разговора, а дальше позволить имитатору и агенту взаимодействовать в свободном формате. Это существенно упрощает создание комплексных тестов, которые учитывают разные уровни предсказуемости и случайности поведения пользователей. Для разработчиков и команд, работающих с интеллектуальными агентами, значительным преимуществом будет наличие кроссплатформенной поддержки — библиотека Scenario доступна на Python, TypeScript и Go. Это обеспечивает легкую интеграцию в различные технологические стеки и упрощает применение симуляционного тестирования в существующих рабочих процессах.

Еще одним аспектом, который стоит отметить, является возможность кеширования результатов и управления репликабельностью тестов. Рандомизированное поведение симуляторов позволяет проверить агента в разных ситуациях, однако для отладки и воспроизведения багов важно иметь стабильные условия. Для этого в системе предусмотрены механизмы кэширования, включая декоратор @scenario.cache, который можно применять непосредственно к функциям вызова LLM или другим нестабильным операциям. В крупных проектах организованное управление тестами превращается в вызов само по себе.

Здесь на помощь приходит функционал группировки сценариев по набору тестов и пакетам, что удобно для структурирования, анализа и интеграции с CI/CD процессами. В частности, поддержка установки единого идентификатора пакета для всего прогона тестов помогает отслеживать качество агента при изменениях кода и быстро выявлять регрессии. Для повышения удобства отладки предусмотрены режимы визуализации и дебага, которые позволяют пошагово отслеживать сообщения между агентами и пользовательскими имитаторами. Эта возможность позволяет разработчикам в интерактивном режиме вмешиваться в диалог и менять сценарий «на лету», что значительно ускоряет поиск и устранение проблем. Стоит упомянуть и поддержку параллельного запуска тестов с помощью плагинов для pytest, что критически важно при большом объеме сценариев.