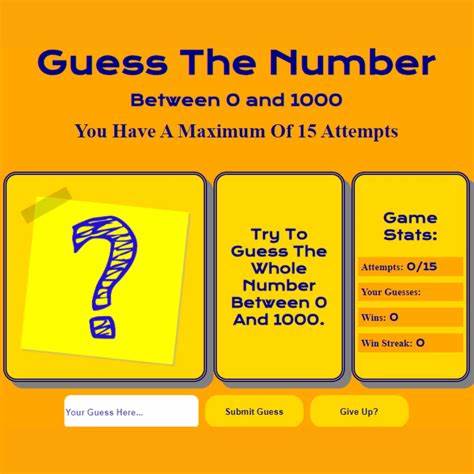

Искусственный интеллект и большие языковые модели (LLM) сегодня являются неотъемлемой частью современной технологической среды. Их способность обрабатывать, генерировать и интерпретировать текст открывает новые горизонты для исследований и практического применения. Одним из интересных феноменов, наблюдаемых при взаимодействии с LLM, является их поведенческая схожесть в задачах угадывания чисел, когда несколько моделей часто возвращают один и тот же ответ. Это явление вызывает вопросы о глубине понимания моделей, их случайности и возможных ограничениях. Игра угадывания чисел — классическая задача, в которой требуется предсказать или угадать заданное число, зачастую основанная на простых логических правилах или случайных догадках.

В контексте LLM задача часто сводится к генерации ответа на запрос с предположением числового значения. Многие пользователи заметили, что при одинаковых условиях и вводных данные модели, такие как GPT, BERT или другие языковые системы, нередко возвращают весьма схожие, а порой и одинаковые ответы. Почему так происходит? Основной источник сходства в ответах заключается в самом принципе работы LLM. Эти модели обучаются на огромных объемах данных, содержащих постоянно повторяющиеся шаблоны и закономерности. Они не имеют истинного понимания или интуиции, а работают на основе статистической вероятности следующего слова или символа в последовательности.

Когда вопрос формулируется одинаково, вероятностная модель предсказывает наиболее вероятный ответ, который чаще всего встречается в данных — и именно этот ответ оказывается в выдаче вне зависимости от модели. Еще одним фактором является ограничение творческого хаоса в генерации текста. Модели могут использовать разные параметры, такие как температура или топ-к, которые регулируют степень разнообразия и случайности в ответах. При низких параметрах генерации модели склонны вырабатывать устойчивые и повторяемые варианты ответов. Если же увеличить степень случайности, ответы становятся более разнообразными, но одновременно теряется достоверность и последовательность.

В следствие этого даже при возможности «угадывать» число разнообразие ответов часто сведено к минимуму, чтобы сохранить логичность и грамматику. Также стоит рассмотреть влияние обучающих данных. Во время подготовки языковой модели ей предоставляется множество примеров типичных диалоговых ситуаций и задач, включая и числовые вопросы. Поскольку многие из этих примеров содержат определенные числовые ответы или закономерности, модель усваивает эти шаблоны и использует их повторно. Это порождает эффект конформизма, когда несколько моделей, обученных на схожих наборах данных, в конечном итоге генерируют схожие ответы.

Проблема угадывания чисел приобретает особое значение, если рассматривать ее сквозь призму применения LLM в реальных сценариях. Например, в совместной работе с ИИ по решению математических задач, прогнозированию или принятии решений модель может казаться менее «творческой» и инициативной, если повторяет стандартные, шаблонные ответы. Это ограничивает потенциал адаптации и развития в областях, где требуется индивидуальный подход и новаторство. Кроме того, одинаковые ответы у разных моделей могут создавать впечатление взаимозаменяемости и однообразия. Пользователи иногда ожидают, что каждая модель будет иметь свою уникальную «личность» или способ мышления, однако на практике это не так.

Большинство современных LLM работает на одинаковом принципе языкового моделирования и обучается на пересекающихся корпусах, что снижает разницу в их реакциях. Но нельзя сказать, что это всегда минус. Стабильность и повторяемость в ответах значительно повышают надежность систем, когда важна точность и доверие к результатам. В играх или задачах, где требуется единообразная логика, повторяемость моделей — положительное качество. В таких случаях одинаковые ответы свидетельствуют о правильной работе алгоритмов, а не об их недостатках.

Исследования в области нейросетевых моделей продолжают развиваться, и ученые ищут пути достижения баланса между разнообразием и точностью. В будущем возможно появление гибридных систем, сочетание детерминированных и стохастических подходов, которые позволят моделям генерировать более уникальные и адаптированные ответы. Усилия направлены и на улучшение внутреннего понимания моделей посредством дополнительных обучающих процедур и архитектурных новаций. Таким образом, сходство ответов при игре в угадывание чисел — естественное явление, обуславливаемое основами обучения и генерации больших языковых моделей. Это отражает их природу как вероятностных систем, способных воспроизводить наиболее подходящие и правдоподобные варианты без глубокого смылового осмысления числовых загадок.

Осознание этого поможет лучше понимать возможности и ограничения современных AI-систем и разумно использовать их сильные стороны в различных сферах деятельности.

![BattleBots: Greg Munson and Trey Roski [video] (2024)](/images/1C0D34D5-7D1E-424E-8FC4-8B827DD828FE)