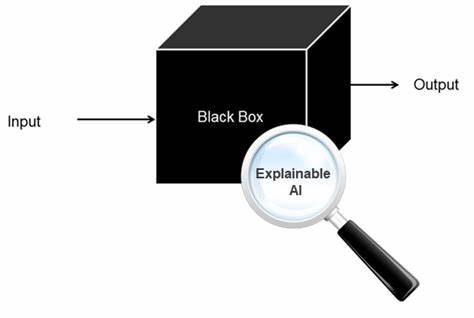

В эпоху цифровизации и стремительного развития технологий искусственный интеллект (ИИ) стал неотъемлемой частью многих сфер нашей жизни. Однако, несмотря на все его преимущества, существует одна серьезная проблема, известная как «проблема черного ящика». Эта проблема, касающаяся непредсказуемости и непрозрачности алгоритмов ИИ, вызывает беспокойство у исследователей, разработчиков и даже у потребителей. В этой статье мы рассмотрим основные вызовы, связанные с проблемой черного ящика, а также возможные решения, позволяющие создать более прозрачное будущее. Что такое проблема черного ящика? Проблема черного ящика в контексте ИИ относится к сложным алгоритмам, которые принимают решения или делают прогнозы без возможности объяснения, как именно они к этим выводам пришли.

Несмотря на отличные результаты, которые показывает ИИ в таких областях, как распознавание изображений, обработка естественного языка и прогнозирование, методы, лежащие в основе этих технологий, часто остаются для нас непрозрачными. Это означает, что разработчики и пользователи не всегда могут понять или объяснить, почему ИИ принимает именно такие решения или как он пришел к конкретному выводу. Вызовы проблемы черного ящика Основные вызовы, связанные с проблемой черного ящика, включают: 1. Недостаток доверия: Если пользователи не могут понять, как работает система ИИ, они могут недоверять ее выводам. Это может быть проблемой в таких критически важных областях, как медицина, правосудие и финансовые услуги, где неправильные решения могут иметь серьезные последствия.

2. Этические и юридические вопросы: Проблема черного ящика также поднимает важные этические и юридические вопросы. Например, если ИИ принимает решение, затрагивающее права человека, кто несет ответственность за это решение? Разработчик, пользователь или сам алгоритм? 3. Отсутствие объяснимости: Возможность объяснить, как работает ИИ, становится важной в ситуациях, когда требуется отчитываться о принятых решениях. Это необходимо не только для соблюдения законодательства, но и для поддержания доверия со стороны пользователей.

Решения для повышения прозрачности Несмотря на все вызовы, связанные с черным ящиком, существует ряд решений, направленных на повышение прозрачности и объяснимости ИИ: 1. Разработка объясняемого ИИ: Один из подходов заключается в создании так называемого объясняемого ИИ (XAI). Это направление исследований направлено на разработку алгоритмов, которые могут предоставлять понятные и доступные объяснения своих решений. Например, вместо того чтобы просто выдавать ответ, такая система могла бы пояснить, какие факторы повлияли на ее вывод. 2.

Использование интерпретируемых моделей: Разработчики могут выбирать более простые и интерпретируемые модели вместо сложных черных ящиков. Например, линейные регрессии или деревья решений могут обеспечить большую прозрачность в случае принятия решений, хотя и с определенной потерей точности. 3. Внедрение стандартов и норм: На уровнях государственной и международной политики следует разработать и внедрить стандарты и нормы, касающиеся объяснимости ИИ. Это создаст определенные рамки, в которые должны укладываться разработчики ИИ, что может повысить уровень доверия со стороны общества.

4. Участие заинтересованных сторон: Важно, чтобы разные заинтересованные стороны, такие как разработчики, пользователи, исследователи и регуляторы, сотрудничали для создания более прозрачного ИИ. Этот коллективный подход может помочь в выявлении проблем и разработке решений, которые учитывают интересы всех участников. 5. Обучение и информирование пользователей: Образование и информирование публики о том, как работает ИИ, его возможностях и ограничениях, являются важным аспектом повышения доверия.