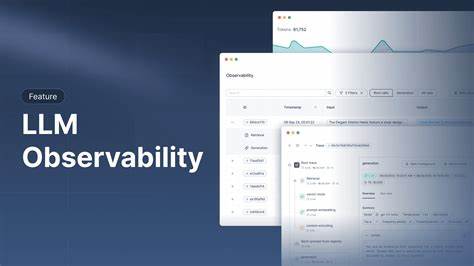

В последние годы наблюдаемость больших языковых моделей (LLM) приобрела критическое значение для развития и поддержки приложений на базе искусственного интеллекта. С ростом спроса на прозрачность поведения моделей, анализ потребления токенов и выявление узких мест производительности становятся обязательными задачами для любой команды, работающей с ИИ. В этом контексте технология ClickHouse с открытым исходным кодом и специально созданный для наблюдаемости стэк ClickStack предоставляют мощные возможности для обработки и анализа огромных объемов данных, получаемых в ходе взаимодействия с LLM. ClickStack — это комплексное решение, включающее в себя пользовательский интерфейс HyperDX, OpenTelemetry коллектор и базу данных ClickHouse, позволяющее собирать, хранить и визуализировать логи, метрики и трассировки. Вместе с этим, протокол Model Context Protocol (MCP) открывает новую эру интеграции LLM с внешними сервисами, позволяя моделям не только отвечать на вопросы, но и активно взаимодействовать с базами данных, API и другими системами через стандартизованный и упрощённый интерфейс.

Это превращает модели в полноценные агентные системы с мгновенным доступом к актуальной информации. LibreChat — это современная платформа для чатов на искусственном интеллекте, объединяющая модели различных провайдеров в одном интерфейсе. Благодаря модульной архитектуре и поддержке MCP, LibreChat позволяет легко расширять функциональность, интегрировать плагины и использовать мультиязычные возможности. В связке с MCP-сервером ClickHouse, который выступает в роли высокопроизводительного аналитического движка, достигается высокая отзывчивость и масштабируемость при работе с реальными пользовательскими запросами. Инструментирование LibreChat и MCP сервера для отслеживания метрик и трассировок реализуется с помощью OpenTelemetry.

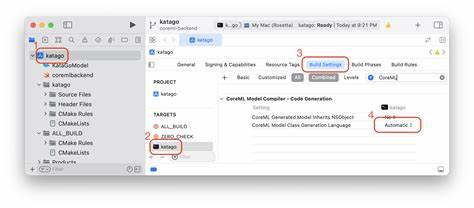

Для Node.js приложения LibreChat интеграция происходит через добавление специальных зависимостей и перезапуск процесса с использованием OpenTelemetry-инструментации. Это позволяет с минимальными изменениями кода начать сбор детальной информации о взаимодействиях пользователей с сервисом. Аналогично, MCP-сервер, написанный на Python, оснащается автозапуском OpenTelemetry, благодаря чему метрики и логи отправляются централизованно в ClickStack. Для сбора логов из разных компонентов системы используется дополнительный OpenTelemetry коллектор, который вместе с прометеевским ресивером обеспечивает сбор как логов, так и метрик.

Логи пишутся в структурированном формате JSON для упрощённого парсинга и дальнейшего анализа. Общая архитектура системы поддерживает разделение обязанностей и удобство масштабирования компонентов. Самое важное преимущество такой интеграции — это возможность проводить продвинутую аналитику и визуализацию взаимодействий с LLM, включая подробный учёт расхода токенов как на запросы, так и на ответы моделей. Это особенно критично в продакшен-системах, где стоимость вычислений напрямую зависит от количества обработанных токенов. Наличие данных в ClickHouse позволяет формировать сложные SQL-запросы для агрегации и детализации статистики, что значительно лучше классических инструментов для наблюдаемости.

В процессе работы наблюдаемости фиксируются уникальные идентификаторы разговоров и отдельных взаимодействий (conversationId и TraceId), что дает возможность прозрачно отслеживать всю цепочку обработки запроса от пользователя через LLM до MCP-сервера и обратно. Дополнительно фиксируются такие параметры, как количество токенов во входящем запросе, количество сгенерированных токенов ответа, а также само содержание запроса, что обеспечивает глубокое понимание качества и эффективности взаимодействия. Для проверки точности учета токенов была проведена сверка с официальной панелью OpenAI, что подтвердило высокое соответствие подсчетов, реализованных через ClickStack. Это дополнительно убедило в надежности и практической применимости данного подхода для контроля затрат и оптимизации работы с API провайдеров. Опыт показывает, что с помощью ClickStack можно не только мониторить базовые показатели, но и выявлять аномалии, например, резкие скачки использования токенов или необычные задержки в ответах.

Наличие удобной визуальной панели HyperDX облегчает настройку оповещений и мониторинг ключевых показателей в режиме реального времени, что помогает своевременно реагировать на потенциальные проблемы. Сочетание OpenTelemetry для единообразного сбора телеметрии, MCP для расширенной интеграции LLM с современными сервисами и ClickStack для хранения и анализа предоставляет комплексный и масштабируемый подход наблюдаемости. Он подходит как для стартапов, тестирующих инновации в области ИИ, так и для крупных компаний, стремящихся к контролю качества и оптимизации затрат в масштабных проектах. Кроме технических преимуществ, данный стек поддерживает активное сообщество и постоянно развивается. Благодаря открытости и доступности исходных кодов, любой инженер может адаптировать и расширить функциональность под свои нужды, интегрируя новые источники данных, строя кастомные дашборды и модели анализа.

Таким образом, наблюдаемость LLM — это не просто модная тенденция, а необходимость для обеспечения эффективной, надежной и экономичной работы AI-приложений. Использование ClickStack, OpenTelemetry и MCP открывает широкие возможности в этом направлении, позволяя получить полный контроль над процессом и превратить большие объемы данных в ценные инсайты. Подводя итог, важно отметить, что внедрение систем наблюдаемости на базе упомянутых технологий требует первоначальных усилий по настройке и интеграции, но их отдача в виде улучшенного понимания поведения моделей, оптимизации затрат и повышения качества пользовательского опыта окупается многократно. Это фундамент современного подхода к эксплуатации и развитию AI-продуктов, который будет только набирать популярность в ближайшие годы.