В последние годы искусственный интеллект стремительно проникает во все сферы жизни, и наука не стала исключением. Особенно заметно влияние чатботов, таких как ChatGPT, в биомедицинских исследованиях, где письменные тексты играют ключевую роль в распространении новой информации. Совсем недавно ученые выявили особенности лингвистического стиля, характерного для текстов, написанных с помощью ИИ, что позволяет отследить степень использования таких инструментов в научных статьях, в частности, в их аннотациях. Работа Дмитрия Кобака из Университета Тюбингена и его коллег стала прорывом в понимании того, как чатботы воздействуют на научное письмо. Используя анализ более 15 миллионов биомедицинских аннотаций, опубликованных с 2010 по 2024 годы, исследователи заметили резкий рост частоты использования определенных слов и выражений после появления ChatGPT в ноябре 2022 года.

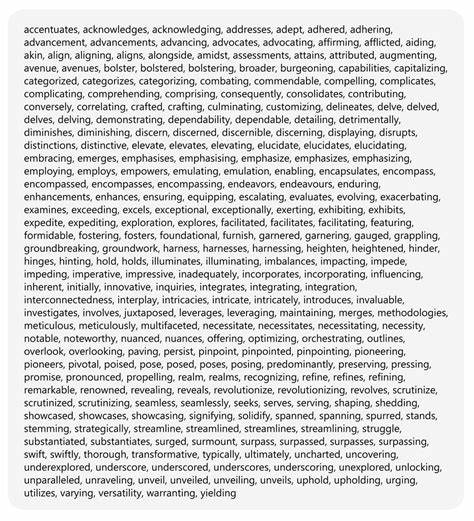

Среди них оказались такие слова, как «глубокое изучение», «ключевой», «потенциальный», «значимый» и «важный». Эти слова встречались на порядок чаще, чем в текстах, написанных исключительно людьми, что послужило основой для создания словаря из 454 терминов, избыточно используемых чатботами. С помощью этого словаря исследователи провели вычислительную оценку вероятности того, что конкретная биомедицинская аннотация была полностью или частично написана при помощи искусственного интеллекта. Результаты оказались впечатляющими: по оценкам команды Кобака, не менее 13,5% всех аннотаций в биомедицинской литературе за 2024 год имеют признаки ИИ-сопровождения. Особенно высокие показатели были обнаружены среди авторов из некоторых стран и в журналах с меньшими строгими критериями отбора — там доля ИИ-созданных аннотаций достигала 40%.

Эти данные вызывают широкий общественный и профессиональный резонанс. С одной стороны, использование чатботов облегчает исследователям задачу формулировки результатов, экономит время и способствует быстрому распространению знаний. С другой стороны, возникает ряд этических вопросов, связанных с достоверностью и оригинальностью научных публикаций. Если значительная часть статьи или даже лишь ее аннотация создается искусственным интеллектом, как проверить, что информация точна и не искажена в процессе машинной интерпретации? В научной среде продолжаются дискуссии о том, где проходит грань между допустимым использованием ИИ-инструментов для оформления текста и недобросовестным копирайтингом, который может подорвать доверие к исследованиям. Многие крупные журналы и издательства уже разрабатывают политики, регулирующие применение искусственного интеллекта при подготовке рукописей, требуя раскрывать этот факт в сопроводительных документах.

Кроме того, появление так называемого «эйджентского языка» — отличительного стиля, с характерным выбором слов и фраз, часто используемых ИИ — позволяет автоматизировать процесс поиска подобных публикаций. Понимание этих лингвистических маркеров способствует совершенствованию систем проверки оригинальности и предотвращению злоупотреблений. Отдельное внимание уделяется региональным особенностям. В странах с развивающейся научной инфраструктурой и большим объемом публикаций в менее конкурентных журналах ИИ-инструменты воспринимаются как способ повысить качество и ускорить процесс написания текстов для международной аудитории. Однако такой прессинг приводит к размыванию границ между оригинальной исследовательской работой и её автоматизированным переосмыслением.

Технологическое развитие в области искусственного интеллекта неумолимо меняет облик научного сообщества. Учёные все чаще используют чатботы не только для написания аннотаций, но и для анализа данных, генерации гипотез и даже разработки экспериментальных протоколов. Это открывает новые горизонты, но одновременно усиливает необходимость разработки строгих этических норм и прозрачных стандартов использования ИИ в научных публикациях. В долгосрочной перспективе эффект внедрения чатботов в науку может оказаться революционным. Снижение порога вхождения для молодых ученых, увеличение скорости публикаций и расширение доступа к сложной информации создадут более динамичную и взаимосвязанную исследовательскую среду.

Вместе с тем, важно сохранить баланс между инновациями и качеством, чтобы избежать превращения научных трудов в набор шаблонных фраз без глубокого понимания и оригинального вклада. Исследования, подобные работе Дмитрия Кобака и его коллег, дают глубокое понимание текущих трендов и помогают научному сообществу адаптироваться к новым условиям. Они также служат напоминанием о необходимости развития информационной грамотности и критического мышления при чтении и оценке научных текстов, что становится важнее в эпоху ИИ. Появление 454 «подсказок» в виде ключевых слов и выражений, использующихся чатботами, — это своеобразный индикатор перестроек в научной коммуникации. Благодаря таким исследованиям можно не только выявлять и регулировать использование искусственного интеллекта в научных публикациях, но и лучше понимать взаимодействие человека и машины в процессе создания знания.

В свете этих изменений биомедицинское сообщество стоит перед выбором: интегрировать ИИ-технологии с продуманной и строгой нормативной базой или рисковать утратой прозрачности, качества и доверия в научной работе. Очевидно, что будущее науки будет тесно связано с искусственным интеллектом, и уже сейчас важно готовиться к новым вызовам и возможностям, открывающимся перед исследователями, авторами и издателями.