В последние годы искусственный интеллект (ИИ) стремительно интегрируется в самые разные сферы жизни, обещая повысить эффективность и безопасность рабочих процессов. Особенно это актуально в областях с высокими ставками, таких как авиация, здравоохранение и энергетика. Казалось бы, союз человека и ИИ должен приводить к лучшим результатам, но исследование, проведённое AI nonprofit METR, показало обратную сторону такого сотрудничества. Результаты ошеломили даже экспертов — например, программисты с доступом к ИИ-инструментам работали на 19% дольше, хотя сами считали, что выполняют задачи быстрее на 20%. Более того, в сферах с критической ответственностью полагаться на ИИ оказалось даже опаснее — доступ к искусственному интеллекту в некоторых случаях значительно снижал качество работы специалистов, что в конечном итоге могло приводить к серьёзным авариям и даже угрозе жизни.

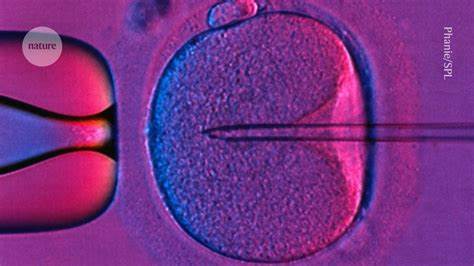

Представим ситуацию в авиации, когда экипаж самолёта во время захода на посадку полагается на AI-метеомонитор, который не выявил внезапный микробустер — резкое погодное явление, способное привести к потере подъёмной силы. Ни пилоты, ни автопилот не получили своевременного предупреждения, и только после возникновения опасной ситуации пришлось оперативно принимать меры по выходу из критической позиции. Аналогичная проблема появляется и в медицинской сфере. Ночные дежурные медсёстры, пользующиеся ИИ-дашбордами, которые призваны фильтровать ложные тревоги и оценивать состояние пациентов, иногда сталкиваются с тем, что алгоритмы неправильно интерпретируют симптомы. Например, в одном случае ИИ оценил состояние больного как «низкорисковое», но через несколько минут поступил сигнал о резком падении уровня кислорода — медики пытались стабилизировать пациента, обнаружив поздно нарастающую опасность, которую ИИ проигнорировал.

В энергетическом секторе ситуация тоже тревожна. На атомных электростанциях, где инженерная бригада работает при поддержке AI-системы фильтрации и приоритизации аварийных сигналов, может случиться, что ошибка ИИ будет маскировать постепенно нарастающую неисправность, например, снижение давления в системе охлаждения. Если такое отклонение помечается как незначительное и не требует вмешательства, авария может развиться до критического состояния. В истории уже зафиксированы случаи, когда благодаря усилиям операторов удавалось предотвратить катастрофу, однако последствия оставались серьёзными, включая длительную остановку станций и финансовые потери. Основная причина подобных инцидентов — не только технические ограничения ИИ, но и глубже: изменённый человеческий подход к принятию решений под влиянием AI.

В ходе исследований с использованием так называемого Joint Activity Testing учёные изучали как именно совместная работа людей и ИИ приводит к результатам в различных сценариях. Такие тесты помогают выявлять, как меняется поведение человека в зависимости от качества AI-помощи: при точных предсказаниях ИИ специалисты делают меньше ошибок, однако при ошибочных сигналах их производительность резко падает, порой до критичных значений. Особенно удивительно, что опыт и квалификация операторов не всегда помогают им корректно оценивать достоверность ИИ и вовремя вмешиваться в процесс. Таким образом, автоматизация и вспомогательные технологии формируют новую модель взаимодействия, где человек перестаёт критически фильтровать информацию, а зачастую принимает предложения ИИ за истину. Традиционные методы оценки безопасности и эффективности ИИ, которые рассматривают алгоритмы отдельно от человеческого фактора, оказываются недостаточными.

Усреднённые показатели и упрощённые метрики маскируют редкие, но чрезвычайно опасные ошибки, которые могут привести к катастрофам. Именно поэтому необходим целостный подход, учитывающий динамику совместной деятельности и вариативность ситуаций, с учётом сильных, средних и слабых результатов ИИ. Результаты Joint Activity Testing доказали, что единственным надёжным способом предотвращения подобных провалов является тестирование человек-ИИ команд вместе, а не по отдельности, причём в условиях максимально приближенных к реальным. Важно не только выявлять уязвимости в самом алгоритме, но и обучать специалистов распознавать сбои в работе ИИ и корректно реагировать на них. При этом нельзя полагаться исключительно на обновления и патчи — они неспособны предотвратить все потенциальные проблемы и иногда сами становятся источником новых рисков.

Предлагается сосредоточить усилия на создании систем поддержки пользователей, которые помогают людям восстанавливаться после ошибок ИИ и принимать дополнительные меры по обеспечению безопасности. Представленные данные поднимают серьёзные вопросы этического и практического характера. Внедрение ИИ в ответственные сферы требует не только совершенствования алгоритмов, но и глубокого понимания влияния технологий на человеческое поведение, создание новых стандартов тестирования и обучения, а также постоянного мониторинга взаимодействия людей с машинами. Очевидно, что в ближайшем будущем важно развивать междисциплинарные исследования, объединяющие специалистов по инженерии, когнитивным наукам, безопасности и этике. Только так можно обеспечить успешное и безопасное сосуществование человека и искусственного интеллекта.

В условиях, когда ставки чрезвычайно высоки, пренебрежение такими аспектами может стоить жизни и здоровья людей, а также нанести урон инфраструктурам и экономике. В историческом контексте нельзя забывать, что каждая технологическая революция ставила перед человечеством новые вызовы и требовала адаптации. Сегодня как никогда важно осознанно подходить к вызовам цифровой трансформации, не воспринимая ИИ как панацею, а рассматривая как инструмент с двойным эффектом. Итогом может стать не только повышение эффективности, но и умение предотвращать ошибки и восстанавливаться после них. Таким образом, будущее безопасного и продуктивного применения искусственного интеллекта в сферах с высокими рисками зависит от комплексного анализа совместной работы человека и машины, внедрения новых методов тестирования и постоянного развития систем поддержки пользователей.

Только ответственность и системный подход помогут превратить ИИ в надежного партнёра, способного действительно улучшить результаты в самых сложных и чувствительных областях деятельности.