В последние годы использование больших языковых моделей (LLM) в научных исследованиях и рецензировании стремительно возросло. Такие инструменты, как GPT и другие продвинутые ИИ-системы, помогают исследователям формировать тексты, генерировать идеи и даже писать критические обзоры. Однако вместе с ростом популярности ИИ возникает острая необходимость контролировать прозрачность и этичность использования этих технологий в академической среде. В частности, важно уметь выявлять фрагменты текстов, созданных ИИ, чтобы соблюдать стандарты научной честности и ответственности. Новейшие AI-инструменты разработаны именно для этой цели - определить, был ли текст сгенерирован человеком или большой языковой моделью.

Их применение стало актуальным ответом на резкое увеличение количества рукописей и рецензий, содержащих элементы ИИ-созданного контента, при этом многие авторы игнорируют или умышленно не указывают использование подобных технологий, что противоречит правилам многих научных журналов. Технически такие детекторы применяют комплексные алгоритмы анализа лингвистических особенностей текста, стилистических паттернов и статистических аномалий. Модели тренируются на больших объемах данных с текстами, написанными либо людьми, либо ИИ, и способны выявлять характерные маркеры машинного генезиса. Это позволяет устанавливать с достаточно высокой точностью, где и насколько контент был автоматизировано сгенерирован. Помимо чисто технических аспектов, важной темой становится этическая сторона вопроса.

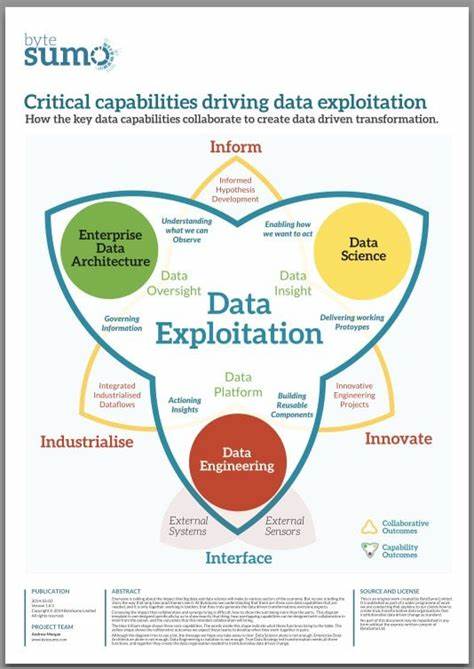

Полное отсутствие указания на применение языковых моделей нарушает принципы открытости и может привести к подрыву доверия к научным публикациям и процессу рецензирования. В то же время существование таких инструментов стимулирует авторов к большей честности и соблюдению норм. Однако нельзя забывать и о том, что развитие ИИ открывает новые возможности для оптимизации работы исследователей, особенно в подготовительной стадии создания рукописей и обработки данных. Поэтому задача научного сообщества состоит в том, чтобы грамотно интегрировать искусственный интеллект, не подрывая при этом фундаментальные ценности науки. В число вызовов входят и вопросы конфиденциальности, так как некоторые инструменты несут риск передачи данных третьим сторонам, особенно если речь идет об онлайн-сервисах, использующих облачные технологии.

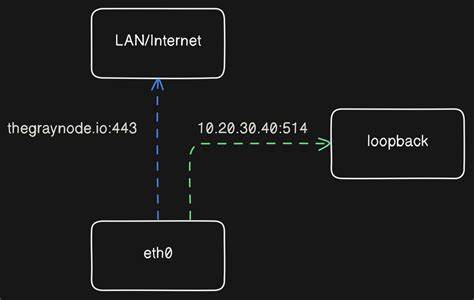

Важно использовать платформы, полностью соответствующие международным нормам защиты персональной информации. Публикация материалов с выявленными фрагментами ИИ-контента требует подготовки новых рекомендаций для редакторов и рецензентов. В частности, возможно введение обязательных полей для указания степени участия ИИ в создании статьи или оценке ее качества. Это поможет более объективно оценивать заслуги авторов и роль технологий. Разработчики таких инструментов продолжают совершенствовать алгоритмы, чтобы снижать вероятность ложных срабатываний и учитывать специфику разных областей науки.

В частности, технические дисциплины и гуманитарные науки располагают разным стилем изложения, что усложняет задачу. В совокупности, появление и развитие AI-детекторов соответствует естественным потребностям современной научной коммуникации и поддержанию стандартов. В перспективе они станут обязательным компонентом редакторских платформ и служб рецензирования, обеспечивая высокое качество и прозрачность публикаций. Таким образом, современный этап развития науки активно перекликается с технологическими инновациями в области искусственного интеллекта - от генерации контента до контроля его подлинности. Именно поэтому исследовательское сообщество должно не только принимать новые инструменты, но и формировать правильные этические и правовые рамки для их использования, обеспечивая баланс между удобством и ответственностью.

Благодаря этому можно сохранить доверие к научным результатам и обеспечить их максимальную ценность для общества. .