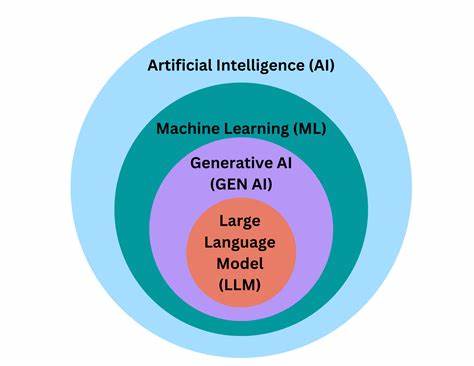

Современное развитие больших языковых моделей (LLM) значительно расширяет возможности искусственного интеллекта в различных сферах. Одним из ключевых аспектов эффективного использования таких моделей является создание и оптимизация так называемых промптов — специальных текстовых запросов и инструкций, которые напрямую влияют на поведение модели и качество генерируемого контента. С увеличением количества версий промптов и необходимостью отслеживать их изменения традиционные методы сравнения, основанные на текстовом диффе, оказываются недостаточно информативными. В таких условиях становится актуальным использование более глубоких, смысловых методов анализа изменений, что и предлагает инструмент LLM Prompt Diff, реализующий семантическое диффинг-сравнение в Git-стиле. Инструмент LLM Prompt Diff позиционируется как легковесный CLI (командный интерфейс), который помогает разработчикам и специалистам по AI эффективно управлять промптами, сравнивать их изменения на смысловом уровне, и интегрировать эти операции в процессы CI/CD.

Главная особенность решения — способность выявлять значимые изменения в семантике промптов, которые могут существенно влиять на поведение больших языковых моделей, в отличие от стандартных текстовых diffs, которые фиксируют только поверхностные изменения. Функциональные возможности LLM Prompt Diff охватывают генерацию скелетных шаблонов промптов и создание манифестов с поддержкой семантического версионирования. Инструмент упаковывает промпты в специальные JSON-файлы формата .pp.json, которые содержат не только сам текст, но и эмбеддинги — векторные представления смыслового содержания.

Это позволяет проводить сравнительный анализ двумя основными провайдерами эмбеддингов: локальным (SentenceTransformers с моделью all-MiniLM-L6-v2) и облачным (OpenAI). Благодаря этому пользователи могут выбирать подходящий вариант в зависимости от потребностей и ограничений инфраструктуры. Использование семантического диффа позволяет определить процент сходства между разными версиями промптов. Такой подход особенно ценен для автоматизации тестирования и верификации, поскольку интеграция с CI/CD позволяет формировать машинно-читаемый JSON-отчет и выставлять коды завершения в случае отклонения изменений за заданный порог. Это помогает предотвращать попадание в продакшн недоработанных или нежелательных модификаций, обеспечивая более стабильное и предсказуемое поведение модели.

Сам процесс работы с LLM Prompt Diff начинается с инициализации нового промпта, что создает базовую структуру и манифест. После внесения необходимых изменений пользователь может упаковать промпт, сгенерировав обновленные эмбеддинги и версию. Далее инструмент позволяет сравнить две версии, получив понятный отчёт с указанием уровня семантического сходства и подтверждением соответствия установленным критериям. Помимо этого, предусмотрена проверка корректности формата манифеста, что гарантирует надежность и совместимость данных. Одним из значимых преимуществ данной технологии является обеспечение безопасности и конфиденциальности.

По умолчанию все вычисления выполняются локально, и никакие данные не покидают машину пользователя, если не выбран вариант с облачным провайдером. Такая архитектура минимизирует риски утечки информации и повышает доверие к использованию инструмента в коммерческих проектах. Для разработчиков предоставлены подробные инструкции по установке, включая установку через PyPI и из исходного кода с подготовкой виртуального окружения. Также в репозитории предусмотрен набор тестов с хорошим покрытием, что свидетельствует о серьезном подходе к качеству и стабильности инструмента. LLM Prompt Diff представляет собой важный шаг вперед в управлении и эволюции промптов для больших языковых моделей.

Переход от поверхностного текстового сравнения к глубинному, семантическому анализу позволяет командам быстрее обнаруживать регрессии, оптимизировать промпты и обеспечивать высокое качество взаимодействия с AI-системами. Такой подход не только повышает производительность специалистов, но и способствует устойчивому развитию искусственного интеллекта в бизнесе и науке. Применение LLM Prompt Diff в рабочих процессах — это возможность строить более прозрачные и надежные пайплайны подготовки моделей, где контроль изменений становится неотъемлемой частью разработки. Особенно оно актуально для компаний и стартапов, которые активно работают с кастомизированными промптами и хотят минимизировать риски, связанные с неявными ошибками и ухудшением результата из-за неконтролируемых изменений. Таким образом, LLM Prompt Diff — это не просто еще один инструмент для сравнения файлов, а мощный помощник в обеспечении качества промптов, который сочетает в себе передовые методы глубокого анализа и удобство интеграции.

Инновационная концепция семантического git-стиля диффинга открывает новые горизонты для управления искусственным интеллектом и помогает максимально раскрыть потенциал больших языковых моделей.