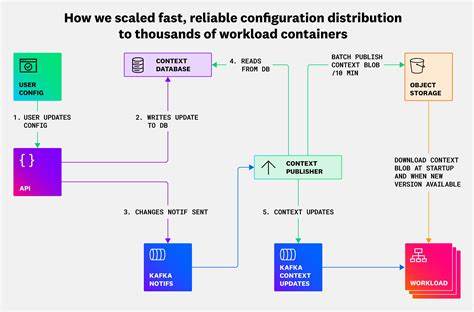

В современном мире облачных технологий и масштабируемых приложений эффективное управление конфигурациями становится одной из ключевых задач для обеспечения стабильной работы сервисов и высокой производительности. В частности, при работе с тысячами контейнеров рабочих нагрузок проблема быстрой и надёжной доставки конфигурационных данных приобретает особую значимость. Конфигурационные файлы и настройки влияют на обработку логов, безопасность, квоты на хранение данных и другие важные аспекты работы приложения. Как обеспечить, чтобы все контейнеры своевременно получали актуальные настройки, минимизировать задержки и исключить возможности сбоев? Рассмотрим детали и современные решения, которые помогли крупным облачным сервисам справиться с этой сложной задачей. Чем же сложна задача распространения конфигураций по масштабной системе контейнеров? С одной стороны, кажется, что это простая проблема — достаточно хранить параметры в базе данных и обеспечивать доступ к ней.

Однако на практике возникновение задержек и повышенная нагрузка на базу данных могут привести к существенным проблемам и нарушению пользовательского опыта. Например, когда пользователь меняет правило обработки логов через интерфейс, ожидается, что эти изменения сразу же начнут применяться к потокам данных. Низкая задержка обновлений — обязательное требование к системам обработки данных в реальном времени. При этом надёжность и устойчивость к сбоям не менее важны, так как конфигурации используются для обработки многопользовательских (multi-tenant) данных, и любые расхождения могут привести к нарушению целостности анализа и безопасности. Одним из первых интуитивных решений является подход, при котором контейнеры рабочих нагрузок загружают актуальную конфигурацию по запросу каждый раз, когда получают новую порцию данных.

Несмотря на простоту, этот метод оказывается непрактичным при масштабах, характерных для сервисов с сотнями тысяч обрабатываемых сообщений в секунду. Такая стратегия вызывает чрезмерное количество запросов к базе данных, вследствие чего она становится узким местом и риском отказа. С целью уменьшить нагрузку, часто применяют кэширование конфигураций внутри контейнеров с периодическим обновлением. Это снижает частоту обращений к источнику данных, но вводит задержку обновлений. Чем дольше настраивается период обновления кэша, тем дольше пользователи не увидят своих изменений в работе системы.

Кроме того, при очень большом числе контейнеров даже редкое обновление кэша создаёт значительный суммарный нагрузочный фон. Следующий этап эволюции подхода — это внедрение систем распределённых уведомлений о смене конфигураций, которые позволяют посылать события о необходимости обновить данные конкретному контейнеру. Например, использование топика системы сообщений, такой как Kafka, позволяет отправлять инвалидационные уведомления после смены значения в базе данных. Контейнеры, получив информацию об изменении, загружают обновлённую конфигурацию. Эта архитектура позволила значительно снизить нагрузку на базу данных и уменьшить задержки обновления настроек в рабочих нагрузках.

Однако при дальнейшем росте масштабов обнаружились новые ограничения. Во-первых, каждое рабочее пространство контейнера всё ещё было напрямую связано с базой данных, что при возрастании количества инстанций создавало колоссальный трафик и риски отказа. Во-вторых, невозможность гарантировать 100% доставку уведомлений в распределённой системе означала, что некоторые инстанции могли долго работать с устаревшими конфигурациями, рискуя нарушить корректность обработки данных и ухудшить пользовательский опыт. Кроме того, при запуске новых версий с холодным кэшем рабочие экземпляры инициировали резкий всплеск запросов к базе данных, создавая эффект распределённой атаки отказа в обслуживании и неспособность быстро масштабировать систему. Всё это стало сигналом к необходимости кардинального переосмысления архитектуры.

Ключевая идея нового подхода — это создание полностью автономной копии конфигурационного хранилища внутри каждого контейнера с последующей синхронизацией через эффективный механизм публикации изменений. В отличие от классического клиент-серверного подхода с постоянными запросами к базе данных, новая архитектура предлагает предварительно загружать большую часть конфигурационных данных одним большим снимком и хранить его локально. Обновления распространяются с помощью низкотрaфицируемой системы, посылающей только дельты (индивидуальные изменения) в каждый контейнер. Так каждое рабочее пространство получает собственную реплику конфигурации в удобном для быстрого чтения формате (например, на базе движка RocksDB), что снижает нагрузку на центральную базу, обеспечивает минимальные задержки и повышает устойчивость. При старте контейнера происходит загрузка полной базы конфигураций из облачного хранилища.

Данная операция считается критичной — контейнер считается готовым к приёму трафика лишь после успешной загрузки. В последующем отдельные обновления доставляются через систему сообщений и применяются к локальной базе, а также периодически обновляется полная база, чтобы гарантировать согласованное состояние. Такая схема позволяет работать с конфигурациями, даже если центральная база данных или слой обновления временно недоступны — контейнеры продолжают использовать последнюю загруженную версию, обеспечивая непрерывность сервиса. Низкая частота обновлений конфигурации (сотни или тысячи в сутки, а не тысячи в секунду) делает этот подход устойчивым и эффективным, так как трафик обновления очень низок. При этом локальная реплика обеспечивает молниеносный доступ к данным и высокую производительность обработки.

Важной частью проекта стала идея ограничения взаимодействия. Система, распространяющая конфигурации (context-publisher), полностью контролирует свой процесс и не может быть перегружена запросами извне. Отсутствие прямого доступа к ней исключает риск её перегрузки и сбоев. Такой дизайн полностью меняет парадигму распространения конфигурационных данных, делая процесс максимально предсказуемым и надёжным. Кроме того, внедрение этой технологии позволило расширить использование системы не только на задачи обработки логов, но и на другие сценарии управления состоянием рабочих нагрузок и уведомлений, такие как контроль квот, временная блокировка индексов и другие.

В конечном счёте, этот опыт показал, что глубокий анализ свойств и функционального объёма конфигурационных данных открыл возможности для непривычных и эффективных решений, которые были бы невозможны без полного понимания структуры и поведения данных. В целом, история создания и внедрения новой архитектуры распространения конфигураций демонстрирует важность масштабируемости, устойчивости и низкой задержки в современных инновационных облачных системах. Такие решения позволяют обрабатывать миллионы сообщений в секунду, работать с огромным числом клиентов и обеспечивать по-настоящему надёжный и быстрый отклик на пользовательские изменения. Этот пример представляет интерес как для специалистов в области инфраструктуры и архитектуры распределённых систем, так и для разработчиков, стремящихся создавать качественные и масштабируемые ПО. В будущем развитие систем контекстной загрузки и управления конфигурациями продолжится — планируется поддержка и расширение новых типов данных, внедрение более универсальных и мощных механизмов обновлений и интеграций, а также дополнительное повышение надёжности и масштабируемости сервисов.

Постоянный рост требований к производительности и отказоустойчивости заставляет инженеров искать всё более креативные и надёжные решения, делающие возможным поддержание качества на самом высоком уровне при колоссальных масштабах и нагрузках. Таким образом, для любой организации, работающей с контейнерами, микросервисами и распределёнными системами, важнейшим приоритетом является внедрение продуманных архитектурных подходов к управлению конфигурационными данными. Такая стратегия позволяет повысить скорость реакции на изменения, снизить нагрузку на критические компоненты и обеспечить непрерывность бизнес-процессов. В конечном итоге именно эти технические нововведения формируют фундамент успешного развития и конкурентоспособности современных облачных сервисов и платформ.

![Techniques to beat Arrays.hashCode(byte[]) using Java's own means](/images/7727AB36-84A3-4898-A7D5-F2D8D3AFE741)