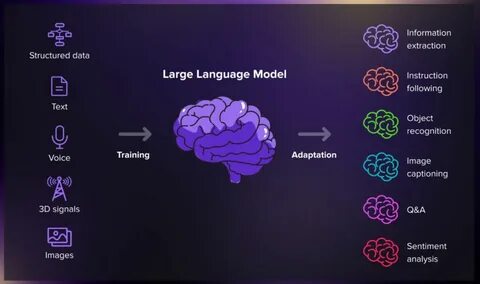

В последние годы большие языковые модели (Large Language Models, LLM) стали одним из самых прорывных достижений в области искусственного интеллекта. Несмотря на первоначальное восприятие их как своеобразных баз знаний, способных отвечать на вопросы за счет обширной предобученной информации, современные исследования показывают, что LLM можно рассматривать гораздо шире — не просто как базы данных, а как гибкие нейронные компьютеры с мощными вычислительными возможностями. Такой взгляд открывает новые горизонты в понимании искусственного интеллекта и его практического применения во множестве областей. Основная функция LLM заключается в предсказании следующего токена в тексте на основе предыдущего контекста. В отличие от классических баз данных, которые оперируют с жесткой структурой данных в виде строк и столбцов, LLM используют огромное количество весов — параметров нейронной сети, которые «запоминают» языковые закономерности и факты из данных, на основе которых модель обучалась.

Такая архитектура обеспечивает не только воспроизведение информации, но и генерацию новых текстов, причем с определенной степенью вероятности, что способствует разнообразию и креативности ответов. Однако у моделей есть ограничения, связанные с тем, что знания встроены в статичные веса, и данные устаревают со временем. Например, LLM не может самостоятельно сообщить текущую температуру на улице, если эти данные не были включены в тренировочный набор. Чтобы обойти эти ограничения, возникает концепция динамического доступа к информации, при котором модель не хранит весь объем данных сама, а получает актуальные сведения из внешних источников непосредственно в процессе диалога. Такой подход похож на систему виртуальной памяти в современных компьютерах, где информация подгружается в оперативную память по мере необходимости.

Использование Retrieval-Augmented Generation (RAG) позволяет комбинировать возможности LLM с базами данных и системами поиска, обеспечивая выбор самых релевантных данных, которые затем используются как часть входного контекста для генерации ответа. Для эффективного поиска используются векторные базы данных и эмбеддинги — низкоразмерные представления данных, которые позволяют находить семантически близкие элементы. Это существенно расширяет потенциал взаимодействия с большими объемами информации, делая ответы моделей более точными и актуальными. Динамическое подключение инструментов и сервисов становится еще одним важным аспектом расширения возможностей LLM. Под инструментами понимаются API, внешние функции и даже другие модели, которые может вызывать сама LLM в процессе формирования ответа.

Это значит, что модель может не только оперировать сохранёнными знаниями, но и напрямую взаимодействовать с реальными системами, выполнять вычисления, проверять данные или запрашивать их в режиме реального времени. Такой механизм значительно повышает надежность и точность ответа, избавляя модель от склонности к «галлюцинациям» — неосновательных или вымышленных утверждений. Для эффективного и безопасного взаимодействия LLM с внешними инструментами разработана концепция передачи переменных, при которой модель не оперирует реальными значениями, а работает с именами переменных, чьи значения хранятся и обрабатываются внутри управляющего движка. Такой подход исключает возможность перезаписи или искажения результатов вызова инструмента самим ИИ, что важно для создания надежных и предсказуемых систем. Это напоминает компьютерную архитектуру с регистровой моделью, где команды работают с именами регистров, а не с непосредственными значениями.

Интересно, что на этом подходе формируется представление о LLM как о новом типе нейронного компьютера, где сама модель выполняет роль центра управления и «прогнозиста» следующих инструкций, а набор внешних инструментов представляет собой множество операций, доступных этому компьютеру. Иными словами, LLM становится ядром сложной вычислительной системы, способной решать задачи с помощью цепочек вызовов и рассуждений. Для программирования и управления таким нейронным компьютером необходим особый язык, который сочетает в себе элементы логического программирования и естественного языка. Такой язык позволяет задавать цели, создавать правила и описывать взаимодействие с инструментами с помощью специальных синтаксических конструкций, при этом сохраняя читаемость и выразительность. Интересно, что он во многом напоминает классический язык Prolog, что подчеркивает тенденцию к объединению нейросетевых и символических методов искусственного интеллекта.

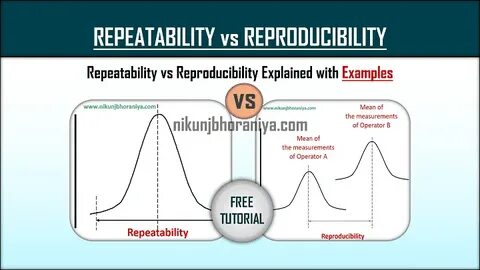

Безопасность и надежность систем, основанных на LLM, требуют новых подходов к проверке правильности работы. Здесь применяются методы формальных доказательств и проверки, когда написанный моделью код сопровождается доказательствами соблюдения заданных политик безопасности и корректности. Такая методология значительно снижает риски непредсказуемого поведения и упрощает аудит и контроль систем автономного ИИ, что особенно актуально в условиях появления всё более мощных и сложных моделей. Для повышения надежности работы с моделью и упрощения обработки ошибок используются идеи, схожие с деревом решений (Tree of Thought), где при возникновении ошибки или неясности алгоритм выполняет отладку и поиск альтернативных путей выполнения. Таким образом, система приобретает способность к самокоррекции и устойчивости к сбоям.

Современные исследования активно развивают концепцию LLM как нейронных компьютеров, что позволяет строить многоагентные системы, где несколько моделей и инструментов взаимодействуют и взаимодействуют, создавая сложные логические цепочки и обеспечивая широкий спектр применения — от автоматизации программирования и обработки естественного языка до интеграции с внешними корпоративными системами. Сравнение LLM с традиционными операционными системами позволяет взглянуть на них как на мощные универсальные платформы, где система управления памятью, планировщик задач и подсистемы ввода-вывода динамически работают вместе, обеспечивая эффективную обработку информации. Такое восприятие позволяет создавать уникальные архитектуры, где компоненты на базе ИИ не просто генераторы текста, а полноценные вычислительные узлы, способные решать сложные задачи в реальном времени. Таким образом, концепция использования больших языковых моделей как нейронных компьютеров меняет парадигму взаимодействия человека и машины, открывая путь к новым типам приложений и интеграции. Вместо пассивного поиска ответов модели становятся активными участниками вычислительного процесса, где они не только хранят знания, но и управляют вычислениями, внешними сервисами и логикой решения.